您好,登录后才能下订单哦!

这篇文章主要介绍在单机环境下Spark History Server如何配置,文中介绍的非常详细,具有一定的参考价值,感兴趣的小伙伴们一定要看完!

首先修改两个配置文件

vim spark-env.sh

export SPARK_MASTER_IP=***.***.***.*** export SPARK_HISTORY_OPTS="-Dspark.history.ui.port=18080 -Dspark.history.retainedApplications=10 -Dspark.history.fs.logDirectory=file:///home/zzx/spark-1.1.0-bin-hadoop1/historylogs" export SPARK_CONF_DIR=/home/zzx/spark-1.1.0-bin-hadoop1/conf

vim spark-defaults.conf

spark.eventLog.enabled true spark.eventLog.dir file:///home/zzx/spark-1.1.0-bin-hadoop1/historylogs spark.history.fs.logDirectory file:///home/zzx/spark-1.1.0-bin-hadoop1/historylogs

配置完后记得source一下 这里文件路径原本是HDFS路径 但是在后面测试过程中无论运行多少次程序,History Server页面一直是空白状态,后面改成本地文本路径就行了

然后启动spark,以及Spark History Server

sbin/start-all.sh sbin/start-history-server.sh

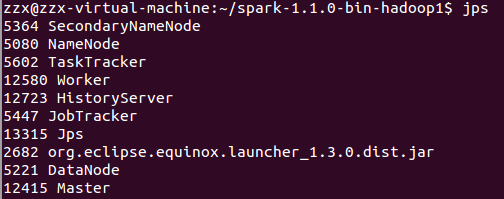

jps查看状态

在CLI命令行界面测试运行spark自带的例子SparkPi

bin/run-example SparkPi

运行多次程序后,根据SPARK_MASTER_IP加上端口号18080即可访问页面

在eclipse运行程序的时候,记得加上一段代码,因为eclipse提交程序不像CLI会查看spark的conf文件,所以这里需要手动加入,注意程序最后记得关闭sc,如下:

val conf = new SparkConf().setAppName("SparkWordCount")

.setMaster("local")

.set("spark.eventLog.enabled","true")

.set("spark.eventLog.dir","/home/zzx/spark-1.1.0-bin-hadoop1/historylogs")

val sc = new SparkContext(conf) //设置sc

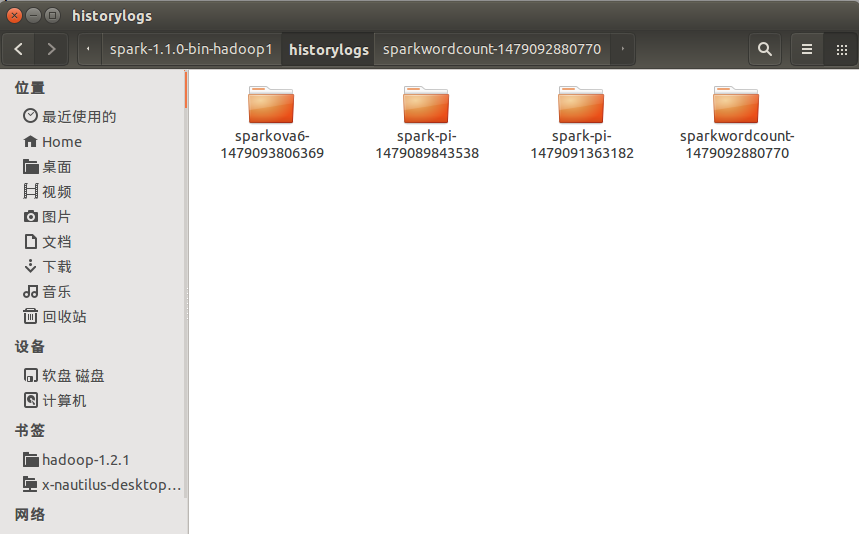

sc.stop //关闭sc在配置的文件路径下也可以查看到历史记录信息:

以上是“在单机环境下Spark History Server如何配置”这篇文章的所有内容,感谢各位的阅读!希望分享的内容对大家有帮助,更多相关知识,欢迎关注亿速云行业资讯频道!

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。