您好,登录后才能下订单哦!

Spark运行架构的特点及优势是什么,相信很多没有经验的人对此束手无策,为此本文总结了问题出现的原因和解决方法,通过这篇文章希望你能解决这个问题。

Spark作为一种分布式的计算框架,类似于大数据开发中Hadoop生态圈的MapReduce,计算思想和MR非常相似,两者都是分而治之的思想,但使用率要比MR高很多。下面整理了关于Spark运行架构的大数据面试题,内容包括Spark运行的基本流程、架构特点、优势。

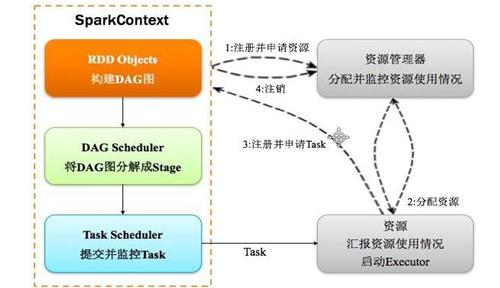

1、Spark 运行基本流程:

(1)构建 Spark Application 的运行环境(启动 SparkContext),SparkContext 向资源管理器(可以是 Standalone、Mesos 或 YARN)注册并申请运行 Executor 资源;

(2)资源管理器分配 Executor 资源并启动 Executor,Executor 运行情况将随着心跳发送到资源管理器上;

(3)SparkContext 构建成 DAG 图,将 DAG 图分解成 Stage,并把 Taskset发送给 Task Scheduler。Executor 向 SparkContext 申请 Task,Task Scheduler 将Task 发放给 Executor 运行同时 SparkContext 将应用程序代码发放给 Executor。

(4)Task 在 Executor 上运行,运行完毕释放所有资源。

2、Spark 运行架构特点:

(1)每个 Application 获取专属的 executor进程,该进程在 Application 期间一直驻留,并以多线程方式运行 tasks。

(2)Spark 任务与资源管理器无关,只要能够获取 executor 进程,并能保持相互通信就可以了。

(3)提交 SparkContext 的 Client 应该靠近 Worker 节点(运行 Executor 的节点),最好是在同一个 Rack 里,因为 Spark 程序运行过程中 SparkContext 和Executor 之间有大量的信息交换;如果想在远程集群中运行,最好使用 RPC 将SparkContext 提交给集群,不要远离 Worker 运行 SparkContext。

(4)Task 采用了数据本地性和推测执行的优化机制。

3、Spark的优势:

(1)计算效率高

资源复用;粗粒度的资源调度。

(2)使用方便

支持使用多门语言来编写;提供了超过80多种方法来供我们使用。

(3)通用性强

Spark生态圈中的组件都是基于SparkCore封装起来的。

(4)适应性强

可以接受上百种数据源;可以运行在各种各样的资源调度框架上。

看完上述内容,你们掌握Spark运行架构的特点及优势是什么的方法了吗?如果还想学到更多技能或想了解更多相关内容,欢迎关注亿速云行业资讯频道,感谢各位的阅读!

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。