жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

еҶ…е®№иҰҒзӮ№

дёҖгҖҒGlusterFS з®Җд»Ӣпјҡ

дәҢгҖҒGlusterFS зҡ„еҚ·зұ»еһӢпјҡ

дёүгҖҒGlusterFS йғЁзҪІпјҡ

第дёҖжӯҘпјҡе…Ҳе°ҶжҜҸеҸ°иҷҡжӢҹжңәзҡ„еҗ„дёӘзЈҒзӣҳжҢӮиҪҪеҘҪпјҢж–№дҫҝж“ҚдҪңпјҢеҸҜд»ҘдҪҝз”Ёд»ҘдёӢи„ҡжң¬

第дәҢжӯҘпјҡеңЁеӣӣеҸ° node иҠӮзӮ№дёҠзҡ„ж“ҚдҪң

第дёүжӯҘпјҡж—¶й—ҙеҗҢжӯҘ

第дә”жӯҘпјҡGlusterFS еҚ·зҡ„еҲӣе»ә

第е…ӯжӯҘпјҡе®ўжҲ·з«Ҝй…ҚзҪ®

第дёғжӯҘпјҡжөӢиҜ•

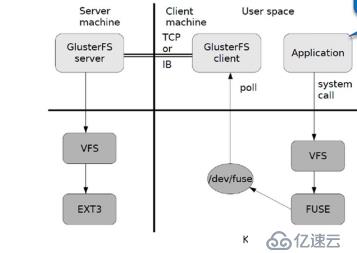

дёҖгҖҒGlusterFS з®Җд»Ӣпјҡ

GFSжҳҜдёҖдёӘеҸҜжү©еұ•зҡ„еҲҶеёғејҸж–Ү件系з»ҹпјҢз”ЁдәҺеӨ§еһӢзҡ„гҖҒеҲҶеёғејҸзҡ„гҖҒеҜ№еӨ§йҮҸж•°жҚ®иҝӣиЎҢи®ҝй—®зҡ„еә”з”ЁгҖӮе®ғиҝҗиЎҢдәҺе»үд»·зҡ„жҷ®йҖҡ硬件дёҠпјҢ并жҸҗдҫӣе®№й”ҷеҠҹиғҪгҖӮе®ғеҸҜд»Ҙз»ҷеӨ§йҮҸзҡ„з”ЁжҲ·жҸҗдҫӣжҖ»дҪ“жҖ§иғҪиҫғй«ҳзҡ„жңҚеҠЎгҖӮ

ејҖжәҗзҡ„еҲҶеёғејҸж–Ү件系з»ҹпјӣ

з”ұеӯҳеӮЁжңҚеҠЎеҷЁгҖҒе®ўжҲ·з«Ҝд»ҘеҸҠ NFS/Samba еӯҳеӮЁзҪ‘е…із»„жҲҗпјӣ

пјҲ1пјүGlusterFS зү№зӮ№пјҡ

жү©еұ•жҖ§е’Ңй«ҳжҖ§иғҪпјӣ

й«ҳеҸҜз”ЁжҖ§пјӣ

е…ЁеұҖз»ҹдёҖе‘ҪеҗҚз©әй—ҙпјӣ

еј№жҖ§еҚ·з®ЎзҗҶпјӣ

еҹәдәҺж ҮеҮҶеҚҸи®®

пјҲ2пјүжЁЎеқ—еҢ–е Ҷж Ҳжһ¶жһ„пјҡ

1гҖҒжЁЎеқ—еҢ–пјҢе Ҷж ҲејҸз»“жһ„пјӣ

2гҖҒйҖҡиҝҮеҜ№жЁЎеқ—зҡ„з»„еҗҲпјҢе®һзҺ°еӨҚжқӮзҡ„еҠҹиғҪпјӣ

3гҖҒGlusterFS е·ҘдҪңжөҒзЁӢпјҡ

4гҖҒеј№жҖ§ HASH з®—жі•пјҡ

йҖҡиҝҮ HASH з®—жі•еҫ—еҲ°дёҖдёӘ32дҪҚзҡ„ж•ҙж•°пјӣ

еҲ’еҲҶдёә N дёӘиҝһжҺҘзҡ„еӯҗз©әй—ҙпјҢжҜҸдёӘз©әй—ҙеҜ№еә”дёҖдёӘ Brickпјӣ

еј№жҖ§ HASH з®—жі•зҡ„дјҳзӮ№пјҡ

дҝқиҜҒж•°жҚ®е№іеқҮеҲҶеёғеңЁжҜҸдёҖдёӘ Brick дёӯпјӣ

и§ЈеҶідәҶеҜ№е…ғж•°жҚ®жңҚеҠЎеҷЁзҡ„дҫқиө–пјҢиҝӣиҖҢи§ЈеҶідәҶеҚ•зӮ№ж•…йҡңд»ҘеҸҠжңҚи®ҝ问瓶йўҲгҖӮ

дәҢгҖҒGlusterFS зҡ„еҚ·зұ»еһӢпјҡ

пјҲ1пјүеҲҶеёғејҸеҚ·пјҡ

жІЎжңүеҜ№ж–Ү件иҝӣиЎҢеҲҶеқ—еӨ„зҗҶпјӣ

йҖҡиҝҮжү©еұ•ж–Ү件еұһжҖ§дҝқеӯҳ HASHеҖјпјӣ

ж”ҜжҢҒзҡ„еә•еұӮж–Ү件系з»ҹжңү ext3 гҖҒext4 гҖҒZFS гҖҒXFSзӯү

зү№зӮ№пјҡ

ж–Ү件еҲҶеёғеңЁдёҚеҗҢзҡ„жңҚеҠЎеҷЁпјҢдёҚе…·еӨҮеҶ—дҪҷжҖ§пјӣ

жӣҙе®№жҳ“е’Ңе»үд»·ең°жү©еұ•еҚ·зҡ„еӨ§е°Ҹпјӣ

еҚ•зӮ№ж•…йҡңдјҡйҖ жҲҗж•°жҚ®дёўеӨұпјӣ

дҫқиө–еә•еұӮзҡ„ж•°жҚ®дҝқжҠӨгҖӮ

пјҲ2пјүжқЎеёҰеҚ·пјҡ

ж №жҚ®еҒҸ移йҮҸе°Ҷж–Ү件еҲҶдёә N еқ—пјҲNдёӘжқЎеёҰиҠӮзӮ№пјүпјҢиҪ®иҜўзҡ„еӯҳеӮЁеңЁжҜҸдёӘ Brick Server иҠӮзӮ№пјӣ

еӯҳеӮЁеӨ§ж–Ү件时пјҢжҖ§иғҪе°ӨдёәзӘҒеҮәпјӣ

дёҚе…·еӨҮеҶ—дҪҷжҖ§пјҢзұ»дјј raid0

зү№зӮ№пјҡ

ж•°жҚ®иў«еҲҶеүІжҲҗжӣҙе°Ҹеқ—еҲҶеёғеҲ°еқ—жңҚеҠЎеҷЁзҫӨдёӯзҡ„дёҚеҗҢжқЎеёҰеҢәпјӣ

еҲҶеёғеҮҸе°‘дәҶиҙҹиҪҪдё”жӣҙе°Ҹзҡ„ж–Ү件еҠ йҖҹдәҶеӯҳеҸ–зҡ„йҖҹеәҰпјӣ

жІЎжңүж•°жҚ®еҶ—дҪҷ

пјҲ3пјүеӨҚеҲ¶еҚ·пјҡ

еҗҢдёҖдёӘж–Ү件дҝқеӯҳдёҖд»ҪжҲ–еӨҡеҲҶеүҜжң¬пјӣ

еӨҚеҲ¶жЁЎејҸеӣ дёәиҰҒдҝқеӯҳеүҜжң¬пјҢжүҖд»ҘзЈҒзӣҳеҲ©з”ЁзҺҮиҫғдҪҺпјӣ

еӨҡдёӘиҠӮзӮ№дёҠзҡ„еӯҳеӮЁз©әй—ҙдёҚдёҖиҮҙпјҢйӮЈд№Ҳе°Ҷе®үиЈ…жңЁжЎ¶ж•Ҳеә”еҸ–жңҖдҪҺиҠӮзӮ№зҡ„е®№йҮҸдҪңдёәиҜҘеҚ·зҡ„жҖ»е®№йҮҸ

зү№зӮ№пјҡ

еҚ·дёӯжүҖжңүзҡ„жңҚеҠЎеҷЁеқҮдҝқеӯҳдёҖдёӘе®Ңж•ҙзҡ„еүҜжң¬пјӣ

еҚ·зҡ„еүҜжң¬ж•°йҮҸеҸҜз”ұе®ўжҲ·еҲӣе»әзҡ„ж—¶еҖҷеҶіе®ҡпјӣ

иҮіе°‘з”ұдёӨдёӘеқ—жңҚеҠЎеҷЁжҲ–жӣҙеӨҡжңҚеҠЎеҷЁпјӣ

е…·еӨҮе®№зҒҫжҖ§гҖӮ

пјҲ4пјүеҲҶеёғејҸжқЎеёҰеҚ·пјҡ

е…јйЎҫеҲҶеёғејҸе’ҢжқЎеёҰеҚ·зҡ„еҠҹиғҪпјӣ

дё»иҰҒз”ЁдәҺеӨ§ж–Ү件и®ҝй—®еӨ„зҗҶпјӣ

иҮіе°‘жңҖе°‘йңҖиҰҒ 4 еҸ°жңҚеҠЎеҷЁгҖӮ

пјҲ5пјүеҲҶеёғејҸеӨҚеҲ¶еҚ·пјҡ

е…јйЎҫеҲҶеёғејҸеҚ·е’ҢеӨҚеҲ¶еҚ·зҡ„еҠҹиғҪпјӣ

з”ЁдәҺйңҖиҰҒеҶ—дҪҷзҡ„жғ…еҶөдёӢ

дёүгҖҒGlusterFS йғЁзҪІпјҡ

зҺҜеўғеҮҶеӨҮпјҡ

дә”еҸ°иҷҡжӢҹжңәпјҢдёҖеҸ°дҪңдёәе®ўжҲ·з«ҜпјҢеҸҰеӨ–еӣӣеҸ°дҪңдёәиҠӮзӮ№пјҢжҜҸдёӘиҷҡжӢҹжңәж–°еўһ4еқ—зЈҒзӣҳпјҲжҜҸдёӘ20GеӨ§е°Ҹе°ұеҸҜд»ҘдәҶпјү

| и§’иүІ | з©әй—ҙеӨ§е°Ҹ |

| node1пјҲ192.168.220.172пјү | 80GпјҲ20GГ—4пјү |

| node2пјҲ192.168.220.131пјү | 80GпјҲ20GГ—4пјү |

| node3пјҲ192.168.220.140пјү | 80GпјҲ20GГ—4пјү |

| node4пјҲ192.168.220.136пјү | 80GпјҲ20GГ—4пјү |

| е®ўжҲ·з«ҜпјҲ192.168.220.137пјү | 80GпјҲ20GГ—4пјү |

第дёҖжӯҘпјҡе…Ҳе°ҶжҜҸеҸ°иҷҡжӢҹжңәзҡ„еҗ„дёӘзЈҒзӣҳжҢӮиҪҪеҘҪпјҢж–№дҫҝж“ҚдҪңпјҢеҸҜд»ҘдҪҝз”Ёд»ҘдёӢи„ҡжң¬

vimВ disk.shВ //жҢӮиҪҪзЈҒзӣҳи„ҡжң¬пјҢдёҖй”®ж“ҚдҪң

#!В /bin/bash

echoВ "theВ disksВ existВ list:"

fdiskВ -lВ |grepВ 'зЈҒзӣҳВ /dev/sd[a-z]'

echoВ "=================================================="

PS3="choseВ whichВ diskВ youВ wantВ toВ create:"

selectВ VARВ inВ `lsВ /dev/sd*|grepВ -oВ 'sd[b-z]'|uniq`В quit

do

В В В В caseВ $VARВ in

В В В В sda)

В В В В В В В В fdiskВ -lВ /dev/sda

В В В В В В В В breakВ ;;

В В В В sd[b-z])

В В В В В В В В #createВ partitions

В В В В В В В В echoВ "n

В В В В В В В В В В В В В В В В p

В В В В В В В В В В В В В В В В

В В В В В В В В В В В В В В В В

В В В В В В В В В В В

В В В В В В В В В В В В В В В В w"В В |В fdiskВ /dev/$VAR

В В В В В В В В #makeВ filesystem

В В В В В В В В mkfs.xfsВ -iВ size=512В /dev/${VAR}"1"В &>В /dev/null

#mountВ theВ system

В В В В В В В В mkdirВ -pВ /data/${VAR}"1"В &>В /dev/null

В В В В В В В В echoВ -eВ "/dev/${VAR}"1"В /data/${VAR}"1"В xfsВ defaultsВ 0В 0\n"В >>В /etc/fstab

В В В В В В В В mountВ -aВ &>В /dev/null

В В В В В В В В breakВ ;;

В В В В quit)

В В В В В В В В break;;

В В В В *)

В В В В В В В В echoВ "wrongВ disk,pleaseВ checkВ again";;

В В В В esac

done第дәҢжӯҘпјҡеңЁеӣӣеҸ° node иҠӮзӮ№дёҠзҡ„ж“ҚдҪң

пјҲ1пјүдҝ®ж”№дё»жңәеҗҚпјҲnode1гҖҒnode2гҖҒnode3гҖҒnode4пјүпјҢ并关й—ӯйҳІзҒ«еўҷзӯүгҖӮ

hostnamectlВ set-hostnameВ node1 hostnamectlВ set-hostnameВ node2 hostnamectlВ set-hostnameВ node3 hostnamectlВ set-hostnameВ node4

пјҲ2пјүзј–иҫ‘ hosts ж–Ү件пјҢж·»еҠ дё»жңәеҗҚе’Ң IPең°еқҖпјҡ

vimВ /etc/hostsВ #жң«иЎҢжҸ’е…Ҙ 192.168.220.172В node1 192.168.220.131В node2 192.168.220.140В node3 192.168.220.136В node4

пјҲ3пјүзј–еҶҷ yum жәҗзҡ„еә“пјҢе®үиЈ… GlusterFS пјҡ

cdВ /opt/ mkdirВ /abc mount.cifsВ //192.168.10.157/MHAВ /abcВ В В //иҝңзЁӢжҢӮиҪҪеҲ°жң¬ең° cdВ /etc/yum.repos.d/ mkdirВ bakВ В mvВ Cent*В bak/В В В //е°ҶеҺҹжқҘзҡ„жәҗйғҪ移еҲ°ж–°е»әзҡ„ж–Ү件еӨ№дёӯ vimВ GLFS.repoВ В В //ж–°е»әдёҖдёӘжәҗ [GLFS] name=glfs baseurl=file:///abc/gfsrepo gpgcheck=0 enabled=1

пјҲ4пјүе®үиЈ…иҪҜ件еҢ…пјҡ

yumВ -yВ installВ glusterfsВ glusterfs-serverВ glusterfs-fuseВ glusterfs-rdma

пјҲ5пјүејҖеҗҜжңҚеҠЎпјҡ

systemctlВ startВ glusterd systemctlВ statusВ glusterd

第дёүжӯҘпјҡж—¶й—ҙеҗҢжӯҘ

ntpdateВ ntp1.aliyun.comВ В В //ж—¶й—ҙеҗҢжӯҘпјҲжҜҸеҸ°иҠӮзӮ№йғҪйңҖиҰҒж“ҚдҪңпјү

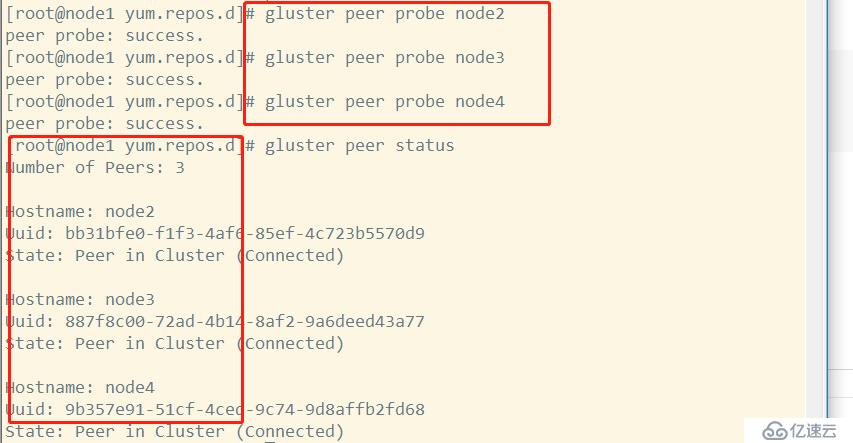

ж·»еҠ еӯҳеӮЁдҝЎд»»жұ пјҢеҸӘиҰҒеңЁдёҖеҸ°дё»жңәдёҠж·»еҠ е…¶д»–дёүеҸ°иҠӮзӮ№еҚіеҸҜпјҡ

иҝҷжҳҜеңЁ node1 иҠӮзӮ№дёҠзҡ„ж“ҚдҪңпјҡ

glusterВ peerВ probeВ node2 glusterВ peerВ probeВ node3 glusterВ peerВ probeВ node4 glusterВ peerВ statusВ //жҹҘзңӢжүҖжңүиҠӮзӮ№зҠ¶жҖҒ

第дә”жӯҘпјҡGlusterFS еҚ·зҡ„еҲӣе»ә

пјҲ1пјүеҲӣе»әеҲҶеёғејҸеҚ·пјҡ

glusterВ volumeВ createВ dis-volВ node1:/data/sdb1В node2:/data/sdb1В force В В //еҲ©з”Ёnode1е’Ңnode2дёҠзҡ„дёӨеқ—зЈҒзӣҳеҲӣе»әпјӣdis-volдёәзЈҒзӣҳеҗҚпјӣforceиЎЁзӨәејәеҲ¶ В В В В В glusterВ volumeВ startВ dis-volВ В В В //еҗҜеҠЁ glusterВ volumeВ infoВ dis-volВ В В В В //жҹҘзңӢзҠ¶жҖҒ

пјҲ2пјүеҲӣе»әжқЎеёҰеҚ·пјҡ

glusterВ volumeВ createВ stripe-volВ stripeВ 2В node1:/data/sdc1В node2:/data/sdc1В force glusterВ volumeВ startВ stripe-vol glusterВ volumeВ infoВ stripe-vol

пјҲ3пјүеҲӣе»әеӨҚеҲ¶еҚ·пјҡ

glusterВ volumeВ createВ rep-volВ replicaВ 2В node3:/data/sdb1В node4:/data/sdb1В force glusterВ volumeВ startВ rep-vol glusterВ volumeВ infoВ rep-vol

пјҲ4пјүеҲӣе»әеҲҶеёғејҸжқЎеёҰеҚ·пјҲиҮіе°‘4дёӘиҠӮзӮ№пјүпјҡ

glusterВ volumeВ createВ dis-stripeВ stripeВ 2В node1:/data/sdd1В node2:/data/sdd1В node3:/data/sdd1В node4:/data/sdd1В force glusterВ volumeВ startВ dis-stripe glusterВ volumeВ infoВ dis-stripe

пјҲ5пјүеҲӣе»әеҲҶеёғејҸеӨҚеҲ¶еҚ·пјҲиҮіе°‘4дёӘиҠӮзӮ№пјүпјҡ

glusterВ volumeВ createВ dis-repВ replicaВ 2В node1:/data/sde1В node2:/data/sde1В node3:/data/sde1В node4:/data/sde1В force glusterВ volumeВ startВ dis-rep glusterВ volumeВ infoВ dis-rep

第е…ӯжӯҘпјҡе®ўжҲ·з«Ҝй…ҚзҪ®

пјҲ1пјүе…ій—ӯйҳІзҒ«еўҷ

systemctlВ stopВ firewalld setenforceВ 0

пјҲ2пјүй…ҚзҪ®е®үиЈ… GFS жәҗпјҡ

cdВ /opt/ mkdirВ /abc mount.cifsВ //192.168.10.157/MHAВ /abcВ В В //иҝңзЁӢжҢӮиҪҪеҲ°жң¬ең° cdВ /etc/yum.repos.d/ vimВ GLFS.repoВ В В //ж–°е»әдёҖдёӘжәҗ [GLFS] name=glfs baseurl=file:///abc/gfsrepo gpgcheck=0 enabled=1

yumВ -yВ installВ glusterfsВ glusterfs-fuseВ В В //е®үиЈ…иҪҜ件еҢ…

пјҲ3пјүдҝ®ж”№ hostsж–Ү件пјҡ

vimВ /etc/hosts 192.168.220.172В node1 192.168.220.131В node2 192.168.220.140В node3 192.168.220.136В node4

пјҲ4пјүеҲӣе»әдёҙж—¶жҢӮиҪҪзӮ№пјҡ

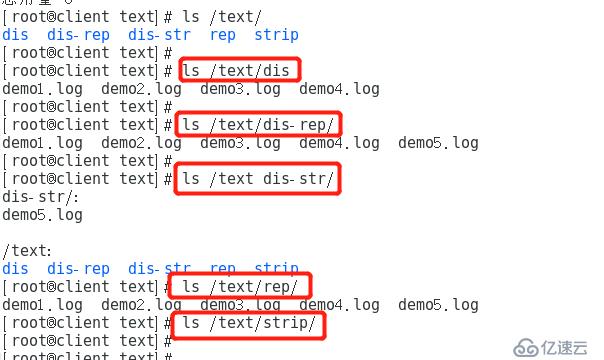

mkdirВ -pВ /text/disВ В В //йҖ’еҪ’еҲӣе»әдёҖдёӘжҢӮиҪҪзӮ№ mount.glusterfsВ node1:dis-volВ /text/dis/В В В В В В В В В //жҢӮиҪҪеҲҶеёғејҸеҚ· mkdirВ /text/strip mount.glusterfsВ node1:stripe-volВ /text/strip/В В В В В //жҢӮиҪҪжқЎеёҰеҚ· mkdirВ /text/rep mount.glusterfsВ node3:rep-volВ /text/rep/В В В В В В В В В В //жҢӮиҪҪеӨҚеҲ¶еҚ· mkdirВ /text/dis-str mount.glusterfsВ node2:dis-stripeВ /text/dis-str/В В В В //жҢӮиҪҪеҲҶеёғејҸжқЎеёҰеҚ· mkdirВ /text/dis-rep mount.glusterfsВ node4:dis-repВ /text/dis-rep/В В В В В В В В //жҢӮиҪҪеҲҶеёғејҸеӨҚеҲ¶еҚ·

df-hTпјҡжҹҘзңӢжҢӮиҪҪдҝЎжҒҜпјҡ

第дёғжӯҘпјҡжөӢиҜ•

пјҲ1пјүеҲӣе»ә 5 дёӘ40M зҡ„ж–Ү件пјҡ

ddВ if=/dev/zeroВ of=/demo1.logВ bs=1MВ count=40 ddВ if=/dev/zeroВ of=/demo2.logВ bs=1MВ count=40 ddВ if=/dev/zeroВ of=/demo3.logВ bs=1MВ count=40 ddВ if=/dev/zeroВ of=/demo4.logВ bs=1MВ count=40 ddВ if=/dev/zeroВ of=/demo5.logВ bs=1MВ count=40

пјҲ2пјүжҠҠеҲҡеҲҡеҲӣе»әзҡ„ 5 дёӘж–Ү件еҲҶеҲ«еӨҚеҲ¶еҲ°дёҚеҗҢзҡ„еҚ·дёҠпјҡ

cpВ /demo*В /text/dis cpВ /demo*В /text/strip cpВ /demo*В /text/rep/ cpВ /demo*В /text/dis-str cpВ /demo*В /text/dis-rep

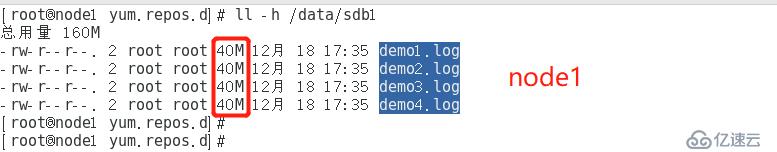

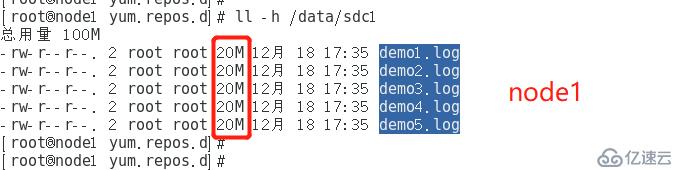

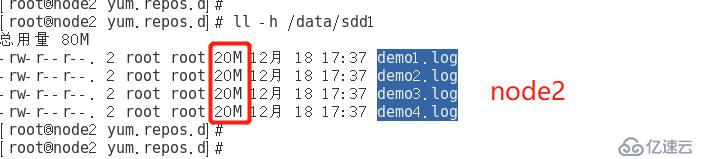

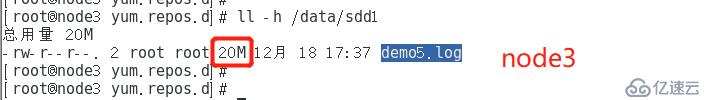

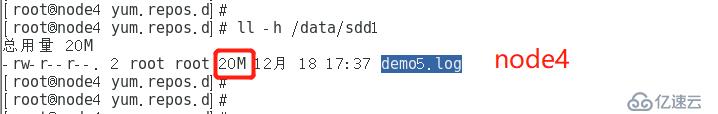

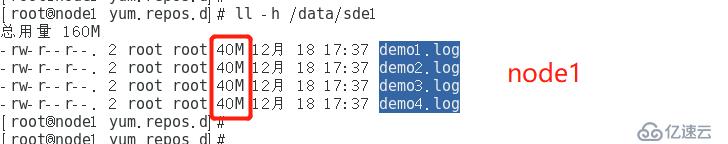

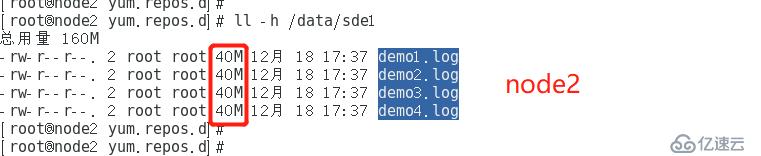

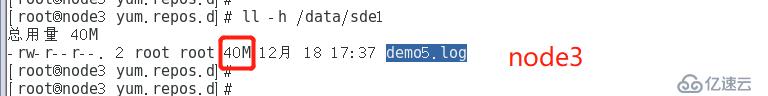

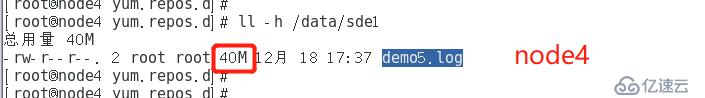

пјҲ3пјүжҹҘзңӢеҗ„дёӘеҚ·жҳҜеҰӮдҪ•еҲҶеёғзҡ„пјҡll -h /data/sdb1

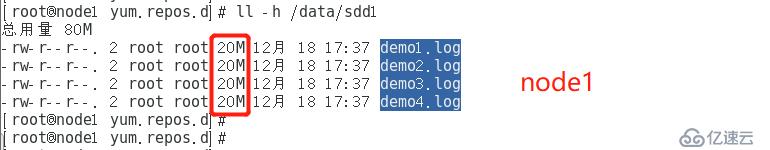

1гҖҒеҲҶеёғејҸеҚ·пјҡ

еҸҜд»ҘзңӢеҮәйғҪжҳҜжҜҸдёӘж–Ү件йғҪжҳҜе®Ңж•ҙзҡ„гҖӮ

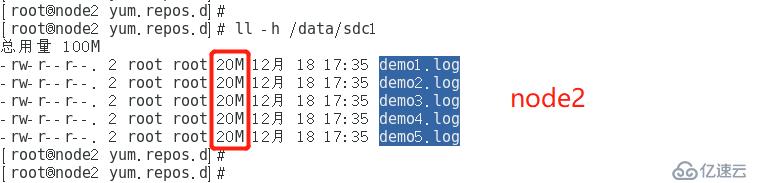

2гҖҒжқЎеёҰеҚ·пјҡ

жүҖжңүж–Ү件йғҪиў«еҲҶжҲҗеҗ„дёҖеҚҠиҝӣиЎҢеҲҶеёғеӯҳеӮЁгҖӮ

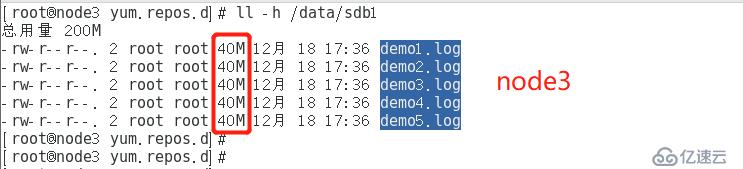

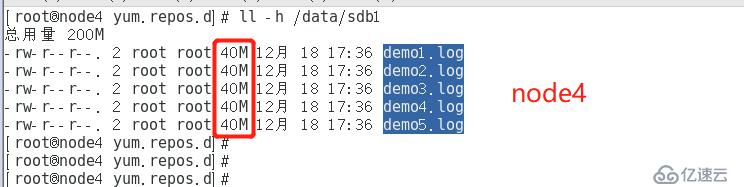

3гҖҒеӨҚеҲ¶еҚ·пјҡ

жүҖжңүж–Ү件йғҪиў«е®Ңж•ҙеӨҚеҲ¶дёҖйҒҚпјҢиҝӣиЎҢеӯҳеӮЁгҖӮ

4гҖҒеҲҶеёғејҸжқЎеёҰеҚ·пјҡ

5гҖҒеҲҶеёғејҸеӨҚеҲ¶еҚ·пјҡ

пјҲ4пјүж•…йҡңз ҙеқҸжөӢиҜ•пјҡ

зҺ°еңЁе…ій—ӯ第дәҢеҸ°иҠӮзӮ№жңҚеҠЎеҷЁпјҢжЁЎжӢҹе®•жңәпјӣеҶҚеңЁе®ўжҲ·жңәдёҠжҹҘзңӢеҗ„дёӘеҚ·зҡ„жғ…еҶөпјҡ

еҸҜд»ҘеҸ‘зҺ°пјҡ

еҲҶеёғејҸеҚ·жүҖжңүж–Ү件йғҪеңЁпјӣ

еӨҚеҲ¶еҚ·жүҖжңүж–Ү件йғҪеңЁпјӣ

жҢӮиҪҪеҲҶеёғејҸжқЎеёҰеҚ·еҸӘжңү demo5.log дёҖдёӘж–Ү件дәҶпјҢдёўеӨұдәҶ4дёӘпјӣ

жҢӮиҪҪеҲҶеёғејҸеӨҚеҲ¶еҚ·жүҖжңүж–Ү件йғҪеңЁпјӣ

жқЎеёҰеҚ·жүҖжңүж–Ү件йғҪдёўеӨұдәҶгҖӮ

пјҲ5пјүе…¶д»–ж“ҚдҪңпјҡ

1гҖҒеҲ йҷӨеҚ·пјҲе…ҲеҒңжӯўпјҢеҶҚеҲ йҷӨпјүпјҡ

glusterВ volumeВ stopВ еҚ·еҗҚ glusterВ volumeВ deleteВ еҚ·еҗҚ

2гҖҒй»‘зҷҪеҗҚеҚ•и®ҫзҪ®пјҡ

glusterВ volumeВ setВ еҚ·еҗҚВ auth.rejectВ 192.168.220.100В В В В В //жӢ’з»қжҹҗеҸ°дё»жңәжҢӮиҪҪ glusterВ volumeВ setВ еҚ·еҗҚВ auth.allowВ 192.168.220.100В В В В В В //е…Ғи®ёжҹҗеҸ°дё»жңәжҢӮиҪҪ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ