жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

иҝҷзҜҮж–Үз« з»ҷеӨ§е®¶еҲҶдә«зҡ„жҳҜжңүе…іTensorflowеҲҶеёғејҸ并иЎҢзӯ–з•Ҙзҡ„зӨәдҫӢеҲҶжһҗзҡ„еҶ…е®№гҖӮе°Ҹзј–и§үеҫ—жҢәе®һз”Ёзҡ„пјҢеӣ жӯӨеҲҶдә«з»ҷеӨ§е®¶еҒҡдёӘеҸӮиҖғпјҢдёҖиө·и·ҹйҡҸе°Ҹзј–иҝҮжқҘзңӢзңӢеҗ§гҖӮ

tensorFlowдёӯдё»иҰҒеҢ…жӢ¬дәҶдёүз§ҚдёҚеҗҢзҡ„并иЎҢзӯ–з•ҘпјҢе…¶еҲҶеҲ«жҳҜж•°жҚ®е№¶иЎҢгҖҒжЁЎеһӢ并иЎҢгҖҒжЁЎеһӢи®Ўз®—жөҒж°ҙзәҝ并иЎҢпјҢе…·дҪ“еҸӮиҖғTenssorflowзҷҪзҡ®д№ҰпјҢеңЁжҺҘдёӢжқҘеҲҶеҲ«з®ҖеҚ•д»Ӣз»Қдёүз§Қ并иЎҢзӯ–з•Ҙзҡ„еҺҹзҗҶгҖӮ

ж•°жҚ®е№¶иЎҢ

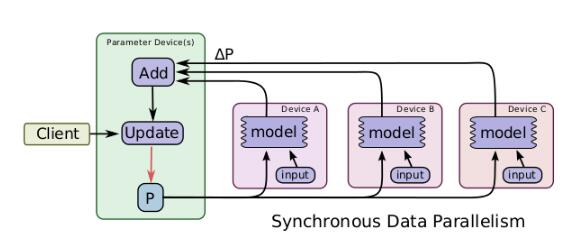

дёҖдёӘз®ҖеҚ•зҡ„еҠ йҖҹи®ӯз»ғзҡ„жҠҖжңҜжҳҜ并иЎҢең°и®Ўз®—жўҜеәҰпјҢ然еҗҺжӣҙж–°зӣёеә”зҡ„еҸӮж•°гҖӮж•°жҚ®е№¶иЎҢеҸҲеҸҜд»Ҙж №жҚ®е…¶жӣҙж–°еҸӮж•°зҡ„ж–№ејҸеҲҶдёәеҗҢжӯҘж•°жҚ®е№¶иЎҢе’ҢејӮжӯҘж•°жҚ®е№¶иЎҢпјҢеҗҢжӯҘзҡ„ж•°жҚ®е№¶иЎҢж–№ејҸеҰӮеӣҫжүҖзӨәпјҢtensorflowеӣҫжңүзқҖеҫҲеӨҡзҡ„йғЁеҲҶеӣҫжЁЎеһӢи®Ўз®—еүҜжң¬пјҢеҚ•дёҖзҡ„е®ўжҲ·з«ҜзәҝзЁӢй©ұеҠЁж•ҙдёӘи®ӯз»ғеӣҫпјҢжқҘиҮӘдёҚеҗҢзҡ„и®ҫеӨҮзҡ„ж•°жҚ®йңҖиҰҒиҝӣиЎҢеҗҢжӯҘжӣҙж–°гҖӮиҝҷз§Қж–№ејҸеңЁе®һзҺ°ж—¶пјҢдё»иҰҒзҡ„йҷҗеҲ¶е°ұжҳҜжҜҸдёҖж¬Ўжӣҙж–°йғҪжҳҜеҗҢжӯҘзҡ„пјҢе…¶ж•ҙдҪ“и®Ўз®—ж—¶й—ҙеҸ–еҶідәҺжҖ§иғҪжңҖе·®зҡ„йӮЈдёӘи®ҫеӨҮгҖӮ

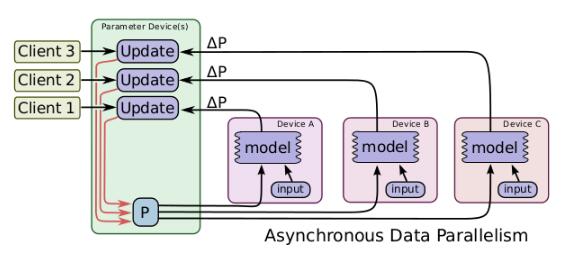

ж•°жҚ®е№¶иЎҢиҝҳжңүејӮжӯҘзҡ„е®һзҺ°ж–№ејҸпјҢеҰӮеӣҫжүҖзӨәпјҢдёҺеҗҢжӯҘж–№ејҸдёҚеҗҢзҡ„жҳҜпјҢеңЁеӨ„зҗҶжқҘиҮӘдёҚеҗҢи®ҫеӨҮзҡ„ж•°жҚ®жӣҙж–°ж—¶иҝӣиЎҢејӮжӯҘжӣҙж–°пјҢдёҚеҗҢи®ҫеӨҮд№Ӣй—ҙдә’дёҚеҪұе“ҚпјҢеҜ№дәҺжҜҸдёҖдёӘеӣҫеүҜжң¬йғҪжңүдёҖдёӘеҚ•зӢ¬зҡ„е®ўжҲ·з«ҜзәҝзЁӢдёҺе…¶еҜ№еә”гҖӮеңЁиҝҷж ·зҡ„е®һзҺ°ж–№ејҸдёӢпјҢеҚідҪҝжңүйғЁеҲҶи®ҫеӨҮжҖ§иғҪзү№еҲ«е·®з”ҡиҮідёӯйҖ”йҖҖеҮәи®ӯз»ғпјҢеҜ№и®ӯз»ғз»“жһңе’Ңи®ӯз»ғж•ҲзҺҮйғҪдёҚдјҡйҖ жҲҗеӨӘеӨ§еҪұе“ҚгҖӮдҪҶжҳҜз”ұдәҺи®ҫеӨҮй—ҙдә’дёҚеҪұе“ҚпјҢжүҖд»ҘеңЁжӣҙж–°еҸӮж•°ж—¶еҸҜиғҪе…¶д»–и®ҫеӨҮе·Із»ҸжӣҙеҘҪзҡ„жӣҙж–°иҝҮдәҶпјҢжүҖд»ҘдјҡйҖ жҲҗеҸӮж•°зҡ„жҠ–еҠЁпјҢдҪҶжҳҜж•ҙдҪ“зҡ„и¶ӢеҠҝжҳҜеҗ‘зқҖжңҖеҘҪзҡ„з»“жһңиҝӣиЎҢзҡ„гҖӮжүҖд»ҘиҜҙиҝҷз§Қж–№ејҸжӣҙйҖӮз”ЁдәҺж•°жҚ®йҮҸеӨ§пјҢжӣҙж–°ж¬Ўж•°еӨҡзҡ„жғ…еҶөгҖӮ

жЁЎеһӢ并иЎҢ

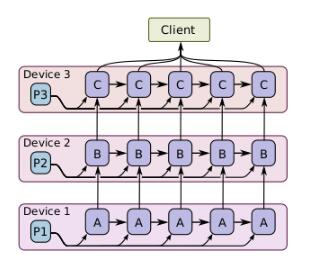

дёҖдёӘжЁЎеһӢ并иЎҢи®ӯз»ғзҡ„дҫӢеӯҗеҰӮеӣҫжүҖзӨәпјҢе…¶й’ҲеҜ№зҡ„и®ӯз»ғеҜ№иұЎжҳҜеҗҢдёҖжү№ж ·жң¬ж•°жҚ®пјҢдҪҶжҳҜе°ҶдёҚеҗҢзҡ„жЁЎеһӢи®Ўз®—йғЁеҲҶеҲҶеёғеңЁдёҚеҗҢзҡ„и®Ўз®—и®ҫеӨҮдёҠеҗҢж—¶жү§иЎҢгҖӮ

жЁЎеһӢи®Ўз®—жөҒж°ҙзәҝ并иЎҢ

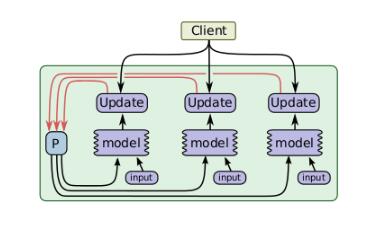

жӯӨ并иЎҢж–№ејҸдё»иҰҒй’ҲеҜ№еңЁеҗҢдёҖдёӘи®ҫеӨҮдёӯ并еҸ‘е®һзҺ°жЁЎеһӢзҡ„и®Ўз®—пјҢеҰӮеӣҫжҳҜ其并еҸ‘и®Ўз®—жӯҘйӘӨпјҢеҸҜд»ҘеҸ‘зҺ°е®ғе®һйҷ…дёҠдёҺејӮжӯҘж•°жҚ®е№¶иЎҢжңүдәӣзӣёдјјпјҢдҪҶжҳҜе”ҜдёҖдёҚеҗҢзҡ„жҳҜжӯӨж–№ејҸзҡ„并иЎҢеҸ‘з”ҹеңЁеҗҢдёҖдёӘи®ҫеӨҮдёҠпјҢиҖҢдёҚжҳҜеңЁдёҚеҗҢзҡ„и®ҫеӨҮд№Ӣй—ҙгҖӮ并且еңЁи®Ўз®—дёҖжү№з®ҖеҚ•зҡ„ж ·дҫӢж—¶пјҢе…Ғи®ёиҝӣиЎҢвҖңеЎ«е……й—ҙйҡҷвҖқпјҢиҝҷеҸҜд»Ҙе……еҲҶеҲ©з”Ёз©әй—Ізҡ„и®ҫеӨҮиө„жәҗгҖӮ

ж„ҹи°ўеҗ„дҪҚзҡ„йҳ…иҜ»пјҒе…ідәҺвҖңTensorflowеҲҶеёғејҸ并иЎҢзӯ–з•Ҙзҡ„зӨәдҫӢеҲҶжһҗвҖқиҝҷзҜҮж–Үз« е°ұеҲҶдә«еҲ°иҝҷйҮҢдәҶпјҢеёҢжңӣд»ҘдёҠеҶ…е®№еҸҜд»ҘеҜ№еӨ§е®¶жңүдёҖе®ҡзҡ„её®еҠ©пјҢи®©еӨ§е®¶еҸҜд»ҘеӯҰеҲ°жӣҙеӨҡзҹҘиҜҶпјҢеҰӮжһңи§үеҫ—ж–Үз« дёҚй”ҷпјҢеҸҜд»ҘжҠҠе®ғеҲҶдә«еҮәеҺ»и®©жӣҙеӨҡзҡ„дәәзңӢеҲ°еҗ§пјҒ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ