жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

иғҢжҷҜ

nginx-kafka-moduleжҳҜnginxзҡ„дёҖдёӘжҸ’件пјҢеҸҜд»Ҙе°Ҷkafkaж•ҙеҗҲеҲ°nginxдёӯпјҢдҫҝдәҺwebйЎ№зӣ®дёӯеүҚз«ҜйЎөйқўеҹӢзӮ№ж•°жҚ®зҡ„收йӣҶпјҢеҰӮеүҚз«ҜйЎөйқўи®ҫзҪ®дәҶеҹӢзӮ№пјҢеҚіеҸҜе°Ҷз”ЁжҲ·зҡ„дёҖдәӣи®ҝй—®е’ҢиҜ·жұӮж•°жҚ®йҖҡиҝҮhttpиҜ·жұӮзӣҙжҺҘеҸ‘йҖҒеҲ°ж¶ҲжҒҜдёӯй—ҙ件kafkaдёӯпјҢеҗҺз«ҜеҸҜд»ҘйҖҡиҝҮзЁӢеәҸж¶Ҳиҙ№kafkaдёӯзҡ„ж¶ҲжҒҜжқҘиҝӣиЎҢе®һж—¶зҡ„и®Ўз®—гҖӮжҜ”еҰӮйҖҡиҝҮSparkStreamжқҘе®һж—¶зҡ„ж¶Ҳиҙ№Kafkaдёӯзҡ„ж•°жҚ®жқҘеҲҶжһҗз”ЁжҲ·PV,UVгҖҒз”ЁжҲ·зҡ„дёҖдәӣиЎҢдёәеҸҠйЎөйқўзҡ„жјҸж–—жЁЎеһӢиҪ¬еҢ–зҺҮпјҢжқҘжӣҙеҘҪзҡ„еҜ№зі»з»ҹиҝӣиЎҢдјҳеҢ–жҲ–иҖ…еҜ№жқҘи®ҝз”ЁжҲ·иҝӣиЎҢе®һж—¶еҠЁжҖҒзҡ„еҲҶжһҗгҖӮ

е…·дҪ“ж•ҙеҗҲжӯҘйӘӨ

1.е®үиЈ…git

yum install -y git

2.еҲҮжҚўеҲ°/usr/local/srcзӣ®еҪ•пјҢ然еҗҺе°Ҷkafkaзҡ„cе®ўжҲ·з«Ҝжәҗз ҒcloneеҲ°жң¬ең°

cd /usr/local/src git clone https://github.com/edenhill/librdkafka

3.иҝӣе…ҘеҲ°librdkafkaпјҢ然еҗҺиҝӣиЎҢзј–иҜ‘

cd librdkafka yum install -y gcc gcc-c++ pcre-devel zlib-devel ./configure make && make install

4.е®үиЈ…nginxж•ҙеҗҲkafkaзҡ„жҸ’件пјҢиҝӣе…ҘеҲ°/usr/local/srcпјҢclone nginxж•ҙеҗҲkafkaзҡ„жәҗз Ғ

cd /usr/local/src git clone https://github.com/brg-liuwei/ngx_kafka_module

5.иҝӣе…ҘеҲ°nginxзҡ„жәҗз ҒеҢ…зӣ®еҪ•дёӢ пјҲзј–иҜ‘nginxпјҢ然еҗҺе°Ҷе°ҶжҸ’件еҗҢж—¶зј–иҜ‘пјү

cd /usr/local/src/nginx-1.12.2 ./configure --add-module=/usr/local/src/ngx_kafka_module/ make && make install

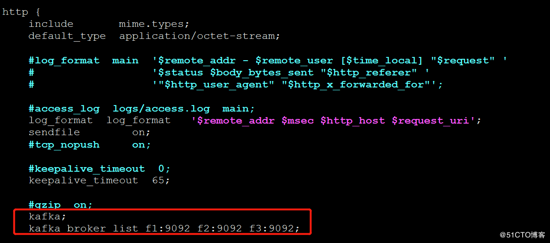

6.дҝ®ж”№nginxзҡ„й…ҚзҪ®ж–Ү件пјҡи®ҫзҪ®дёҖдёӘlocationе’Ңkafakaзҡ„topicпјҢиҜҰжғ…иҜ·жҹҘзңӢеҪ“еүҚзӣ®еҪ•зҡ„nginx.conf

#ж·»еҠ й…ҚзҪ®(2еӨ„)

kafka;

kafka_broker_list f1:9092 f2:9092 f3:9092;

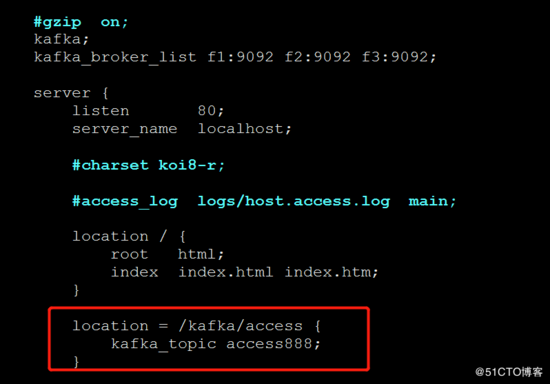

location = /kafka/access {

kafka_topic access888;

}

еҰӮдёӢеӣҫпјҡ

7.еҗҜеҠЁzkе’ҢkafkaйӣҶзҫӨ(еҲӣе»әtopic)

zkServer.sh start kafka-server-start.sh -daemon config/server.properties

8.еҗҜеҠЁnginxпјҢжҠҘй”ҷпјҢжүҫдёҚеҲ°kafka.so.1зҡ„ж–Ү件

error while loading shared libraries: librdkafka.so.1: cannot open shared object file: No such file or directory

9.еҠ иҪҪsoеә“

#ејҖжңәеҠ иҪҪ/usr/local/libдёӢйқўзҡ„еә“ echo "/usr/local/lib" >> /etc/ld.so.conf #жүӢеҠЁеҠ иҪҪ ldconfig

10.жөӢиҜ•пјҢеҗ‘nginxдёӯеҶҷе…Ҙж•°жҚ®пјҢ然еҗҺи§ӮеҜҹkafkaзҡ„ж¶Ҳиҙ№иҖ…иғҪдёҚиғҪж¶Ҳиҙ№еҲ°ж•°жҚ®

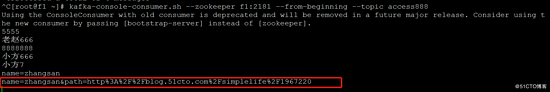

curl http://localhost/kafka/access -d "message send to kafka topic" curl http://localhost/kafka/access -d "е°Ҹдјҹ666"жөӢиҜ•

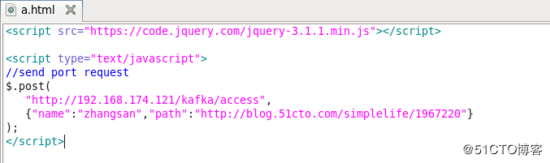

д№ҹеҸҜд»ҘжЁЎжӢҹйЎөйқўеҹӢзӮ№иҜ·жұӮжҺҘеҸЈжқҘеҸ‘йҖҒдҝЎжҒҜпјҡ

еҗҺеҸ°Kafkaж¶Ҳиҙ№дҝЎжҒҜеҰӮеӣҫпјҡ

д»ҘдёҠе°ұжҳҜжң¬ж–Үзҡ„е…ЁйғЁеҶ…е®№пјҢеёҢжңӣеҜ№еӨ§е®¶зҡ„еӯҰд№ жңүжүҖеё®еҠ©пјҢд№ҹеёҢжңӣеӨ§е®¶еӨҡеӨҡж”ҜжҢҒдәҝйҖҹдә‘гҖӮ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ