жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

й•ңеғҸдёӢиҪҪең°еқҖпјҡhttps://www.proxmox.com/en/downloads

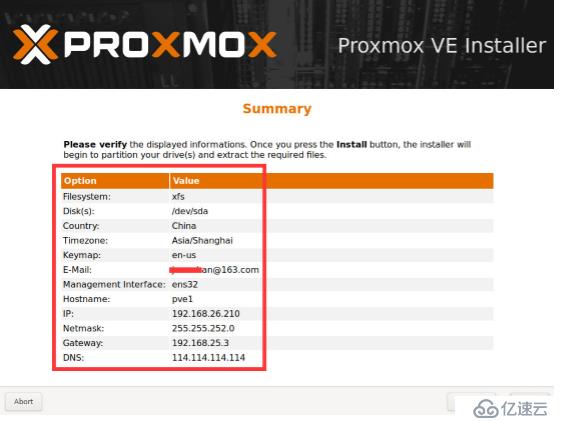

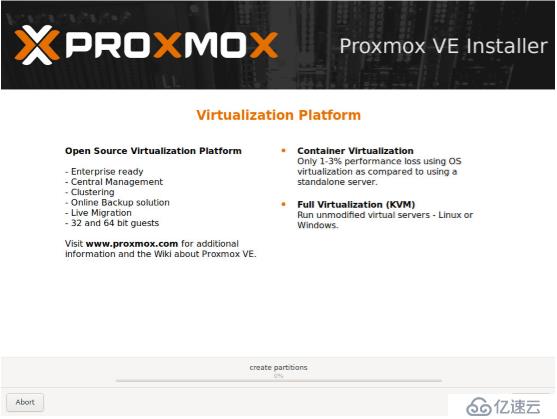

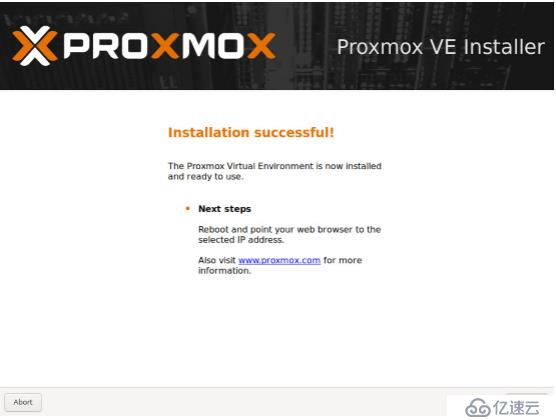

е®үиЈ…иҝҮзЁӢеӣҫи§Јпјҡ

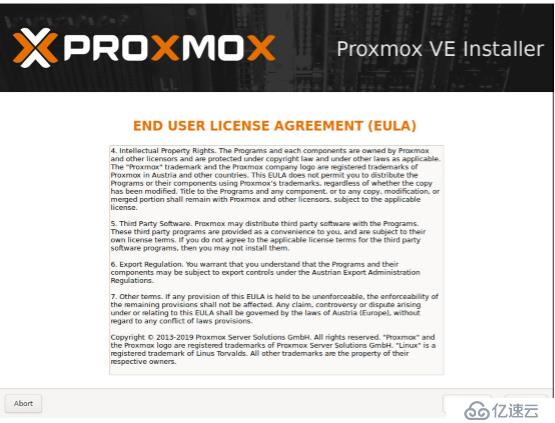

1гҖҒ

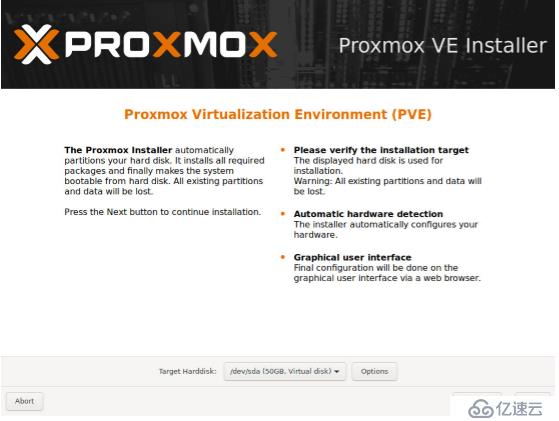

2гҖҒ

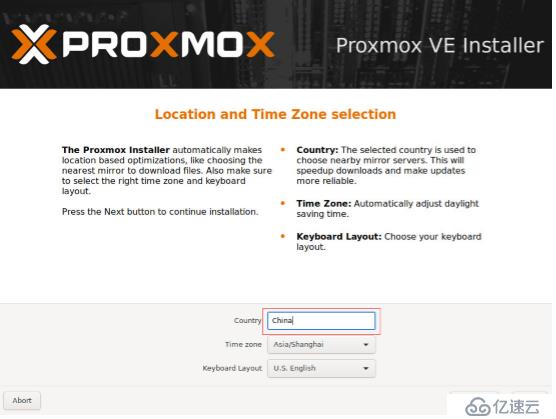

3гҖҒ

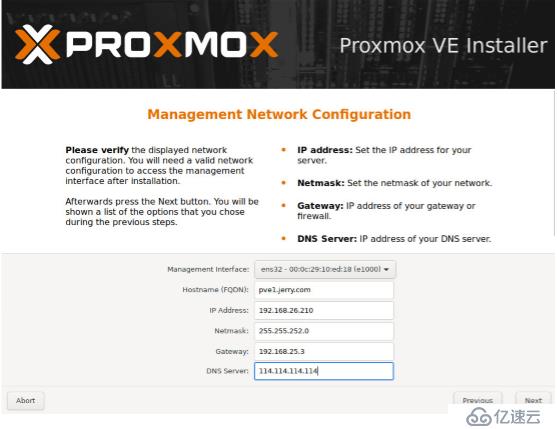

4гҖҒ

5гҖҒ

6гҖҒ

7гҖҒ

8гҖҒ

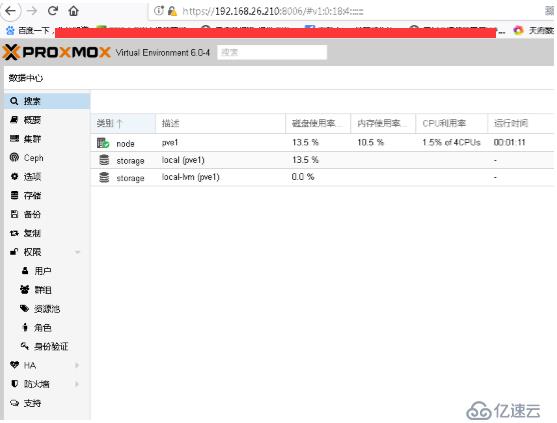

9гҖҒжөҸи§ҲеҷЁWEBзҷ»йҷҶжҺ§еҲ¶еҸ°дёҖи§Ҳ

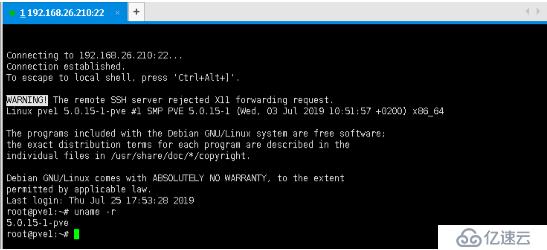

sshзҷ»йҷҶдёҠеҺ»жҹҘзңӢдёӢзүҲжң¬:

иҝҷйҮҢжҲ‘们дҫқ然еҲӣе»әдёүдёӘз»“зӮ№зҡ„йӣҶзҫӨпјҲPVE1-PVE3,192.168.26.210-212)е…¶е®ғз»“зӮ№е®үиЈ…з•Ҙй…ҚзҪ®ж–№жі•дёҖж ·гҖӮ

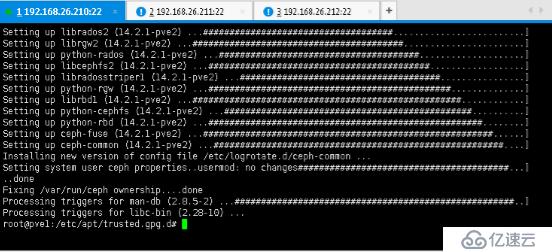

дҫқ然иҰҒжӣҙж–°й…ҚзҪ®дёӢжәҗеҸҠзі»з»ҹпјҲзңӢдјјзӣёеҗҢжіЁж„ҸзүҲжң¬е·®ејӮпјү

rm -f /etc/apt/sources.list.d/pve-enterprise.list

echo "deb http://download.proxmox.com/debian/pve stretch pve-no-subscription" >/etc/apt/sources.list.d/pve-install-repo.list

wget http://download.proxmox.com/debian/proxmox-ve-release-6.x.gpg -O /etc/apt/trusted.gpg.d/proxmox-ve-release-6.x.gpg

apt update && apt dist-upgrade

еҰӮжһңиҰҒдёҠдј ISOй•ңпјҢй»ҳи®Өзҡ„дҪҚзҪ®еұ•зӨәдёҖдёӢпјҡ

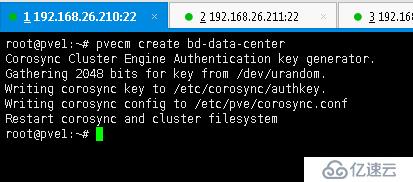

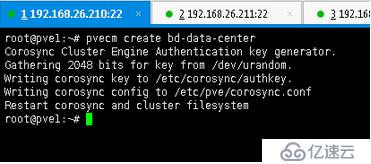

ејҖе§ӢеҲӣе»әpveйӣҶзҫӨпјҡ

pve1дёҠжү§иЎҢпјҡ

pvecm create bd-data-center

pve2дёҠжү§иЎҢпјҡ

root@pve2:~# pvecm add 192.168.26.210

жіЁж„ҸйңҖиҰҒиҫ“е…ҘеҜҶз ҒиҝӣиЎҢйҖҡдҝЎи®ӨиҜҒгҖӮ

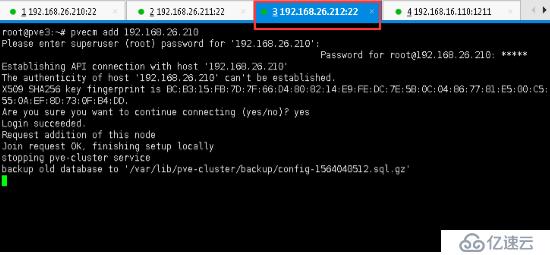

еҗҢж ·PVE3дёҠжү§иЎҢ:

root@pve3:~# pvecm add 192.168.26.210

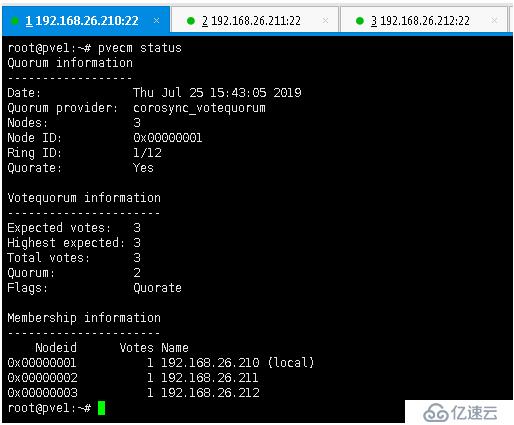

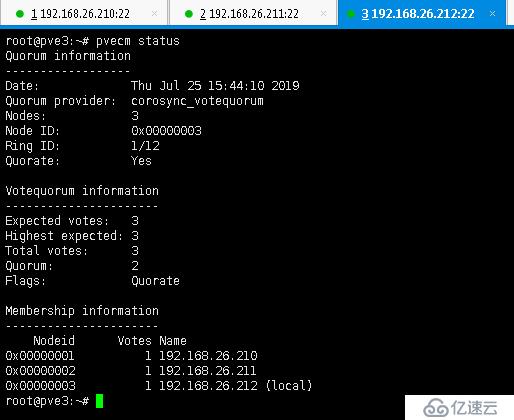

жҹҘзңӢдёӢжӯӨж—¶йӣҶзҫӨзҠ¶жҖҒпјҡд»»дёҖз»“зӮ№дёҠжү§иЎҢж•ҲжһңдёҖж ·пјҲеұ•зӨәдёӨдёӘз»“зӮ№дёҠжү§иЎҢзҡ„ж•Ҳжһңпјү

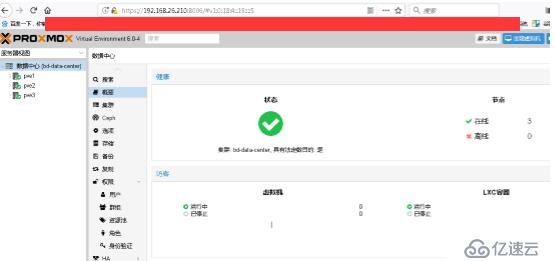

зҷ»йҷҶWEBжҺ§еҲ¶еҸ°жҹҘзңӢдёӢжӯӨж—¶ж•Ҳжһңпјҡ

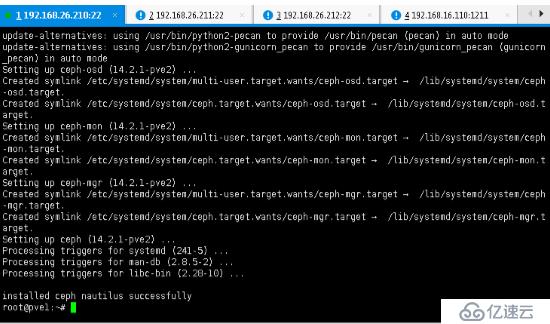

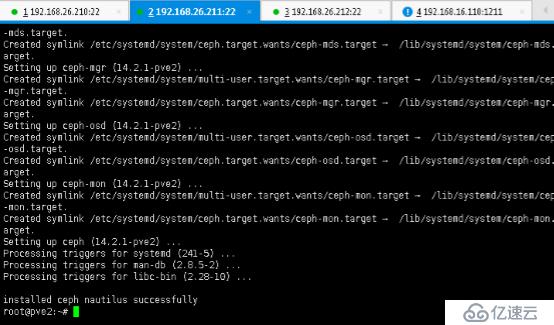

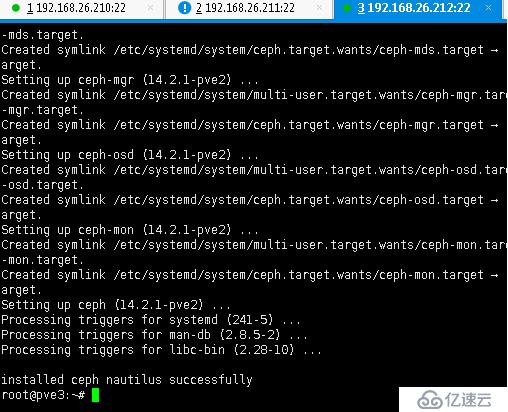

жҺҘзқҖе®үиЈ…CEPHеӯҳеӮЁпјҲдёүдёӘз»“зӮ№еҲҶеҲ«е®үиЈ…пјү

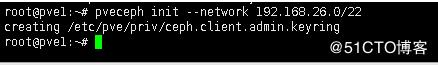

еҲқе§ӢеҢ–cephйӣҶзҫӨзҪ‘ж®өпјҡpveceph init --network 192.168.26.0/22

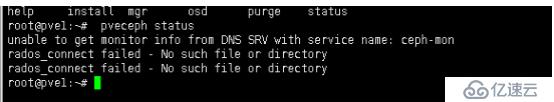

жӯӨж—¶иӢҘе‘Ҫд»ӨжҹҘзңӢCEPHзҠ¶жҖҒдјҡжҠҘй”ҷпјҡpveceph status

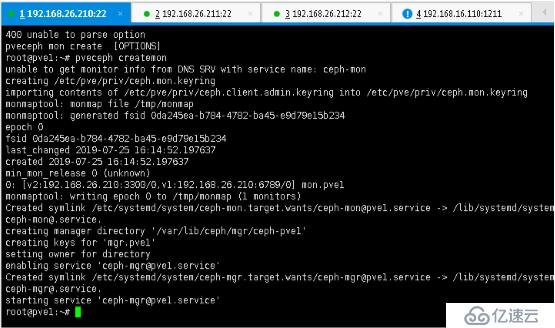

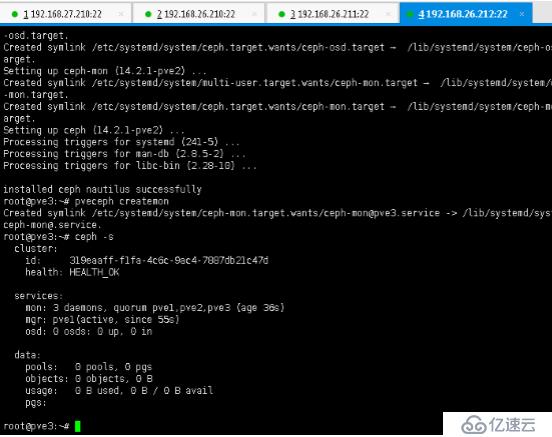

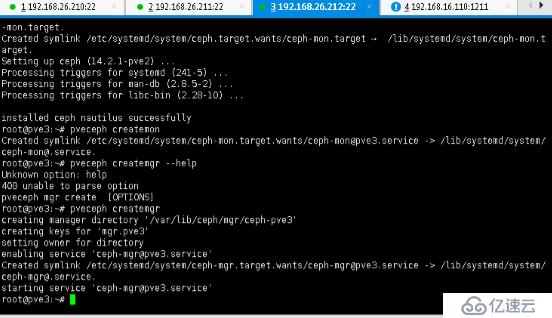

еҗ„з»“зӮ№еҲӣе»әcephйӣҶзҫӨеӯҳеӮЁMonзӣ‘жҺ§пјҡ

pveceph createmon

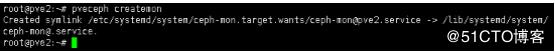

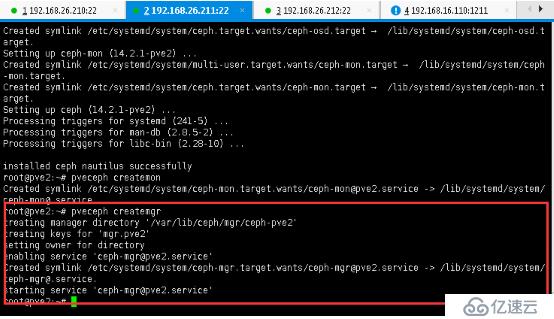

root@pve2:~# pveceph createmon

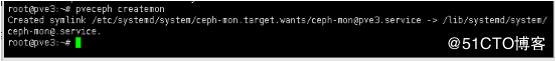

root@pve3:~# pveceph createmon

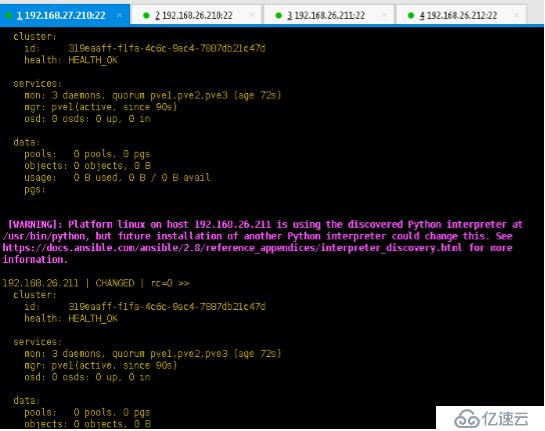

жӯӨж—¶жҹҘзңӢCEPHзҠ¶жҖҒпјҡ

AnsibleзңӢдёӢеҗ„з»“зӮ№еҗ§пјҢе…¶е®һйғҪдёҖж ·зҡ„гҖӮ

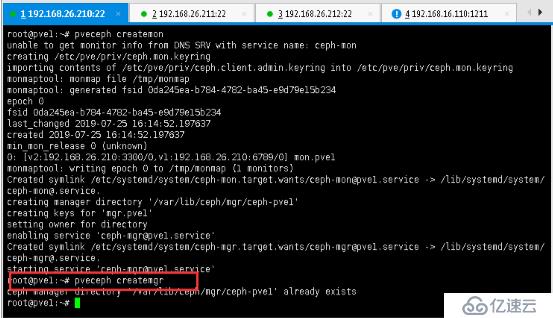

еҲӣе»әmgrдёүдёӘз»“зӮ№йғҪйңҖиҰҒжү§иЎҢ

pveceph createmgr #жӯӨз»“зӮ№жҸҗзӨәе·Із»ҸеӯҳеңЁ

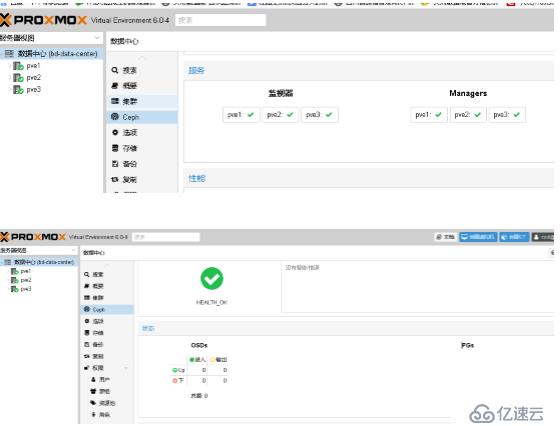

жҹҘзңӢWEBжҺ§еҲ¶еҸ°жӯӨж—¶йӣҶзҫӨзҠ¶жҖҒ:

Creating Ceph OSDs

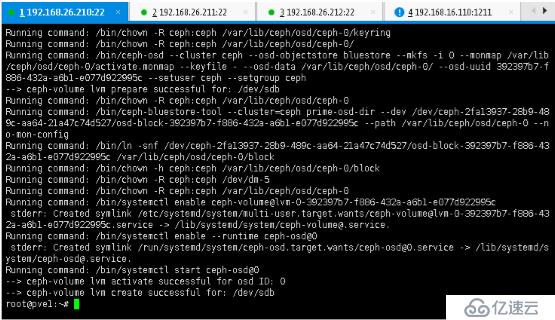

еҲӣе»әCeph OSDs еӯҳеӮЁпјҲдёүдёӘз»“зӮ№жү§иЎҢеҗҢж ·ж“ҚдҪңпјү

root@pve1:~# pveceph createosd /dev/sdb

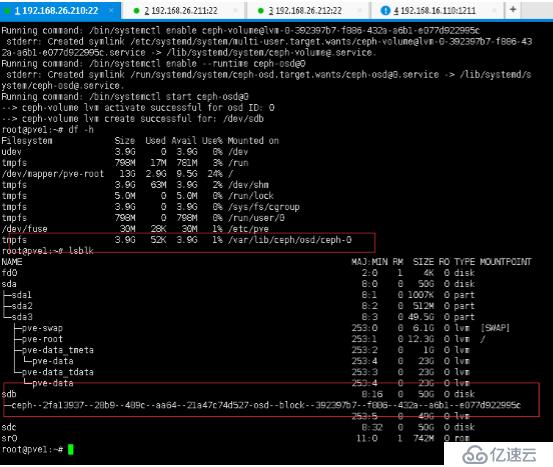

еңЁPVE1дёҠжү§иЎҢеҗҺ马дёҠзңӢдёӢWEBжҺ§еҲ¶еҸ°зңӢдёӢжӯӨж—¶зҠ¶жҖҒеҸҳеҢ–жғ…еҶө

PVE1дёҠзЈҒзӣҳе’Ңй…ҚзҪ®дҝЎжҒҜеҸҳеҢ–жғ…еҶө

еҗҢж ·е…¶е®ғдёӨдёӘз»“зӮ№жү§иЎҢ

root@pve2:~# pveceph createosd /dev/sdb

root@pve3:~#pveceph createosd /dev/sdb

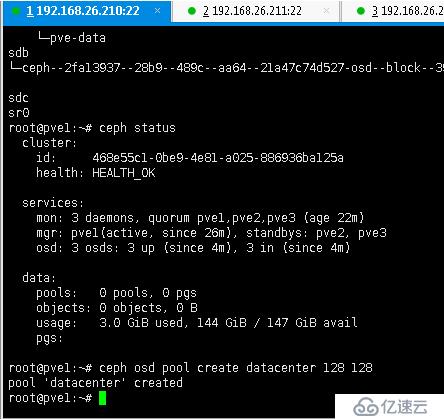

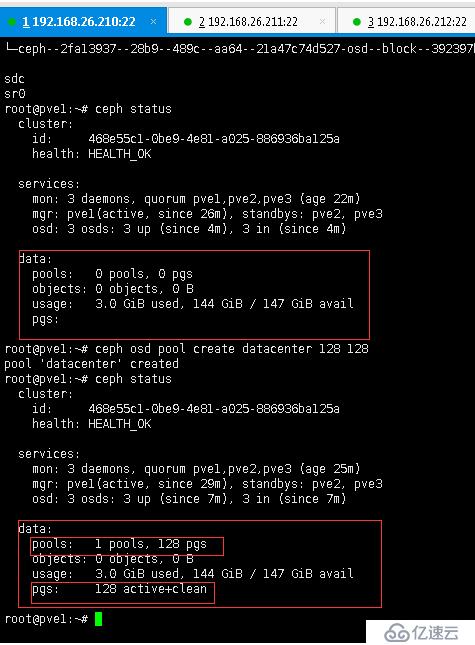

еҲӣе»әcephйӣҶзҫӨеӯҳеӮЁиө„жәҗжұ ceph osd pool create [иө„жәҗжұ еҗҚз§°] 128 128

root@pve1:~# ceph osd pool create datacenter 128 128

#ж·»еҠ RBDйӣҶзҫӨеӯҳеӮЁ

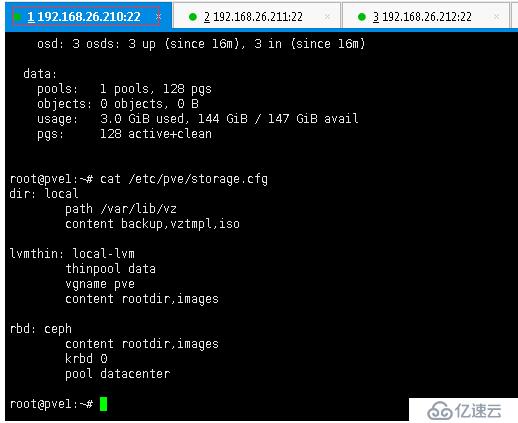

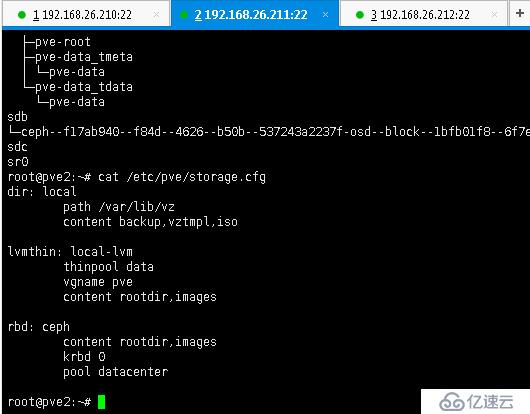

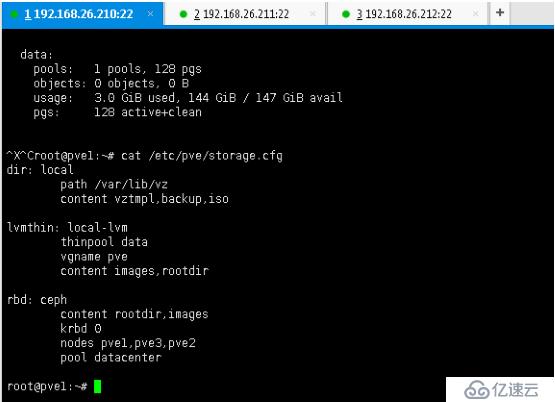

#жҹҘзңӢrbdйӣҶзҫӨеӯҳеӮЁй…ҚзҪ®дҝЎжҒҜ(йӣҶзҫӨд»»дёҖз»“зӮ№жҹҘзңӢйғҪдёҖж ·пјү

root@pve1:~# cat /etc/pve/storage.cfg

еҲӣе»әеүҚзҡ„ж•Ҳжһңпјҡ

еҲӣе»әеҗҺзҡ„ж•Ҳжһңпјҡ

ж·»еҠ иө„жәҗжұ пјҡdbdata,iscpool,idcpool

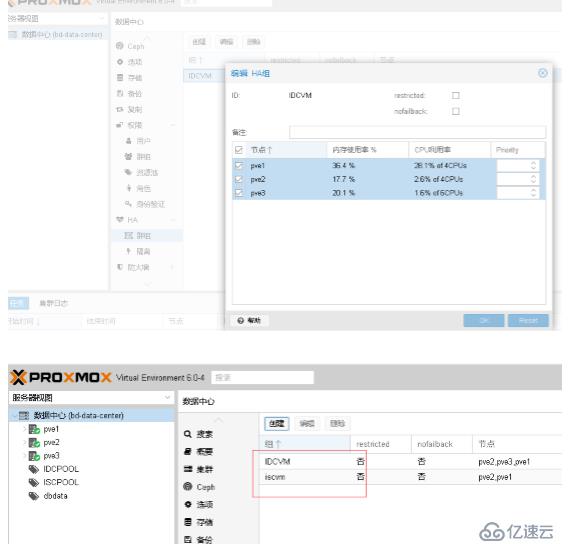

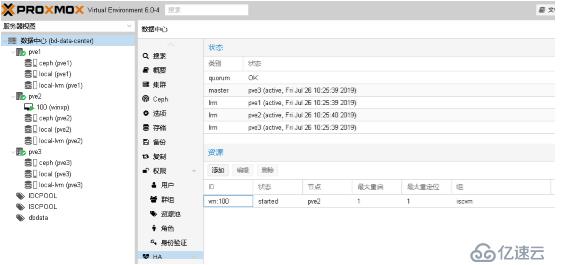

HAзҫӨз»„еҲӣе»әпјҡISCVM,IDCVM

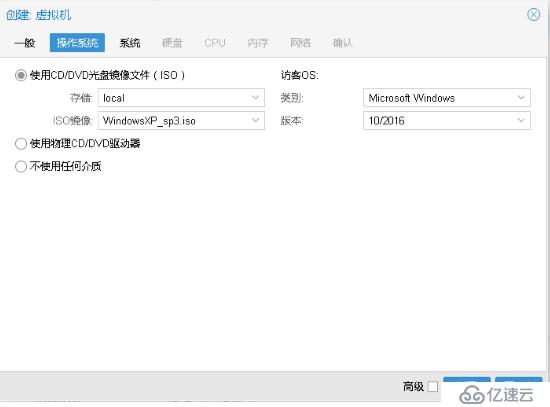

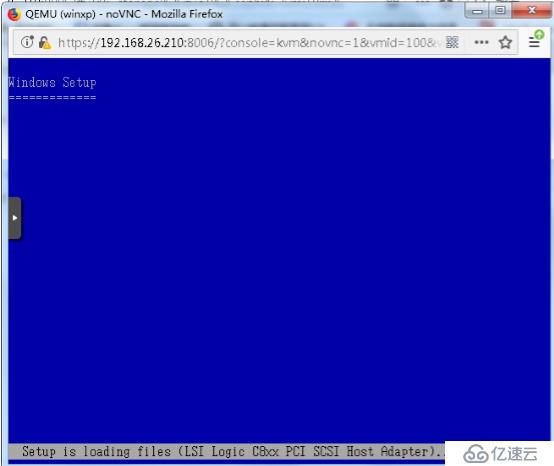

еҲӣе»әиҷҡжӢҹжңҚеҠЎеҷЁпјҡ

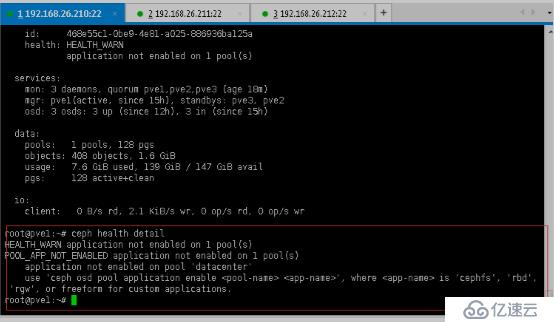

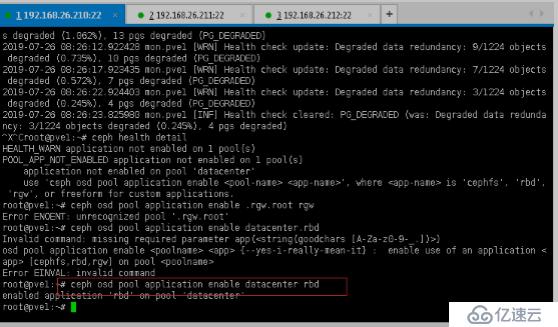

е…¶дёӯйҒҮеҲ°зҡ„жҠҘй”ҷи§ЈеҶіж–№жі•пјҡ

root@pve1:~# ceph health detail

жҠҘй”ҷи§ЈеҶіж–№жі•пјҡceph osd pool application enable datacenter rbd

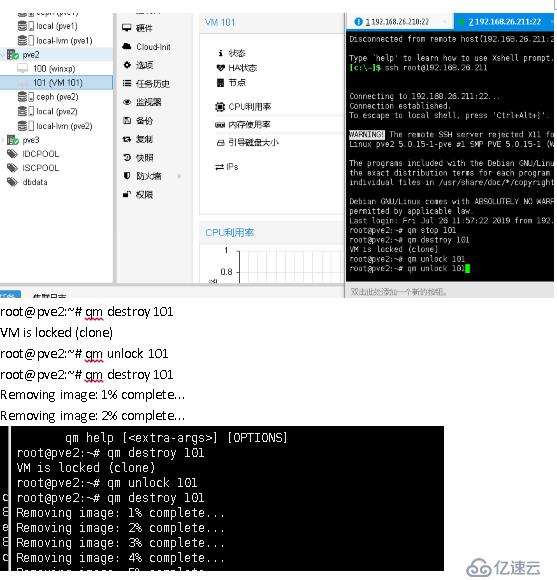

й«ҳеҸҜз”ЁзҠ¶жҖҒдёӢдёҚиғҪиҝӣиЎҢе…ӢйҡҶж“ҚдҪңпјҢеҗҰеҲҷдјҡеҮәй”ҷпјҢеҮәзҺ°иҷҡжӢҹжңәй”ҒдҪҸпјҢдё”ж— жі•зӣҙжҺҘеҲ йҷӨзҡ„зҺ°иұЎгҖӮ

ж— жі•еҲ йҷӨпјҡ

з”Ёе‘Ҫд»Өи§Јй”Ғд№ӢеҗҺеҚіеҸҜеҲ йҷӨиҷҡжӢҹжңәгҖӮ

root@pve2:~# qm destroy 101

VM is locked (clone)

root@pve2:~# qm unlock 101

root@pve2:~# qm destroy 101

Removing image: 1% complete...

Removing image: 2% complete...

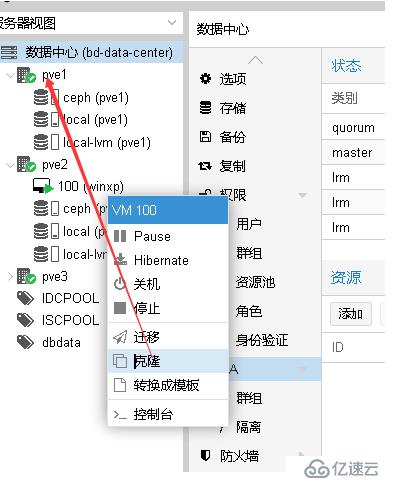

移еҮәй«ҳеҸҜз”ЁзҠ¶жҖҒпјҢеҶҚиҝӣиЎҢе…ӢйҡҶж“ҚдҪңпјҡ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ