жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

ж’°еҶҷж—Ҙжңҹпјҡ2017е№ҙ6жңҲ13ж—Ҙ

дҪңиҖ…пјҡзҝҹжұҹжҒ’

дёҖиҲ¬жғ…еҶөдёӢдёҚдјҡйҮҮз”ЁжүӢеҠЁзҡ„ж–№ејҸе®үиЈ…HPCпјҢиҖҢжҳҜйҮҮз”ЁйӣҶжҲҗиҮӘеҠЁеҢ–ж–№жЎҲжқҘйғЁзҪІhpcпјҢдҪҶжҳҜиҝҷдәӣйӣҶжҲҗж–№жЎҲйғҪжҳҜйӣҶжҲҗдәҶжҢҮе®ҡзҡ„ж“ҚдҪңзі»з»ҹеҸ‘иЎҢзүҲжң¬пјҢжҜ”еҰӮеёёи§Ғзҡ„HPCйӣҶжҲҗиҮӘеҠЁеҢ–ж–№жЎҲrockets,еҲ°зӣ®еүҚдёәжӯўйӣҶжҲҗcentos 6.6,еҰӮжһңйңҖиҰҒжҠҠHPCе®үиЈ…е…¶д»–linuxеҸ‘иЎҢзүҲжң¬зҺҜеўғйҮҢйқўпјҢе°ұдёҚиғҪдҪҝз”ЁйӣҶжҲҗиҮӘеҠЁеҢ–ж–№жЎҲпјҢеҝ…йЎ»дҪҝз”ЁжүӢеҠЁе®үиЈ…ж–№жі•пјҢиҝҷзҜҮеҚҡе®ўе°ұжҳҜеҸҷиҝ°еҰӮдҪ•жүӢеҠЁжҗӯе»әHPCзҡ„гҖӮ敬иҜ·еҫҖдёӢзңӢгҖӮ

1. HPCз®Җд»Ӣ

2. HPCжһ¶жһ„

3. sshж— еҜҶз Ғи®ҝй—®

4. е®үиЈ…й…ҚзҪ®NFS

5. е®үиЈ…й…ҚзҪ®NIS

6. е®үиЈ…tentakel

7. е®үиЈ…openmpi

8. е®үиЈ…torque

9. е®үиЈ…ganglia

1. HPCз®Җд»Ӣ

й«ҳжҖ§иғҪи®Ўз®—(Highperformance computingпјҢзј©еҶҷHPC) жҢҮйҖҡеёёдҪҝз”ЁеҫҲеӨҡеӨ„зҗҶеҷЁпјҲдҪңдёәеҚ•дёӘжңәеҷЁзҡ„дёҖйғЁеҲҶпјүжҲ–иҖ…жҹҗдёҖйӣҶзҫӨдёӯз»„з»Үзҡ„еҮ еҸ°и®Ўз®—жңәпјҲдҪңдёәеҚ•дёӘи®Ўз®—иө„жәҗж“ҚдҪңпјүзҡ„и®Ўз®—зі»з»ҹе’ҢзҺҜеўғгҖӮжңүи®ёеӨҡзұ»еһӢзҡ„HPC зі»з»ҹпјҢе…¶иҢғеӣҙд»Һж ҮеҮҶи®Ўз®—жңәзҡ„еӨ§еһӢйӣҶзҫӨпјҢеҲ°й«ҳеәҰдё“з”Ёзҡ„硬件гҖӮеӨ§еӨҡж•°еҹәдәҺйӣҶзҫӨзҡ„HPCзі»з»ҹдҪҝз”Ёй«ҳжҖ§иғҪзҪ‘з»ңдә’иҝһпјҢжҜ”еҰӮйӮЈдәӣжқҘиҮӘ InfiniBand жҲ– Myrinet зҡ„зҪ‘з»ңдә’иҝһгҖӮеҹәжң¬зҡ„зҪ‘з»ңжӢ“жү‘е’Ңз»„з»ҮеҸҜд»ҘдҪҝз”ЁдёҖдёӘз®ҖеҚ•зҡ„жҖ»зәҝжӢ“жү‘пјҢеңЁжҖ§иғҪеҫҲй«ҳзҡ„зҺҜеўғдёӯпјҢзҪ‘зҠ¶зҪ‘з»ңзі»з»ҹеңЁдё»жңәд№Ӣй—ҙжҸҗдҫӣиҫғзҹӯзҡ„жҪңдјҸжңҹпјҢжүҖд»ҘеҸҜж”№е–„жҖ»дҪ“зҪ‘з»ңжҖ§иғҪе’Ңдј иҫ“йҖҹзҺҮгҖӮ

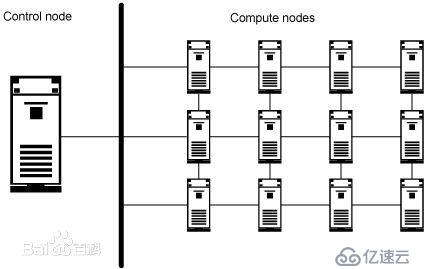

2. hpcжһ¶жһ„

HPCзҪ‘з»ңжһ¶жһ„еҰӮеӣҫжүҖзӨә

дёҠеӣҫжҳҫзӨәдәҶдёҖзҪ‘зҠ¶ HPC зі»з»ҹгҖӮеңЁзҪ‘зҠ¶зҪ‘з»ңжӢ“жү‘дёӯпјҢиҜҘз»“жһ„ж”ҜжҢҒйҖҡиҝҮзј©зҹӯзҪ‘з»ңиҠӮзӮ№д№Ӣй—ҙзҡ„зү©зҗҶе’ҢйҖ»иҫ‘и·қзҰ»жқҘеҠ еҝ«и·Ёдё»жңәзҡ„йҖҡдҝЎгҖӮ

е°Ҫз®ЎзҪ‘з»ңжӢ“жү‘гҖҒ硬件е’ҢеӨ„зҗҶ硬件еңЁ HPC зі»з»ҹдёӯеҫҲйҮҚиҰҒпјҢдҪҶжҳҜдҪҝзі»з»ҹеҰӮжӯӨжңүж•Ҳзҡ„ж ёеҝғеҠҹиғҪжҳҜз”ұж“ҚдҪңзі»з»ҹе’Ңеә”з”ЁиҪҜ件жҸҗдҫӣзҡ„гҖӮ

HPC зі»з»ҹдҪҝз”Ёзҡ„жҳҜдё“й—Ёзҡ„ж“ҚдҪңзі»з»ҹпјҢиҝҷдәӣж“ҚдҪңзі»з»ҹиў«и®ҫи®ЎдёәзңӢиө·жқҘеғҸжҳҜеҚ•дёӘи®Ўз®—иө„жәҗгҖӮжӯЈеҰӮд»Һеӣҫ1е’Ңеӣҫ2дёӯеҸҜд»ҘзңӢеҲ°зҡ„пјҢе…¶дёӯжңүдёҖдёӘжҺ§еҲ¶иҠӮзӮ№пјҢиҜҘиҠӮзӮ№еҪўжҲҗдәҶ HPC зі»з»ҹе’Ңе®ўжҲ·жңәд№Ӣй—ҙзҡ„жҺҘеҸЈгҖӮиҜҘжҺ§еҲ¶иҠӮзӮ№иҝҳз®ЎзҗҶзқҖи®Ўз®—иҠӮзӮ№зҡ„е·ҘдҪңеҲҶй…ҚгҖӮ

еҜ№дәҺе…ёеһӢ HPC зҺҜеўғдёӯзҡ„д»»еҠЎжү§иЎҢпјҢжңүдёӨдёӘжЁЎеһӢпјҡеҚ•жҢҮд»Ө/еӨҡж•°жҚ®(SIMD) е’ҢеӨҡжҢҮд»Ө/еӨҡж•°жҚ® (MIMD)гҖӮSIMDеңЁи·ЁеӨҡдёӘеӨ„зҗҶеҷЁзҡ„еҗҢж—¶жү§иЎҢзӣёеҗҢзҡ„и®Ўз®—жҢҮд»Өе’Ңж“ҚдҪңпјҢдҪҶеҜ№дәҺдёҚеҗҢж•°жҚ®иҢғеӣҙпјҢе®ғе…Ғи®ёзі»з»ҹеҗҢж—¶дҪҝз”Ёи®ёеӨҡеҸҳйҮҸи®Ўз®—зӣёеҗҢзҡ„иЎЁиҫҫејҸгҖӮMIMDе…Ғи®ёHPC зі»з»ҹеңЁеҗҢдёҖж—¶й—ҙдҪҝз”ЁдёҚеҗҢзҡ„еҸҳйҮҸжү§иЎҢдёҚеҗҢзҡ„и®Ўз®—пјҢдҪҝж•ҙдёӘзі»з»ҹзңӢиө·жқҘ并дёҚеҸӘжҳҜдёҖдёӘжІЎжңүд»»дҪ•зү№зӮ№зҡ„и®Ўз®—иө„жәҗпјҲе°Ҫз®Ўе®ғеҠҹиғҪејәеӨ§пјүпјҢеҸҜд»ҘеҗҢж—¶жү§иЎҢи®ёеӨҡи®Ўз®—гҖӮ

дёҚз®ЎжҳҜдҪҝз”Ё SIMD иҝҳжҳҜ MIMDпјҢе…ёеһӢHPC зҡ„еҹәжң¬еҺҹзҗҶд»Қ然жҳҜзӣёеҗҢзҡ„пјҡж•ҙдёӘHPC еҚ•е…ғзҡ„ж“ҚдҪңе’ҢиЎҢдёәеғҸжҳҜеҚ•дёӘи®Ўз®—иө„жәҗпјҢе®ғе°Ҷе®һйҷ…иҜ·жұӮзҡ„еҠ иҪҪеұ•ејҖеҲ°еҗ„дёӘиҠӮзӮ№гҖӮHPC и§ЈеҶіж–№жЎҲд№ҹжҳҜдё“з”Ёзҡ„еҚ•е…ғпјҢиў«дё“й—Ёи®ҫи®Ўе’ҢйғЁзҪІдёәиғҪеӨҹе……еҪ“пјҲ并且еҸӘе……еҪ“пјүеӨ§еһӢи®Ўз®—иө„жәҗгҖӮ

3.SSHж— еҜҶз Ғи®ҝй—®

е»әз«Ӣи„ҡжң¬зӣ®еҪ•

mkdir вҖ“p /root/rootUser

mkdir вҖ“p /home/жҷ®йҖҡз”ЁжҲ·зӣ®еҪ•

дҫӢеҰӮпјҡ mkdir вҖ“p /home/hpc (hpcе°ұжҳҜдёҖдёӘжҷ®йҖҡз”ЁжҲ·)

зј–еҶҷеҰӮдёӢдёүдёӘи„ҡжң¬пјҡ

Setp1.exp

еҶ…е®№еҰӮдёӢпјҡ

#!/bin/bash

rm -fr/root/.ssh

/usr/bin/expect<<EOF

setforce_conservative 0 ;# set to 1 toforce conservative mode even if

;# script wasn't run conservativelyoriginally

if{\$force_conservative} {

set send_slow {1 .1}

proc send {ignore arg} {

sleep .1

exp_send -s -- \$arg

}

}

settimeout -1

spawnssh-keygen -t dsa

match_max100000

expect-exact "Enter file in which to save the key (/root/.ssh/id_dsa): "

send --"\r"

expect-exact "Enter passphrase (empty for no passphrase): "

send --"\r"

expect-exact "Enter same passphrase again: "

send --"\r"

expecteof

EOF

cd/root/.ssh

catid_dsa.pub >> authorized_keys

chmod 600authorized_keys

step2.exp

еҶ…е®№еҰӮдёӢпјҡ

#!/bin/bash

if [ $#-ne 1 ]

then

{

echo 'usage: step1.exp root_password'

exit

}

fi;

ROOTPASSWD=$1

rm -fr/root/.ssh/known_hosts

#for((node=1;node<=10;node++))

for nodein $(cat hostfile)

do

/usr/bin/expect<<EOF

# set to1 to force conservative mode even if

setforce_conservative 0 ;

;# script wasn't run conservativelyoriginally

if{\$force_conservative} {

set send_slow {1 .1}

proc send {ignore arg} {

sleep .1

exp_send -s -- \$arg

}

}

settimeout -1

spawn ssh${node} hostname

match_max100000

expect-exact "Are you sure you want to continue connecting (yes/no)? "

send --"yes\r"

expect-exact "${node}'s password: "

send --"${ROOTPASSWD}\r"

expecteof

EOF

done;

step3.exp

еҶ…е®№еҰӮдёӢпјҡ

#!/bin/bash

if [ $#-ne 1 ]

then

{

echo 'usage : step3.exp root_password';

exit 1;

}

fi;

ROOTPASSWORD=$1

#for((node=1;node<=10;node++))

for nodein $(cat hostfile)

do

/usr/bin/expect<<EOF

setforce_conservative 0 ;# set to 1 toforce conservative mode even if

;# script wasn't run conservativelyoriginally

if{\$force_conservative} {

set send_slow {1 .1}

proc send {ignore arg} {

sleep .1

exp_send -s -- \$arg

}

}

settimeout -1

spawn scp-rp /root/.ssh ${node}:/root

match_max100000

expect-exact "root@${node}'s password: "

send --"${ROOTPASSWORD}\r"

expecteof

EOF

Done

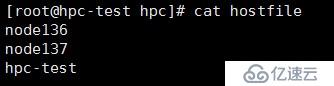

жү§иЎҢе‘Ҫд»Өпјҡtouch hostfile

зј–иҫ‘hostfileж–Ү件пјҢеҠ е…ҘиҜҙжңүдё»жңәеҗҚпјҢдёҖиЎҢдёҖдёӘгҖӮ

дҫӢеҰӮпјҡ

node136

node137

node138

hpc-test

жү§иЎҢеҰӮдёӢе‘Ҫд»Өпјҡ

cp setp1.exp setp2.exp setp3.exp hostfile /root/rootUser/

cp setp1.exp setp2.exp hostfile /home/жҷ®йҖҡз”ЁжҲ·зӣ®еҪ•

chmod 755 вҖ“R /root/rootUser/

chmod 755 вҖ“R /home/жҷ®йҖҡз”ЁжҲ·зӣ®еҪ•

chown root:root вҖ“R /root/rootUser/

chown жҷ®йҖҡз”ЁжҲ·:жҷ®йҖҡз”ЁжҲ·з»„ вҖ“R /home/жҷ®йҖҡз”ЁжҲ·зӣ®еҪ•/

д»ҘдёӢе®һзҺ°еҗ„жңҚеҠЎеҷЁд№Ӣй—ҙrootз”ЁжҲ·д№Ӣй—ҙsshж— еҜҶз Ғи®ҝй—®гҖӮ

дҝ®ж”№hostfileж–Ү件еҶ…е®№пјҢжҠҠжүҖжңүдё»жңәеҗҚз§°ж·»еҠ иҝӣеҺ»гҖӮ

е…ҲдҪҝз”Ёrootз”ЁжҲ·йЎәеәҸжү§иЎҢзӣ®еҪ•/root/rootuserйҮҢйқўзҡ„и„ҡжң¬пјҡ

sh step1.exp

sh step2.exp root еҜҶз Ғ

sh step3.exp root еҜҶз Ғ

д»ҘдёӢе®һзҺ°еҗ„жңҚеҠЎеҷЁд№Ӣй—ҙжҷ®йҖҡз”ЁжҲ·д№Ӣй—ҙsshж— еҜҶз Ғи®ҝй—®гҖӮ

е…ҲеңЁжүҖжңүдё»жңәдёҠе»әз«ӢзӣёеҗҢзҡ„з”ЁжҲ·пјҢжү§иЎҢе‘Ҫд»Өпјҡ

Useradd з”ЁжҲ·еҗҚ

Paswd з”ЁжҲ·еҗҚ

дҝ®ж”№hostfileж–Ү件еҶ…е®№пјҢеҗҢдёҠгҖӮ

жү§иЎҢйЎәеәҸзӣ®еҪ•/home/normalUserдёӢйқўзҡ„и„ҡжң¬

sh step2.exp жҷ®йҖҡз”ЁжҲ·еҜҶз Ғ

sh step3.exp жҷ®йҖҡз”ЁжҲ·еҗҚ еҜҶз Ғ

д»ҘдёҠи„ҡжң¬жү§иЎҢе®ҢжҲҗеҗҺдҪҝз”Ёrootе’Ңжҷ®йҖҡз”ЁжҲ·дҪҝз”Ёsshе‘Ҫд»ӨжөӢиҜ•еҗ„жңҚеҠЎеҷЁд№Ӣй—ҙжҳҜеҗҰеҸҜд»Ҙж— еҜҶз Ғи®ҝй—®гҖӮ

4. NFSй…ҚзҪ®

еңЁз®ЎзҗҶиҠӮзӮ№дёҠи®ҫзҪ®е…ұдә«зӣ®еҪ•пјҡ

touch /etc/exports

echo вҖҳ/home *(rw,insecure,no_root_squash,sync)вҖҷ>>/etc/exports

echo вҖҳ/hpc *(rw,insecure,no_root_squash,sync)вҖҷ>> /etc/exports

еҗҜеҠЁnfsжңҚеҠЎеҷЁ

systemctl start nfs.service

жҹҘзңӢnfsжңҚеҠЎзҠ¶жҖҒ

systemctl status nfs.service

и®ҫзҪ®nfsејҖжңәиҮӘеҗҜеҠЁ

systemctl enable nfs.service

еңЁи®Ўз®—иҠӮзӮ№дёҠжү§иЎҢmountе‘Ҫд»ӨжҠҠ/homeе’Ң/optжҢӮиҪҪеҲ°жң¬ең°пјҡ

mount -t nfs -o vers=3 hpc:/opt /opt

mount -t nfs -o vers=3 hpc:/home /home

5.е®үиЈ…й…ҚзҪ®NISжңҚеҠЎ

NISзҡ„дҪңз”ЁжҳҜи®©ж•ҙдёӘзі»з»ҹйҮҢзҡ„жңәеҷЁзҡ„иҙҰжҲ·иғҪз»ҹдёҖз®ЎзҗҶгҖӮ

yum install вҖ“y ypbind yp-tools ypser rpcbind protmap

NISзҡ„й…ҚзҪ®еҰӮдёӢпјҡ

1пјүserverз«Ҝзҡ„й…ҚзҪ®

1гҖҒејҖеҗҜдёӨдёӘжңҚеҠЎпјҡ

[root@admin пҪһ]# /sbin/chkconfig yppasswdd on

[root@admin пҪһ]# /sbin/chkconfig ypserv on

[root@admin пҪһ]# /sbin/service yppasswdd restart

[root@admin пҪһ]# /sbin/service ypserv restart

2гҖҒй…ҚзҪ®NISеҹҹеҗҚ

[root@admin пҪһ]# nisdomainname TS10K

(еҝ…йңҖе°Ҷnisdomainname TS10KеҠ е…ҘеҲ°nisжңҚеҠЎеҷЁзҡ„/etc/rc.d/rc.localж–Ү件йҮҢйқўжҲ–иҖ…жҠҠNISDOMAIN=TS10KеҠ е…ҘеҲ°/etc/sysconfig/netwokж–Ү件йҮҢ)

echo вҖң/bin/nisdomainnamehpcвҖқ>>/etc/rc.d/rc.local

echoвҖңNISDOMAIN=hpcвҖқ>>/etc/sysconfig/network

еҸҜд»ҘдҪҝз”ЁrpcinfoвҖ“u жң¬жңәеҗҚ ypserv еҜҹзңӢypservжҳҜеҗҰеҗҜеҠЁпјҢиӢҘжҲҗеҠҹеҗҜеҠЁдјҡзңӢеҲ°пјҡ

program 100004 version 1 ready and waiting

program 100004 version 2 ready and waiting

иӢҘжІЎзңӢеҲ°пјҢеҲҷжҠҠypservйҮҚж–°еҗҜеҠЁдёҖдёӢеҚіеҸҜгҖӮ

3гҖҒж•°жҚ®еҲқе§ӢеҢ–

[root@admin пҪһ]# cd /usr/lib/yp

[root@admin yp]#./ypinit вҖ“m жҲ–иҖ…/usr/lib64/yp/ypinit -m

ctl+dпјҲеҲҮи®°пјүжқҘз»“жқҹиҝҷдёӘе‘Ҫд»ӨпјҢеҶҚжү“е…ҘеӣһиҪҰ

еӣһиҪҰеҗҺдјҡжҳҫзӨәзұ»дјјеҶ…е®№пјҡadmin has been set up as a NISserver ,now you can run ypinit вҖ“s admin on all slave server.

еңЁserverз«ҜйҮҚж–°е»әз«Ӣж–°з”ЁжҲ·еҗҺпјҢйңҖиҰҒеҲ°/var/yp зӣ®еҪ•дёӢmakeдёҖдёӢ(еҪ“nis mapжңүд»»дҪ•дҝ®ж”№еҝ…йЎ»йҮҚж–°makeдёҖдёӢ)пјҢиҝҷж ·clientз«ҜжүҚиғҪдҪҝз”Ёж–°з”ЁжҲ·зҷ»еҪ•гҖӮ

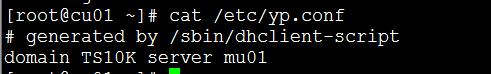

2пјүclientз«Ҝзҡ„й…ҚзҪ®

1гҖҒи®ҫе®ҡNIS client

setupвҶ’authentication configurationвҶ’[*]use NIS

еЎ«еҶҷпјҡDomainпјҡTS10K пјҲNISзҡ„еҹҹеҗҚпјү

Serverпјҡ admin пјҲserverз«Ҝзҡ„еҗҚз§°жҲ–иҖ…ipпјү

2гҖҒејҖеҗҜжңҚеҠЎ

[root@cu001 пҪһ]# /sbin/chkconfig ypbind on

[root@cu001 пҪһ]# /sbin/service ypbind restart

д№ҹеҸҜд»ҘзӣҙжҺҘдҝ®ж”№/etc/yp.confж–Ү件жқҘи®ҫе®ҡnis clientз«Ҝ

дҝ®ж”№е®ҢжҜ•еҗҺпјҢserviceypbind restartйҮҚеҗҜжңҚеҠЎеҚіеҸҜ

ж–°еўһз”ЁжҲ·ж—¶пјҢйңҖиҰҒжӣҙж–°nisиҙҰжҲ·е’Ңиө„ж–ҷеә“пјҡ

cd /var/yp make

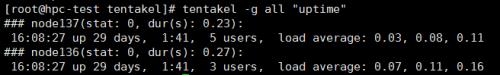

6.е®үиЈ…tentakel

и§ЈеҺӢиҪҜ件еҢ…pip-1.1.tar

иҝӣе…Ҙзӣ®еҪ•пјҡpip-1.1

cd pip-1.1

жү§иЎҢпјҡpython setup.py install

и§ЈеҺӢиҪҜ件еҢ…пјҡsfermigier-tentakel-1564958.zip

unzipsfermigier-tentakel-1564958.zip

cdsfermigier-tentakel-1564958

жү§иЎҢеҰӮдёӢе‘Ҫд»ӨиҝӣиЎҢе®үиЈ…пјҡ

pip install . (.жҳҜиЎЁзӨәеҪ“еүҚзӣ®еҪ•)

жӢ·иҙқй…ҚзҪ®ж–Ү件еҲ°/etc

cp tentakel.conf /etc

жөӢиҜ•tentakelжҳҜеҗҰз”ҹж•Ҳ

жү§иЎҢе‘Ҫд»Өпјҡtentakel вҖ“g all вҖңuptimeвҖқ

7.е®үиЈ…openmpi

е®үиЈ…жүҖйңҖдҫқиө–еҢ…пјҡ

yum install вҖ“ygcc-gfortran gcc gcc-c++ *aclocal

и§ЈеҺӢopenmpi-1.6.4.tar

tar вҖ“zxvf openmpi-1.6.4.tar

cd openmpi-1.6.4

дёӢйқўејҖе§Ӣзј–иҜ‘е®үиЈ…пјҡ

з”ҹжҲҗе®үиЈ…й…ҚзҪ®дҝЎжҒҜ

./configure --prefix=/hpc/openmpi CC=gcc CXX=g++F77=gfortran FC=gfortran

зј–иҜ‘е®үиЈ…

make && make install(еҝ…йЎ»иҰҒmakeе‘Ҫд»Өзј–иҜ‘жҲҗеҠҹжүҚжү§иЎҢmakeinstallејҖе§Ӣе®үиЈ…)

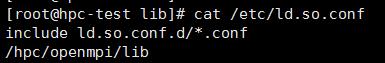

зј–иҫ‘ж–Ү件/etc/ ld.so.conf, ж–Ү件жң«е°ҫеҠ е…Ҙopenmpiзҡ„libзӣ®еҪ•и·Ҝеҫ„гҖӮ

vim /etc/ ld.so.conf

жү§иЎҢldconfigе‘Ҫд»Ө

зј–иҫ‘/etc/profileж–Ү件е’Ңз”ЁжҲ·зӣ®еҪ•дёӢйқўзҡ„.bashrcж–Ү件пјҢ.bashrcжҳҜйҡҗи—Ҹж–Ү件йңҖиҰҒдҪҝз”ЁlsвҖ“alе‘Ҫд»ӨжүҚеҸҜд»ҘзңӢеҲ°гҖӮ

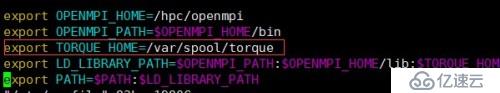

еҠ е…ҘеҰӮдёӢеҶ…е®№пјҡ

export OPENMPI_HOME=/hpc/openmpi

export OPENMPI_PATH=$OPENMPI_HOME/bin

export TORQUE_HOME=/var/spool/torque

exportLD_LIBRARY_PATH=$OPENMPI_PATH:$OPENMPI_HOME/lib:$TORQUE_HOME:$LD_LIBRARY_PATH

export PATH=$PATH:$LD_LIBRARY_PATH

еҶҚжү§иЎҢпјҡ

source/etc/profile

Source /home/з”ЁжҲ·/.bashrc

жөӢиҜ•openmpi

8.е®үиЈ…torque

TorqueеңЁж•ҙдёӘйӣҶзҫӨйҮҢйқўе……еҪ“д»»еҠЎи°ғеәҰзҡ„и§’иүІгҖӮ

д»ҘдёӢжӯҘйӘӨеңЁз®ЎзҗҶиҠӮзӮ№ж“ҚдҪң

е®үиЈ…torqueд№ӢеүҚйңҖиҰҒе…Ҳе®үиЈ…дҫқиө–еҢ…гҖӮ

yum update

yum install -ylibxml2-devel openssl-devel

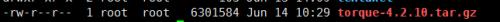

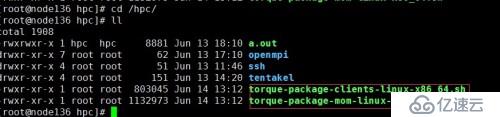

дёҠдј е®үиЈ…еҢ…

и§ЈеҺӢе®үиЈ…еҢ…

tar -zxvf torque-4.2.10.tar.gz

cd torque-4.2.10/

з”ҹжҲҗе®үиЈ…дҝЎжҒҜпјҢеҰӮжһңеҠ дәҶвҖ”perfixжҢҮе®ҡдәҶе®үиЈ…зӣ®еҪ•пјҢе°ұдјҡе®үиЈ…еҲ°жҢҮе®ҡзӣ®еҪ•пјҢеҰӮжһңдёҚеҠ дјҡе®үиЈ…еҲ°й»ҳи®Өзӣ®еҪ•/usr/local,жҲ‘иҝҷйҮҢдёҚжҢҮе®ҡзӣ®еҪ•пјҢе®үиЈ…й»ҳи®Өзӣ®еҪ•дёӢгҖӮ

жү§иЎҢ ./configure

з”ҹжҲҗе®үиЈ…й…ҚзҪ®дҝЎжҒҜеҗҺжү§иЎҢеҰӮдёӢе‘Ҫд»ӨиҝӣиЎҢзј–иҜ‘е®үиЈ…пјҡ

make && make install

жӢ·иҙқжңҚеҠЎеҗҜеҠЁзЁӢеәҸеҲ°/etc/init.d/

cp torque/contrib/init.d/trqauthd/etc/init.d/

cp torque/contrib/init.d/pbs_server/etc/init.d/

cp torque/contrib/init.d/pbs_sched}/etc/init.d/

ж·»еҠ trqauthеҲ°жңҚеҠЎеҲ—иЎЁ

и®ҫзҪ®д»ҘдёҠжңҚеҠЎејҖжңәиҮӘеҗҜпјҡ

chkconfig pbs_server on

chkconfig pbs_sched on

chkconfig trqauthd on

жү§иЎҢеҰӮдёӢе‘Ҫд»Өпјҡ

echo /usr/local/lib > /etc/ld.so.conf.d/torque.conf

ldconfig

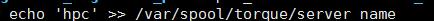

echo <pbs_server's_hostname> >/var/spool/torque/server_name

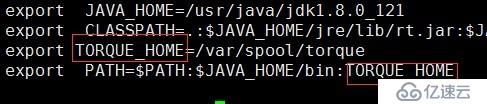

ж·»еҠ TORQUE_HOMEHзҺҜеўғеҸҳйҮҸ

vim /etc/profile

жү§иЎҢе‘Ҫд»Өпјҡ source /etc/profile

еңЁе®үиЈ…еҢ…зӣ®еҪ•дёӢйқўжү§иЎҢпјҡ

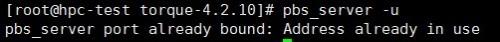

жү§иЎҢпјҡpbs_server вҖ“u

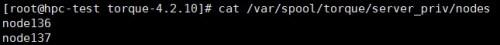

touch /var/spool/torque/server_priv/nodes

vim /var/spool/torque/server_priv/nodes еҠ е…ҘжүҖжңүи®Ўз®—жңәиҠӮзӮ№гҖӮ

е®үиЈ…и®Ўз®—иҠӮзӮ№пјҡ

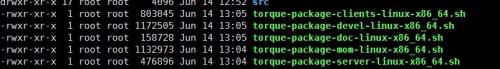

еңЁз®ЎзҗҶиҠӮзӮ№зҡ„torqueе®үиЈ…еҢ…зӣ®еҪ•дёӢжү§иЎҢ:makepackages

з”ҹжҲҗдәҶеҮ дёӘshellи„ҡжң¬:

еңЁз®ЎзҗҶиҠӮзӮ№дёҠжү§иЎҢпјҡ

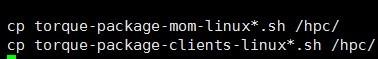

cp torque-package-mom-linux*.sh /shared_storage/ ----/shared_storage жҢҮзҡ„жҳҜе…ұдә«еӯҳеӮЁзӣ®еҪ•

cp torque-package-clients-linux*.sh /shared_storage/

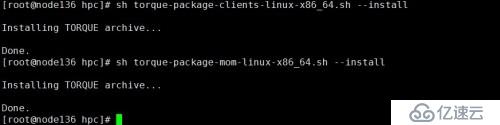

еңЁжүҖжңүи®Ўз®—иҠӮзӮ№дёҠжү§иЎҢпјҡ

cd еҲ°е…ұдә«зӣ®еҪ•

жү§иЎҢtorque-package-clients-linux-x86_64.shе’Ңtorque-package-mom-linux-x86_64.sh

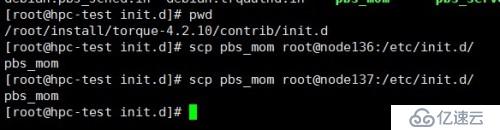

жҠҠз®ЎзҗҶиҠӮзӮ№дёҠзҡ„е®үиЈ…еҢ…зӣ®еҪ•йҮҢзҡ„contrib/init.d/pbs_momжӢ·иҙқеҲ°жүҖжңүи®Ўз®—иҠӮзӮ№зҡ„/etc/init.d/зӣ®еҪ•гҖӮ

жҠҠpbs_momеҠ е…ҘжңҚеҠЎеҲ—иЎЁ

chkconfig--add pbs_mom

и®ҫзҪ®pbs_momжңҚеҠЎејҖжңәиҮӘеҗҜеҠЁ

chkconfigpbs_mom on

еңЁз®ЎзҗҶиҠӮзӮ№зј–еҶҷи„ҡжң¬пјҡ

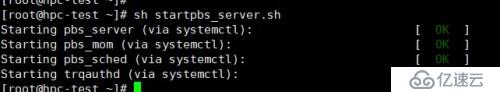

startpbs_server.shе’Ңshutpbs_server.sh

startpbs_server.shз”ЁжқҘеҗҜеҠЁжүҖжңүpbsжңҚеҠЎпјҢеҶ…е®№еҰӮдёӢпјҡ

#!/bin/bash

for iin pbs_server pbs_mom pbs_sched trqauthd;

do

/etc/init.d/$istart

done

shutpbs_server.shз”ЁжқҘеҒңжӯўжүҖжңүpbsжңҚеҠЎпјҢеҶ…е®№еҰӮдёӢпјҡ

#!/bin/bash

for iin pbs_server pbs_mom pbs_sched trqauthd;

do

/etc/init.d/$istop

done

ж·»еҠ жү§иЎҢжқғйҷҗ:

chmod+x startpbs_server.sh

chmod+x shutpbs_server.sh

жү§иЎҢпјҡshstartpbs_server.shеҗҜеҠЁжүҖжңүжңҚеҠЎгҖӮ

еңЁи®Ўз®—иҠӮзӮ№зҡ„зј–иҫ‘/etc/profileж–Ү件еҠ е…ҘTORQUE_HOMEзҺҜеўғеҸҳйҮҸ

source/etc/profile

еңЁи®Ўз®—иҠӮзӮ№жү§иЎҢпјҡ

#echo /usr/local/lib> /etc/ld.so.conf.d/torque.conf

#ldconfig

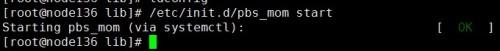

еҗҜеҠЁpbs_server

/etc/init.d/pbs_momstart

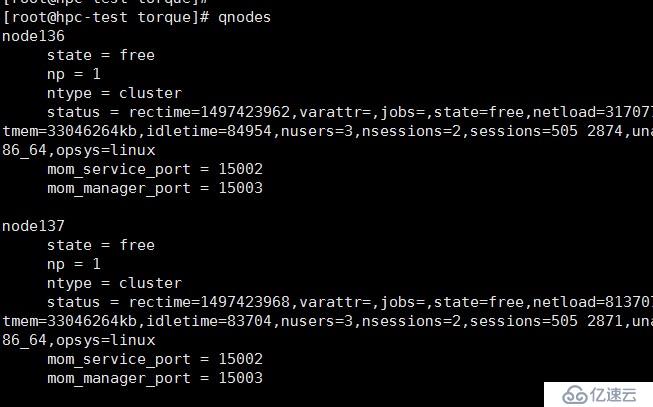

еңЁз®ЎзҗҶиҠӮзӮ№жү§иЎҢе‘Ҫд»Өпјҡqnodes

зҠ¶жҖҒдёәfreeе°ұжҳҜжӯЈеёёзҡ„пјҢдёәdownе°ұжҳҜи®Ўз®—иҠӮзӮ№зҡ„pbs_momжңҚеҠЎжҢӮдәҶгҖӮ

зј–еҶҷжөӢиҜ•и„ҡжң¬пјҡ

test.pbsеҶ…е®№еҰӮдёӢпјҡ

#PBS-l nodes=1

##PBS-N test_1

#PBS-S /bin/bash

mpiexecвҖ“H localhost,node136,node137 -np 30 /home/hpc/a.out > /home/hpc/cu1111.log2>&1

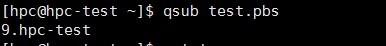

su вҖ“ жҷ®йҖҡз”ЁжҲ·

жҸҗдәӨдҪңдёҡпјҡ

qsub test.pbs

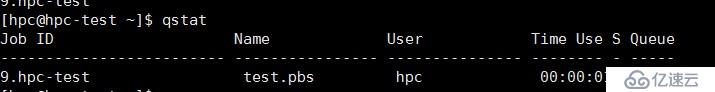

жҹҘзңӢдҪңдёҡйҳҹеҲ—пјҡ

qstat

зҠ¶жҖҒдёәCиЎЁзӨәдҪңдёҡжү§иЎҢе®ҢжҲҗпјҢдёәEиЎЁзӨәдҪңдёҡжү§иЎҢе®ҢжҲҗжӯЈеңЁйҖҖеҮәгҖӮ

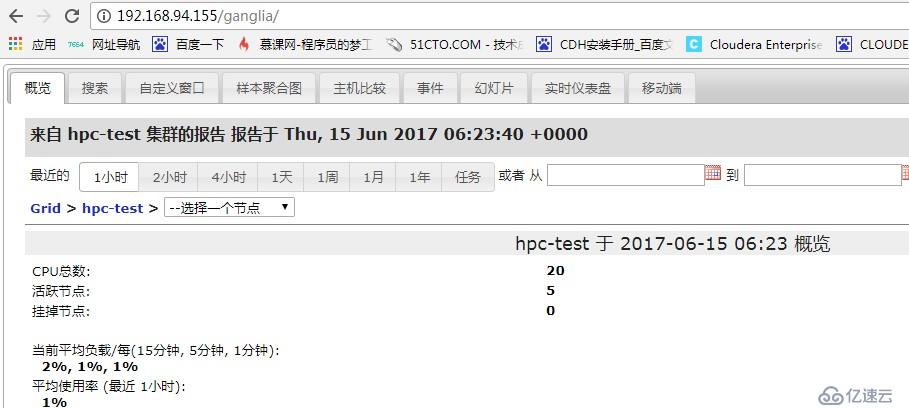

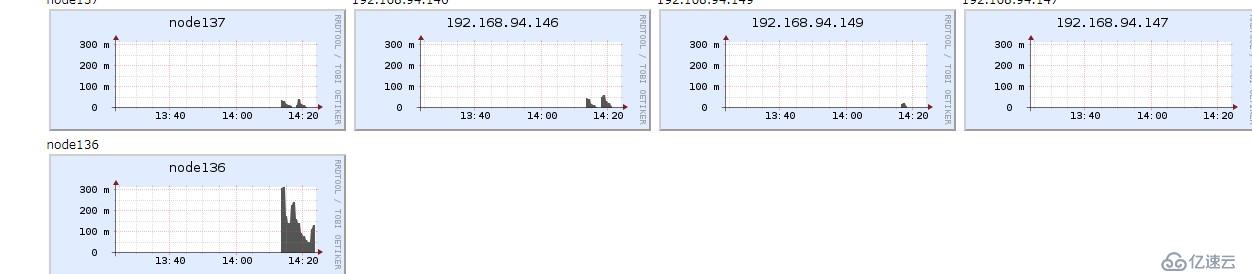

9.е®үиЈ…gangliaзӣ‘жҺ§

Gangliaз”ұgmondгҖҒgmetadе’ҢgwebдёүйғЁеҲҶз»„жҲҗ

gmondпјҲGangliaMonitoring DaemonпјүжҳҜдёҖз§ҚиҪ»йҮҸзә§жңҚеҠЎпјҢе®үиЈ…еңЁжҜҸеҸ°йңҖиҰҒ收йӣҶжҢҮж Үж•°жҚ®зҡ„иҠӮзӮ№дё»жңәдёҠгҖӮgmondеңЁжҜҸеҸ°дё»жңәдёҠе®ҢжҲҗе®һйҷ…ж„Ҹд№үдёҠзҡ„жҢҮж Үж•°жҚ®ж”¶йӣҶе·ҘдҪңпјҢ并йҖҡиҝҮдҫҰеҗ¬/йҖҡе‘ҠеҚҸи®®е’ҢйӣҶзҫӨеҶ…е…¶д»–иҠӮзӮ№е…ұдә«ж•°жҚ®гҖӮдҪҝз”ЁgmondпјҢдҪ еҸҜд»ҘеҫҲе®№жҳ“收йӣҶеҫҲеӨҡзі»з»ҹжҢҮж Үж•°жҚ®пјҢеҰӮCPUгҖҒеҶ…еӯҳгҖҒзЈҒзӣҳгҖҒзҪ‘з»ңе’Ңжҙ»и·ғиҝӣзЁӢзҡ„ж•°жҚ®зӯүгҖӮ

gmetadпјҲGangliaMeta DaemonпјүжҳҜдёҖз§Қд»Һе…¶д»–gmetadжҲ–gmondжәҗ收йӣҶжҢҮж Үж•°жҚ®пјҢ并е°Ҷе…¶д»ҘRRDж јејҸеӯҳеӮЁиҮізЈҒзӣҳзҡ„жңҚеҠЎгҖӮgmetadдёәд»Һдё»жңә组收йӣҶзҡ„зү№е®ҡжҢҮж ҮдҝЎжҒҜжҸҗдҫӣдәҶз®ҖеҚ•зҡ„жҹҘиҜўжңәеҲ¶пјҢ并ж”ҜжҢҒеҲҶзә§жҺҲжқғпјҢдҪҝеҫ—еҲӣе»әиҒ”еҗҲзӣ‘жөӢеҹҹжҲҗдёәеҸҜиғҪгҖӮ

gwebпјҲGangliaWebпјүgwebжҳҜдёҖз§ҚеҲ©з”ЁжөҸи§ҲеҷЁжҳҫзӨәgmetadжүҖеӯҳеӮЁж•°жҚ®зҡ„PHPеүҚз«ҜгҖӮеңЁWebз•Ңйқўдёӯд»ҘеӣҫиЎЁж–№ејҸеұ•зҺ°йӣҶзҫӨзҡ„иҝҗиЎҢзҠ¶жҖҒдёӢ收йӣҶзҡ„еӨҡз§ҚдёҚеҗҢжҢҮж Үж•°жҚ®гҖӮ

з®ЎзҗҶиҠӮзӮ№йңҖиҰҒе®үиЈ…зҡ„组件пјҡ

gmetad

http

php

gweb

и®Ўз®—иҠӮзӮ№йңҖиҰҒе®үиЈ…зҡ„组件пјҡ

gmond

еңЁжүҖжңүиҠӮзӮ№жү§иЎҢдёӢйқўзҡ„ж“ҚдҪңпјҡ

е®үиЈ…иҪҜ件жәҗпјҡwget http://dl.fedoraproject.org/pub/epel/6/x86_64/epel-release-6-8.noarch.rpm

rpm вҖ“ivh epel-release-6-8.noarch.rpm

жү§иЎҢеҰӮдёӢе‘Ҫд»Өпјҡ

yum clean all

yum makecach

yum update вҖ“y

yum search ganglia-gmetad ganglia-gmond

еҰӮжһңyum searchе‘Ҫд»ӨеҸҜд»ҘжүҫеҲ°gangliaиҪҜ件еҢ…еңЁејҖе§Ӣе®үиЈ…з®ЎзҗҶиҠӮзӮ№е’Ңи®Ўз®—иҠӮзӮ№гҖӮ

е®үиЈ…з®ЎзҗҶиҠӮзӮ№пјҡ

е®үиЈ…gmetad

жү§иЎҢ:

yum installganglia-gmetad -y

е®үиЈ…ganglia-web

еңЁе®үиЈ…ganglia-webд№ӢеүҚйңҖиҰҒе…Ҳе®үиЈ…httpdе’Ңphp

жү§иЎҢ:

yum install httpd php

е»әз«Ӣgangliaзҡ„webзӣ®еҪ•пјҡ

mkdir /var/www/html/ganglia

жҠҠganglia-webдёӢйқўзҡ„жүҖжңүж–Ү件жӢ·иҙқеҲ°/var/www/html/ganglia

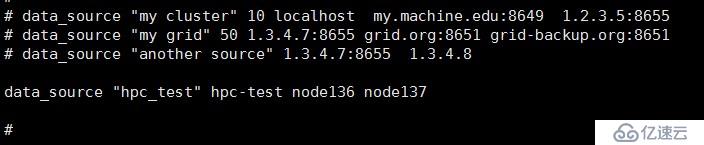

й…ҚзҪ®з®ЎзҗҶиҠӮзӮ№пјҡ

й…ҚзҪ®gmetad

дҝ®ж”№gmetadжңҚеҠЎзҡ„й…ҚзҪ®й…Қж–Ү件пјҡ

vim /etc/ganglia/gmetad.conf

дҝ®ж”№data_sourceеҸӮж•°

ж јејҸдёәпјҡdata_source вҖңйӣҶзҫӨеҗҚз§°вҖқ host1:portпјҢhost2:portпјҢ.. hostN:port

еҰӮжһңдёҚжҢҮе®ҡз«ҜеҸЈдјҡдҪҝз”Ёй»ҳи®Өз«ҜеҸЈпјҡ8649

й…ҚзҪ®ganglia-web

Gangliaзҡ„webзӣ‘жҺ§з•ҢйқўжҳҜеҹәдәҺPHPзҡ„пјҢеӣ жӯӨйңҖиҰҒе®үиЈ…PHPзҺҜеўғпјҢPHPзҺҜеўғзҡ„е®үиЈ…дёҚеңЁд»Ӣз»ҚпјҢеҸҜд»ҘеңЁhttp://sourceforge.net/projects/ganglia/files/дёӢиҪҪganglia-webпјҢ然еҗҺж”ҫеҲ°webж №зӣ®еҪ•еҚіеҸҜгҖӮ

й…ҚзҪ®gangliaзҡ„webз•ҢйқўжҜ”иҫғз®ҖеҚ•пјҢеҸӘйңҖиҰҒдҝ®ж”№еҮ дёӘphpж–Ү件еҚіеҸҜпјҢйҰ–е…Ҳ第дёҖдёӘжҳҜconf_default.phpпјҢеҸҜд»Ҙе°Ҷconf_default.phpйҮҚе‘ҪеҗҚдёәconf.phpпјҢд№ҹеҸҜд»ҘдҝқжҢҒдёҚеҸҳпјҢgangliaзҡ„webй»ҳи®Өе…Ҳжүҫconf.phpпјҢжүҫдёҚеҲ°дјҡ继з»ӯжүҫconf_default.phpпјҢйңҖиҰҒдҝ®ж”№зҡ„еҶ…е®№еҰӮдёӢпјҡ

$conf['gmetad_root'] ="/var/www/html/ganglia/"; # ganglia webж №зӣ®еҪ•

$conf['rrds'] ="${conf['gmetad_root']}/rrds"; #ganglia webиҜ»еҸ–rrdsж•°жҚ®еә“зҡ„и·Ҝеҫ„

$conf['dwoo_compiled_dir'] ="${conf['gmetad_root']}/dwoo/compiled"; #йңҖиҰҒ777жқғйҷҗ

$conf['dwoo_cache_dir'] ="${conf['gmetad_root']}/dwoo/cache"; #йңҖиҰҒ777жқғйҷҗ

$conf['rrdtool'] ="/usr/bin/rrdtool"; #жҢҮе®ҡrrdtoolзҡ„и·Ҝеҫ„

$conf['graphdir']= $conf['gweb_root'] .'/graph.d'; #з”ҹжҲҗеӣҫеҪўжЁЎжқҝзӣ®еҪ•

$conf['ganglia_ip'] ="127.0.0.1"; #gmetadжңҚеҠЎеҷЁзҡ„ең°еқҖ

$conf['ganglia_port'] = 8652; #gmetadжңҚеҠЎеҷЁзҡ„дәӨдә’ејҸжҸҗдҫӣзӣ‘жҺ§ж•°жҚ®з«ҜеҸЈеҸ‘еёғ

жү§иЎҢеҰӮдёӢе‘Ҫд»Өпјҡ

chmod 777 -R /var/www/html/ganglia/dwoo/cache/

й…ҚзҪ®и®Ўз®—иҠӮзӮ№gmondжңҚеҠЎ

еңЁжүҖжңүи®Ўз®—иҠӮзӮ№жү§иЎҢеҰӮдёӢе‘Ҫд»Өпјҡ

yum install ganglia-gmond вҖ“y

gmondжңҚеҠЎй…ҚзҪ®

gmondжңҚеҠЎй…ҚзҪ®ж–Ү件жҳҜ/etc/ganglia/gmond.conf

йғЁеҲҶй…ҚзҪ®иҜҙжҳҺеҰӮдёӢпјҡ

globals {

daemonize = yes #д»ҘеҗҺеҸ°зҡ„ж–№ејҸиҝҗиЎҢ

setuid = yes

user = nobody #иҝҗиЎҢgmondзҡ„з”ЁжҲ·

debug_level = 0 #и°ғиҜ•зә§еҲ«

max_udp_msg_len = 1472

mute = no #жң¬иҠӮзӮ№е°ҶдёҚдјҡеҶҚе№ҝж’ӯд»»дҪ•иҮӘе·ұ收йӣҶеҲ°зҡ„ж•°жҚ®еҲ°зҪ‘з»ңдёҠ

deaf = no #жң¬иҠӮзӮ№е°ҶдёҚеҶҚжҺҘ收任дҪ•е…¶д»–иҠӮзӮ№е№ҝж’ӯзҡ„ж•°жҚ®еҢ…

allow_extra_data = yes

host_dmax = 0 /*secs */

cleanup_threshold = 300 /*secs */

gexec = no #жҳҜеҗҰдҪҝз”Ёgexec

send_metadata_interval = 0

}

cluster {

name = "Cluster1" #жң¬иҠӮзӮ№еұһдәҺе“ӘдёӘcluster

owner = "junfeng" #жҢҮе®ҡиҜҘиҠӮзӮ№зҡ„жүҖжңүиҖ…

latlong = "unspecified" #еңЁең°зҗғдёҠзҡ„еқҗж ҮпјҢз»ҸеәҰгҖҒзә¬еәҰ

url = "unspecified"

}

host {

location = "unspecified"

}

udp_send_channel { #udpеҢ…зҡ„еҸ‘йҖҒйҖҡйҒ“

mcast_join = 239.2.11.71 #еӨҡж’ӯжЁЎејҸпјҢе·ҘдҪңеңЁ239.2.11.71йҖҡйҒ“дёӢгҖӮеҰӮжһңдҪҝз”ЁеҚ•ж’ӯжЁЎејҸпјҢеҲҷиҰҒ еҶҷжҲҗhost = host1пјҢеҚ•ж’ӯжЁЎејҸдёӢд№ҹеҸҜд»Ҙй…ҚзҪ®еӨҡдёӘudp_send_channel

port = 8649 #зӣ‘еҗ¬з«ҜеҸЈ

ttl = 1

}

udp_recv_channel { #жҺҘ收udpеҢ…й…ҚзҪ®

mcast_join = 239.2.11.71 #еҗҢж ·е·ҘдҪңеңЁ239.2.11.71йҖҡйҒ“дёӢ

port = 8649 #зӣ‘еҗ¬з«ҜеҸЈ

bind = 239.2.11.71 #з»‘е®ҡ

}

tcp_accept_channel {

port = 8649 #йҖҡиҝҮtcpеҚҸи®®зӣ‘еҗ¬зҡ„з«ҜеҸЈпјҢиҝңз«ҜеҸҜд»ҘйҖҡиҝҮй“ҫжҺҘ8649з«ҜеҸЈеҫ—еҲ°зӣ‘жҺ§ж•°жҚ®

}

еңЁжӯӨж–ҮжЎЈдёӯжҲ‘们еҸӘйңҖиҰҒдҝ®ж”№cluser{вҖҰвҖҰ.}йғЁеҲҶеҰӮдёӢпјҡ

nameеӯ—ж®өйңҖиҰҒе’Ңз®ЎзҗҶиҠӮзӮ№дёҖиҮҙгҖӮ

еңЁз®ЎзҗҶиҠӮзӮ№жү§иЎҢпјҡ

systemctl enablegmetad.service

systemctl startgmetad.service

systemctl enablehttpd.service

systemctl enablehttpd.service

еңЁи®Ўз®—иҠӮзӮ№жү§иЎҢпјҡ

systemctl enablegmond.service

systemctl start gmond.service

дёӢйқўжҳҜи§ҒиҜҒеҘҮиҝ№зҡ„ж—¶еҲ»гҖӮ

еңЁжөҸи§ҲеҷЁең°еқҖж ҸйҮҢйқўиҫ“е…Ҙпјҡ

http://apache-hosot/ganglia

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ