жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

Mongodbж”ҜжҢҒеңЁеӨҡдёӘжңәеҷЁдёӯйҖҡиҝҮејӮжӯҘеӨҚеҲ¶иҫҫеҲ°ж•…йҡңиҪ¬з§»е’Ңе®һзҺ°еҶ—дҪҷпјҢеӨҡжңәеҷЁд№Ӣй—ҙеҗҢдёҖж—¶еҲ»еҸӘжңүдёҖеҸ°жҳҜз”ЁдәҺеҶҷж“ҚдҪңпјҢжӯЈжҳҜз”ұдәҺиҝҷдёӘзү№жҖ§пјҢдёәmongodbжҸҗдҫӣдәҶж•°жҚ®дёҖиҮҙжҖ§зҡ„дҝқиҜҒпјҢжӢ…еҪ“primaryи§’иүІзҡ„жңәеҷЁиғҪжҠҠиҜ»ж“ҚдҪңеҲҶеҸ‘з»ҷslave

Mongodbй«ҳеҸҜз”ЁеҲҶдёӨз§Қпјҡ

Master-slave дё»д»ҺеӨҚеҲ¶

еҸӘйңҖиҰҒеңЁжҹҗдёҖдёӘжңҚеҠЎеҗҜеҠЁж—¶еҠ дёҠ--masterеҸӮж•°пјҢиҖҢеҸҰеӨ–дёҖдёӘжңҚеҠЎеҠ дёҠ-slaveдёҺ-sourceеҸӮж•°пјҢеҚіеҸҜе®һзҺ°еҗҢжӯҘпјҢmongodbзҡ„жңҖж–°зүҲжң¬е·Із»ҸдёҚеңЁж”ҜжҢҒжӯӨж–№жЎҲдәҶ

Replica sets еӨҚеҲ¶йӣҶпјҡ

MongodbжҳҜд»Һ1.6зүҲжң¬ејҖеҸ‘дәҶж–°еҠҹиғҪreplica setsпјҢиҝҷдёӘжҜ”master-slaveеҠҹиғҪжӣҙеҠ ејәеӨ§дёҖдәӣпјҢеўһеҠ дәҶж•…йҡңиҮӘеҠЁеҲҮжҚўе’ҢиҮӘеҠЁдҝ®еӨҚжҲҗе‘ҳиҠӮзӮ№пјҢеҗ„дёӘDBд№Ӣй—ҙзҡ„ж•°жҚ®е®Ңе…ЁдёҖиҮҙпјҢеӨ§еӨ§йҷҚдҪҺдәҶз»ҙжҠӨжҲҗжң¬гҖӮAuto sharedе·Із»ҸжҳҺзЎ®иҜҙжҳҺдёҚеңЁж”ҜжҢҒreplication parisпјҢе»әи®®дҪҝз”Ёreplica setпјҢreplica setж•…йҡңеҲҮжҚўе®Ңе…ЁиҮӘеҠЁеҢ–

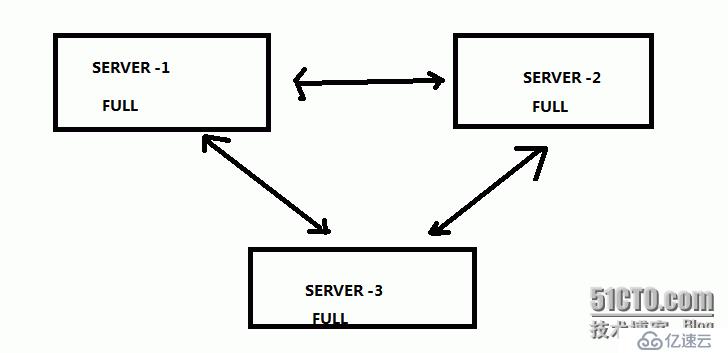

еҒҮи®ҫдёҖдёӘдёүиҠӮзӮ№зҡ„mongodbйӣҶзҫӨ

дёүдёӘиҠӮзӮ№server-1гҖҒ-2гҖҒ-3ж— и®әе“ӘдёҖдёӘиҠӮзӮ№еҮәзҺ°ж•…йҡңпјҢе…¶д»–иҠӮзӮ№й©¬дёҠдјҡе°ҶдёҡеҠЎжҺҘиҪ¬иҝҮжқҘиҖҢж— йңҖеҒңжңәж“ҚдҪң

дё»иҰҒеӯҰд№ replica set еӨҚеҲ¶йӣҶ

replica setеҸҜд»Ҙе®һзҺ°иҮӘеҠЁзҡ„failoverе’ҢиҮӘеҠЁзҡ„recoveryгҖӮ

replica setз”ұдёӨдёӘжҲ–иҖ…жӣҙеӨҡзҡ„иҠӮзӮ№з»„жҲҗпјҢе®һзҺ°еҪјжӯӨзҡ„еӨҚеҲ¶гҖӮ

replica setиҮӘеҠЁйҖүжӢ©primaryиҠӮзӮ№пјҢжІЎжңүдёҖдёӘиҠӮзӮ№жҳҜеӣәе®ҡзҡ„primaryгҖӮ

mongosдјҡиҮӘеҠЁеҸ‘зҺ°дёҖдёӘreplica setзҡ„primaryиҠӮзӮ№еҸ‘з”ҹеҸҳеҢ–пјҢ并е°ҶеҶҷж“ҚдҪңеҸ‘йҖҒз»ҷиҝҷдёӘж–°зҡ„primaryиҠӮзӮ№гҖӮ

йҖҡеёёз”ЁдәҺдёӢйқўеҮ дёӘеңәжҷҜ

ж•°жҚ®еҶ—дҪҷгҖӮ

иҮӘеҠЁfailoverпјҢжҸҗдҫӣй«ҳеҸҜз”ЁжҖ§зҡ„жңҚеҠЎгҖӮ

еҲҶж•ЈиҜ»зҡ„иҙҹиҪҪгҖӮ

з®ҖеҢ–з»ҙжҠӨ(зӣёеҜ№дәҺmaster-slaveжқҘиҜҙпјүгҖӮ

зҒҫйҡҫжҒўеӨҚгҖӮ

йҰ–е…ҲиҝҳжҳҜеҗҜеҠЁmongodпјҢз”ЁдәҺreplica setзҡ„еҸӮж•°жңүдёӨдёӘпјҡ

--replSet <setname>пјҢеӨҚеҲ¶йӣҶзҡ„еҗҚз§°гҖӮ

--oplogSize <MB>пјҢж“ҚдҪңж—Ҙеҝ—зҡ„еӨ§е°ҸпјҢеҚ•дҪҚдёәMBгҖӮпјҲдёҖиҲ¬жҳҜзЈҒзӣҳз©әй—ҙзҡ„5%пјүпјӣ

Mongodbзҡ„зүҲжң¬пјҡ

[root@anenjoy mongodb]# /usr/local/mongodb/bin/mongo -version

MongoDB shell version: 2.4.8

е®һйӘҢдёӯдёүеҸ°иҷҡжӢҹжңәзҡ„IPпјҡ

192.168.1.247

192.168.1.248

192.168.1.250

е…ҲеңЁеҗ„дёӘserverдё»жңәдёҠжҗӯе»әmongodbзҡ„е®үиЈ…пјҢй…ҚзҪ®еӯҳеӮЁи·Ҝеҫ„

е®үиЈ…е°ұжҳҜи§ЈеҺӢеҢ…пјҢдёҚеҶҚз»Ҷиҝ°

第дёүжӯҘпјҡеҗҜеҠЁmongodb

е‘Ҫд»ӨеҸӮж•°пјҡ

SERVER -1

/usr/local/mongodb/bin/mongod --port 27017 --replSet res1 --keyFile /data/mon_db/key/res1 --oplogSize 100 --dbpath=/data/mon_db/res1/ --logpath=/usr/local/mongodb/log/mongodb.log --logappend --fork

еҸӮж•°иҜҰи§Јпјҡ--port жҳҜз«ҜеҸЈеҸ·

--replSet жҳҜreplica setзҡ„ж ҮиҜҶеҸӮж•°пјҢеҗҺи·ҹsetеҗҚз§°

--keyFile е°ұжҳҜж ҮиҜҶиҝӣзҫӨзҡ„з§Ғй’Ҙж–Ү件

--oplogSize replicaж“ҚдҪңзҡ„ж—Ҙеҝ—пјҢжҳҜеҸҜд»Ҙcrapped collectionпјҢеҸҜеҫӘзҺҜдҪҝз”Ёзҡ„пјҢеӨ§е°Ҹ100MB

--dbpath ж•°жҚ®ж–Ү件зҡ„еӯҳеӮЁи·Ҝеҫ„

--logpath ж—Ҙеҝ—ж–Ү件и·Ҝеҫ„ --logappendжҳҜж—Ҙеҝ—иҝҪеҠ

--fork еҗҺеҸ°иҝҗиЎҢзЁӢеәҸ

SERVER -2

/usr/local/mongodb/bin/mongod --port 27018 --replSet res1 --keyFile /data/mon_db/key/res2 --oplogSize 100 --dbpath=/data/mon_db/res2/ --logpath=/usr/local/mongodb/log/mongodb.log --logappend --fork

SERVER -3

/usr/local/mongodb/bin/mongod --port 27019 --replSet res1 --keyFile /data/mon_db/key/res3 --oplogSize 100 --dbpath=/data/mon_db/res3/ --logpath=/usr/local/mongodb/log/mongodb.log --logappend --fork

еҗ„иҮӘеҗҜеҠЁпјҢжіЁж„Ҹе®һж—¶и§ӮеҜҹlogж–Ү件зҡ„еҸҳеҢ–пјҢзңӢжҳҜеҗҰжңүй—®йўҳдә§з”ҹпјҲtail mongodb.log -f)

еҰӮжһңйҒҮеҲ°errorдҝЎжҒҜпјҡ

[rsStart] replSet can't get local.system.replset config from self or any seed (EMPTYCONFIG)

иЎЁзӨәдҪ иҝҳжІЎжңүжү§иЎҢеҲқе§ӢеҢ–пјҢиҝҷдёӘжҡӮж—¶дёҚз”ЁиҖғиҷ‘

第еӣӣжӯҘпјҡеҲқе§ӢеҢ–

зҷ»еҪ•д»»ж„ҸдёҖеҸ°serverзҡ„mongodbж•°жҚ®еә“

[root@test02 bin]# /usr/local/mongodb/bin/mongo --port 27017

MongoDB shell version: 2.4.8

connecting to: 127.0.0.1:27017/test

>

й…ҚзҪ®еҲқе§ӢеҢ–ж–Ү件

config_res1={_id:'res1',members:[

{_id:0,host:'192.168.1.248:27017',priority:2},

{_id:1,host:'192.168.1.247:27018',priority:0}

{_id:2,host:'192.168.1.250:27019',priority:1}]

}

"_id" : "res1",

"members" : [

{

"_id" : 0,

"host" : "192.168.1.248:27017",

"priority" : 2

},

{

"_id" : 1,

"host" : "192.168.1.247:27018",

"priority" : 0

},

{

"_id" : 2,

"host" : "192.168.1.250:27019",

"priority" : 1

}

]

}

Priority дјҳе…Ҳзә§пјҢеҖји¶ҠеӨ§пјҢиЎЁзӨәжҳҜprimaryпјҢеҪ“primaryе®•жңәж—¶пјҢе°ұдјҡдҪҝз”Ёpriority еҖјж¬Ўд№Ӣзҡ„еҪ“primary и§’иүІ

> rs.initiate(config_res1);

{

"info" : "Config now saved locally. Should come online in about a minute.",

"ok" : 1

}

_id:вҖҷres1вҖҷиҝҷдёӘ_id:зҡ„еҖјеҝ…йЎ»жҳҜдҪ setйӣҶеҗҲзҡ„еҗҚз§°пјҢе°ұжҳҜ--replSetзҡ„йӣҶеҗҲеҗҚз§°пјҢеҗҰеҲҷе°ұжҳҜжҸҗзӨәдҪ

Error message дҝЎжҒҜ

"errmsg" : "couldn't initiate : set name does not match the set name host 192.168.1.247:27018 expects"

д№ӢеҗҺжҹҘзңӢзҠ¶жҖҒ

rs.status();

{

"set" : "res1", ###set йӣҶеҗҚз§°

"date" : ISODate("2013-12-04T00:37:08Z"), еҲӣе»әж—Ҙжңҹ

"myState" : 1,

"members" : [

{

"_id" : 0,

"name" : "192.168.1.248:27017",

"health" : 1, 1иЎЁзӨәжӯЈеёёи®ҝй—®пјҢ0ејӮеёё

"state" : 1, 1иЎЁзӨәжҳҜprimary пјҢ2иЎЁзӨәsecondary

"stateStr" : "PRIMARY", primary дё»еә“

"uptime" : 1632,

"optime" : Timestamp(1386116964, 1),

"optimeDate" : ISODate("2013-12-04T00:29:24Z"),

"self" : true

},

{

"_id" : 1,

"name" : "192.168.1.247:27018",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY",

"uptime" : 461,

"optime" : Timestamp(1386116964, 1),

"optimeDate" : ISODate("2013-12-04T00:29:24Z"),

"lastHeartbeat" : ISODate("2013-12-04T00:37:07Z"),

"lastHeartbeatRecv" : ISODate("2013-12-04T00:37:07Z"),

"pingMs" : 0,

"syncingTo" : "192.168.1.248:27017"

},

{

"_id" : 2,

"name" : "192.168.1.250:27019",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY",

"uptime" : 461,

"optime" : Timestamp(1386116964, 1),

"optimeDate" : ISODate("2013-12-04T00:29:24Z"),

"lastHeartbeat" : ISODate("2013-12-04T00:37:08Z"),

"lastHeartbeatRecv" : ISODate("2013-12-04T00:37:08Z"),

"pingMs" : 1,

"syncingTo" : "192.168.1.248:27017"

}

],

"ok" : 1

}

еҗҢжӯҘеҘҪдҝЎжҒҜд№ӢеҗҺпјҢжҹҘзңӢеҸҰеӨ–дёӨдёӘmongodbзҡ„ж—Ҙеҝ—пјҢе°ұдјҡеҸ‘зҺ°

Fri Dec 6 15:48:48.380 [conn33] end connection 192.168.1.247:25633 (1 connection now open)

Fri Dec 6 15:48:48.381 [initandlisten] connection accepted from 192.168.1.247:25635 #35 (2 connections now open)

Fri Dec 6 15:48:48.383 [conn35] authenticate db: local { authenticate: 1, nonce: "6d6fb8a5d540c164", user: "__system", key: "51b0f27144ec17860f1ca2bd245807ce" }

иЎЁзӨәжӯЈеёёзҡ„

д№ҹеҸҜд»ҘдҪҝз”Ё

res1:PRIMARY> rs.isMaster();жҹҘзңӢreplica setзҡ„дҝЎжҒҜ

{

"setName" : "res1",

"ismaster" : true,

"secondary" : false,

"hosts" : [

"192.168.1.248:27017",

"192.168.1.250:27019"

],

"passives" : [

"192.168.1.247:27018"

],

"primary" : "192.168.1.248:27017",

"me" : "192.168.1.248:27017",

"maxBsonObjectSize" : 16777216,

"maxMessageSizeBytes" : 48000000,

"localTime" : ISODate("2013-12-04T00:42:57.347Z"),

"ok" : 1

Replica setзҡ„й…ҚзҪ®ж–Ү件пјҢд№ҹеҸҜд»Ҙз”ЁжқҘжӣҙж”№гҖҒеўһеҠ иҠӮзӮ№дҝЎжҒҜ

res1:PRIMARY> rs.conf();

{

"_id" : "res1",

"version" : 1,

"members" : [

{

"_id" : 0,

"host" : "192.168.1.248:27017",

"priority" : 2

},

{

"_id" : 1,

"host" : "192.168.1.247:27018",

"priority" : 0

},

{

"_id" : 2,

"host" : "192.168.1.250:27019"

}

]

}

д»ҘдёҠжӯҘйӘӨпјҢе°ұжҳҜreplica setзҡ„дёҖдёӘжҗӯе»әзҡ„иҝҮзЁӢпјҢжҺҘдёӢжқҘе°ұжҳҜж“ҚдҪңе’ҢйӘҢиҜҒ

дә”пјҡдё»д»Һж“ҚдҪңзҡ„oplogж—Ҙеҝ—

Mongodbзҡ„replica setжһ¶жһ„жҳҜйҖҡиҝҮдёҖдёӘж—Ҙеҝ—жқҘеӯҳеӮЁеҶҷж“ҚдҪңзҡ„пјҢиҝҷдёӘж—Ҙеҝ—е°ұжҳҜвҖҳoplogвҖҷгҖӮOplogжҳҜдёҖдёӘеӣәе®ҡй•ҝеәҰзҡ„capped collectionпјҢе®ғеӯҳж”ҫдәҺlocalж•°жҚ®еә“дёӢпјҢз”ЁдәҺи®°еҪ•replica setsзҡ„ж“ҚдҪңи®°еҪ•гҖӮOplogзҡ„ж—Ҙеҝ—еӨ§е°ҸжҳҜеҸҜд»Ҙи°ғж•ҙзҡ„пјҢе°ұеңЁжҲ‘们еҗҜеҠЁзҡ„ж—¶еҖҷдҪҝз”Ё--oplogSize еҸӮж•°жҢҮе®ҡзҡ„пјҢеҚ•дҪҚжҳҜMB

res1:PRIMARY> show dbs;

admin (empty)

local 0.203125GB пјҲжңүoplogзҡ„collectionпјҢжҳҜжңүж•°жҚ®зҡ„пјү

е…ҲеңЁprimaryдёҠеҲӣе»әеә“пјҢsecondaryжҳҜж— жі•иҜ»еҶҷж“ҚдҪңзҡ„пјҲзӯүдёӢеҸҜд»Ҙи§ЈеҶіиҜ»зҡ„й—®йўҳпјү

Use test1

db.appstore.save({'e_name':'frank','e_id':1101,'class_id':1});

db.appstore.find();

{ "_id" : ObjectId("529e7c88d4d317e4bd3eece9"), "e_name" : "frank", "e_id" : 1101, "class_id" : 1 }

д№ӢеҗҺпјҢдҪ дјҡзңӢеҲ°еҸҰеӨ–дёӨеҸ°mongodbзҡ„logж—Ҙеҝ—зҡ„еҸҳеҢ–пјҢжңүиҝҪеҠ пјҡ

Fri Dec 6 15:56:22.338 [FileAllocator] allocating new datafile /data/mon_db/res2/test1.ns, filling with zeroes...

Fri Dec 6 15:56:22.474 [FileAllocator] done allocating datafile /data/mon_db/res2/test1.ns, size: 16MB, took 0.136 secs

Fri Dec 6 15:56:22.474 [FileAllocator] allocating new datafile /data/mon_db/res2/test1.0, filling with zeroes...

Fri Dec 6 15:56:23.850 [FileAllocator] done allocating datafile /data/mon_db/res2/test1.0, size: 64MB, took 1.376 secs

Fri Dec 6 15:56:23.852 [repl writer worker 1] build index test1.appstore { _id: 1 }

Fri Dec 6 15:56:23.852 [FileAllocator] allocating new datafile /data/mon_db/res2/test1.1, filling with zeroes...

Fri Dec 6 15:56:23.853 [repl writer worker 1] build index done. scanned 0 total records. 0 secs

Fri Dec 6 15:56:27.006 [FileAllocator] done allocating datafile /data/mon_db/res2/test1.1, size: 128MB, took 3.153 secs

Fri Dec 6 15:56:27.007 [rsSyncNotifier] repl: old cursor isDead, will initiate a new one

еҰӮжһңжғіеңЁsecondaryдёҠжҹҘзңӢж•°жҚ®пјҢй»ҳи®Өжғ…еҶөдёӢпјҡ

[root@test04 ~]# /usr/local/mongodb/bin/mongo --port 27018

MongoDB shell version: 2.4.8

connecting to: 127.0.0.1:27018/test

res1:SECONDARY> show dbs;show dbs;

admin (empty)

local 0.203125GB

test1 0.203125GB

OkпјҢеҸҜд»ҘзңӢеҲ°жҲ‘们еҲҡеҲӣе»әзҡ„test1еә“пјҢ

res1:SECONDARY> use test1;

switched to db test1

res1:SECONDARY> show collectionsпјӣ

Fri Dec 6 15:59:10.758 error: { "$err" : "not master and slaveOk=false", "code" : 13435 } at src/mongo/shell/query.js:128

OKпјҢжҸҗзӨәerror

и§ЈеҶіеҠһжі•пјҡ

res1:SECONDARY> db.getMongo().setSlaveOk(); пјҲиҮӘеёҰзҡ„еҮҪж•°пјү

res1:SECONDARY> show collections;show collections;

appstore

System.indexes

res1:SECONDARY> db.appstore.find();db.appstore.find();

{ "_id" : ObjectId("529e7c88d4d317e4bd3eece9"), "e_name" : "frank", "e_id" : 1101, "class_id" : 1 }

еҰӮжһңиҜҙдҪ жғіеҶҷж•°жҚ®пјҢе°ұдјҡжҸҗзӨә not master

db.appstore.insert({'e_name':1102,'e_id':1102});

not master

OK.иҝҷж ·е°ұеҸҜд»Ҙе®һзҺ°иҜ»еҶҷзҡ„еҲҶзҰ»

жҖҺж ·жҹҘзңӢoplogзҡ„ж—Ҙеҝ—

use local;

show collections;

oplog.rs

slaves

startup_log

system.indexes

System.replset

е°ұжҳҜжҹҘзңӢoplog.rs collection

res1:PRIMARY> db.oplog.rs.find();

{ "ts" : Timestamp(1386116964, 1), "h" : NumberLong(0), "v" : 2, "op" : "n", "ns" : "", "o" : { "msg" : "initiating set" } }

{ "ts" : Timestamp(1386118280, 1), "h" : NumberLong("8972935208244346897"), "v" : 2, "op" : "i", "ns" : "test1.appstore", "o" : { "_id" : ObjectId("529e7c88d4d317e4bd3eece9"), "e_name" : "frank", "e_id" : 1101, "class_id" : 1 } }

зӣёе…іи§ЈйҮҠпјҡ

Ts иЎЁзӨәжҹҗдёӘж“ҚдҪңзҡ„ж—¶й—ҙжҲі

OpпјҡиЎЁзӨәж“ҚдҪңзұ»еһӢпјҢдёҖиҲ¬еҢ…жӢ¬

I insert жҸ’е…Ҙ

D delete еҲ йҷӨ

Uupdate жӣҙж–°

Ns е‘ҪеҗҚз©әй—ҙпјҢд№ҹе°ұжҳҜдҪ ж“ҚдҪңзҡ„collection nameеҗҚ

O documentпјҲж–ҮжЎЈпјүпјҢе°ұжҳҜдҪ жҸ’е…Ҙзҡ„ж•°жҚ®дҝЎжҒҜ

жҹҘзңӢMsterдёҠзҡ„oplogе…ғж•°жҚ®дҝЎжҒҜпјҡ

res1:PRIMARY> db.printReplicationInfo();

configured oplog size: 100MB

log length start to end: 1316secs (0.37hrs)

oplog first event time: Wed Dec 04 2013 08:29:24 GMT+0800 (CST)

oplog last event time: Wed Dec 04 2013 08:51:20 GMT+0800 (CST)

now: Wed Dec 04 2013 09:14:20 GMT+0800 (CST)

Oplog size жҳҜдҪ oplog зҡ„жҖ»еӨ§е°ҸпјҢжҳҜеҸҜеҫӘзҺҜзҡ„

log length start to end oplogж—Ҙеҝ—зҡ„еҗҜз”Ёж—¶й—ҙж®өпјҢеҚ•дҪҚ з§’

oplog first event time 第дёҖдёӘдәӢеҠЎдә§з”ҹзҡ„ж—¶й—ҙ

oplog last event time жңҖеҗҺдёҖдёӘдәӢеҠЎдә§з”ҹзҡ„ж—¶й—ҙ

NowзҺ°еңЁзҡ„ж—¶й—ҙ

жҹҘзңӢslaveзҡ„ж•°жҚ®еҗҢжӯҘзҠ¶жҖҒ

res1:PRIMARY> db.printSlaveReplicationInfo();

source: 192.168.1.247:27018

syncedTo: Wed Dec 04 2013 08:51:20 GMT+0800 (CST)

= 1620 secs ago (0.45hrs)

source: 192.168.1.250:27019

syncedTo: Wed Dec 04 2013 08:51:20 GMT+0800 (CST)

= 1620 secs ago (0.45hrs)

Sourceпјҡslaveзҡ„IPе’Ңз«ҜеҸЈдҝЎжҒҜ

SyncedToпјҡзӣ®еүҚзҡ„еҗҢжӯҘжғ…еҶөпјҢ延иҝҹдәҶеӨҡд№…зӯүдҝЎжҒҜ

еңЁlocalж•°жҚ®еә“еҶ…пјҢдёҚд»…жңүoplogзҡ„йӣҶеҗҲпјҢиҝҳжңүдёҖдёӘйӣҶеҗҲжҳҜи®°еҪ•set й…ҚзҪ®дҝЎжҒҜ

db.system.replset.find();

жҲ–иҖ…жҳҜ rs.conf() йғҪеҸҜд»ҘжҹҘзңӢеҲ°

д»ҘдёҠжӯҘйӘӨжҳҜreplica setзҡ„жҗӯе»әиҝҮзЁӢе’Ңзӣёе…ізҡ„жҹҘзңӢиҜӯеҸҘпјҢеҰӮжңүдёҚи¶ід№ӢеӨ„пјҢиҝҳиҜ·жҢҮзӮ№

replica set иҠӮзӮ№зҡ„еўһгҖҒеҲ гҖҒж”№е’Ңж•…йҡңеҲҮжҚўеҸӮиҖғпјҡhttp://1413570.blog.51cto.com/1403570/1337622

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ