жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

еңЁVue йЎ№зӣ®дёӯдҪҝз”ЁWebSockeдёҺWaveSurferJS е®һзҺ°дёҖдёӘиҒҠеӨ©еҜ№иҜқеҠҹиғҪпјҹзӣёдҝЎеҫҲеӨҡжІЎжңүз»ҸйӘҢзҡ„дәәеҜ№жӯӨжқҹжүӢж— зӯ–пјҢдёәжӯӨжң¬ж–ҮжҖ»з»“дәҶй—®йўҳеҮәзҺ°зҡ„еҺҹеӣ е’Ңи§ЈеҶіж–№жі•пјҢйҖҡиҝҮиҝҷзҜҮж–Үз« еёҢжңӣдҪ иғҪи§ЈеҶіиҝҷдёӘй—®йўҳгҖӮ

еј•иЁҖ

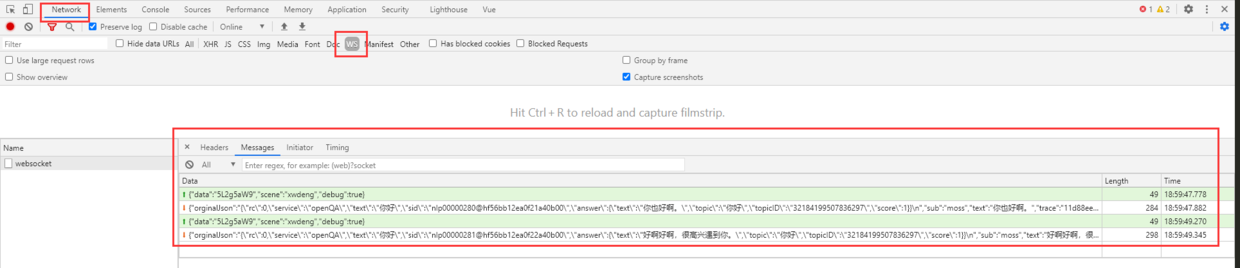

еңЁдёҺе®һзҺ°дәҶиҜӯйҹіеҗҲжҲҗгҖҒиҜӯд№үеҲҶжһҗгҖҒжңәеҷЁзҝ»иҜ‘зӯүз®—жі•зҡ„еҗҺз«ҜдәӨдә’ж—¶пјҢйЎөйқўеҸҜд»Ҙи®ҫи®ЎжҲҗжӣҙдёәдәәжҖ§еҢ–гҖҒдәІеҲҮзҡ„ж–№ејҸгҖӮжҲ‘们йҮҮз”Ёзұ»дјјдәҺиҒҠеӨ©еҜ№иҜқзҡ„е®һзҺ°пјҢж•ҲжһңеҰӮдёӢпјҡ

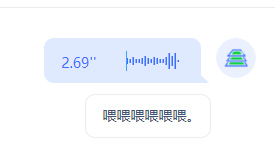

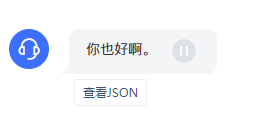

еҰӮдёҠеӣҫжүҖзӨәпјҢиҝ”еӣһж–Үжң¬еҗҺпјҢеҶҚиҝ”еӣһеҗҲжҲҗеҮәзҡ„йҹійў‘гҖӮ

йҹійў‘жҢүй’®еөҢеңЁеҜ№иҜқж°”жіЎдёӯпјҢеҸҜд»ҘзӮ№еҮ»ж’ӯж”ҫгҖӮ

е®һзҺ°еҠҹиғҪеҸҠжҠҖжңҜиҰҒзӮ№

1гҖҒеҹәдәҺWebSocketе®һзҺ°еҜ№иҜқжөҒ

йЎөйқўдёҺеҗҺз«Ҝзҡ„дәӨдә’жҳҜе®һж—¶дә’еҠЁзҡ„пјҢжүҖд»ҘйҮҮз”ЁWebSocketеҚҸи®®пјҢиҖҢдёҚжҳҜHTTPиҜ·жұӮпјҢиҝҷж ·еҗҺз«ҜжҺЁйҖҒеӣһзҡ„ж¶ҲжҒҜеҸҜд»Ҙе®һж—¶жҳҫзӨәеңЁйЎөйқўдёҠгҖӮ

WebSocketзҡ„иҝ”еӣһжҳҜйҳҹеҲ—зҡ„гҖҒж— еәҸзҡ„пјҢеңЁеҗҺз»ӯеӨ„зҗҶдёӯжҲ‘们д№ҹйңҖиҰҒжіЁж„ҸиҝҷдёҖзӮ№пјҢеңЁеҗҺж–ҮдёӯдјҡиҜҙеҲ°гҖӮ

2гҖҒи°ғз”Ёи®ҫеӨҮйәҰе…ӢйЈҺиҝӣиЎҢйҹійў‘еҪ•еҲ¶е’ҢиҪ¬з ҒеҠ еӨҙпјҢеҹәдәҺWebAudioгҖҒWaveSurferJSзӯүе®һзҺ°йҹійў‘еӨ„зҗҶе’Ңз»ҳеҲ¶

3гҖҒеҹәдәҺVueзҡ„е“Қеә”ејҸйЎөйқўе®һзҺ°

4гҖҒCSS3 + Canvas + JS дәӨдә’ж•ҲжһңдјҳеҢ–

дёӢйқўз»ҷеҮәйғЁеҲҶе®һзҺ°д»Јз ҒгҖӮ

йӣҶжҲҗWebSocket

жҲ‘们зҡ„иҒҠеӨ©з»„件жҳҜйЎөйқўдҫ§иҫ№жү“ејҖзҡ„жҠҪеұүпјҲel-drawerпјүпјҢVue组件дјҡеңЁжү“ејҖж—¶еҲӣе»әпјҢе…ій—ӯж—¶й”ҖжҜҒгҖӮеңЁз»„件дёӯеј•е…ҘWebSocketпјҢ并管зҗҶе®ғзҡ„ејҖгҖҒе…ігҖҒж¶ҲжҒҜжҺҘ收е’ҢеҸ‘йҖҒпјҢдҪҝе®ғзҡ„з”ҹе‘Ҫе‘ЁжңҹдёҺ组件дёҖиҮҙпјҲжү“ејҖзӘ—еҸЈж—¶еҲӣе»әwsиҝһжҺҘпјҢе…ій—ӯзӘ—еҸЈж—¶е…ій—ӯиҝһжҺҘпјҢйҒҝе…ҚдёҺеҗҺеҸ°иҝһжҺҘиҝҮеӨҡгҖӮпјү

created(){

if (typeof WebSocket === 'undefined') {

alert('жӮЁзҡ„жөҸи§ҲеҷЁдёҚж”ҜжҢҒsocket')

} else {

// е®һдҫӢеҢ–socket

this.socket = new WebSocket(this.socketServerPath)

// зӣ‘еҗ¬socketиҝһжҺҘ

this.socket.onopen = this.open

// зӣ‘еҗ¬socketй”ҷиҜҜдҝЎжҒҜ

this.socket.onerror = this.error

// зӣ‘еҗ¬socketж¶ҲжҒҜ

this.socket.onmessage = this.onMessage

this.socket.onclose = this.close

}

}

destroyed(){

this.socket.close()

}еҰӮдёҠпјҢе°ҶWebSocketзҡ„дәӢ件绑е®ҡеҲ°JSж–№жі•дёӯпјҢеҸҜд»ҘеңЁеҜ№еә”ж–№жі•дёӯе®һзҺ°еҜ№ж•°жҚ®зҡ„жҺҘ收е’ҢеҸ‘йҖҒгҖӮ

жү“ејҖжөҸи§ҲеҷЁжҺ§еҲ¶еҸ°пјҢйҖүдёӯжҢҮе®ҡзҡ„ж ҮзӯҫпјҢдҫҝдәҺеҜ№WebSocketиҝһжҺҘиҝӣиЎҢзӣ‘жҺ§е’ҢжҹҘзңӢгҖӮ

йҹійў‘еҪ•еҲ¶йҮҮйӣҶ

д»ҺжөҸи§ҲеҷЁз«Ҝйҹійў‘е’Ңи§Ҷйў‘йҮҮйӣҶеҹәдәҺзҪ‘йЎөеҚіж—¶йҖҡдҝЎпјҲWeb Real-Time

CommunicationпјҢз®Җз§°WebRTCпјү зҡ„APIгҖӮйҖҡиҝҮWebRTCзҡ„getUserMediaе®һзҺ°пјҢиҺ·еҸ–дёҖдёӘMediaStreamеҜ№иұЎпјҢе°ҶиҜҘеҜ№иұЎе…іиҒ”еҲ°AudioContextеҚіеҸҜиҺ·еҫ—йҹійў‘гҖӮ

еҸҜеҸӮиҖғRecorderJSзҡ„е®һзҺ°пјҡ https://github.com/mattdiamond/Recorderjs/blob/master/examples/example_simple_exportwav.html

if (navigator.getUserMedia) {

navigator.getUserMedia(

{ audio: true }, // еҸӘеҗҜз”Ёйҹійў‘

function(stream) {

var context = new(window.webkitAudioContext || window.AudioContext)()

var audioInput = context.createMediaStreamSource(stream)

var recorder = new Recorder(audioInput)

},

function(error) {

switch (error.code || error.name) {

case 'PERMISSION_DENIED':

case 'PermissionDeniedError':

throwError('з”ЁжҲ·жӢ’з»қжҸҗдҫӣдҝЎжҒҜгҖӮ')

break

case 'NOT_SUPPORTED_ERROR':

case 'NotSupportedError':

throwError('жөҸи§ҲеҷЁдёҚж”ҜжҢҒ硬件и®ҫеӨҮгҖӮ')

break

case 'MANDATORY_UNSATISFIED_ERROR':

case 'MandatoryUnsatisfiedError':

throwError('ж— жі•еҸ‘зҺ°жҢҮе®ҡзҡ„硬件и®ҫеӨҮгҖӮ')

break

default:

throwError('ж— жі•жү“ејҖйәҰе…ӢйЈҺгҖӮејӮеёёдҝЎжҒҜ:' + (error.code || error.name))

break

}

}

)

} else {

throwError('еҪ“еүҚжөҸи§ҲеҷЁдёҚж”ҜжҢҒеҪ•йҹіеҠҹиғҪгҖӮ')

}жіЁж„Ҹпјҡ иӢҘnavigator.getUserMediaиҺ·еҸ–еҲ°зҡ„жҳҜundefinedпјҢжҳҜChromeжөҸи§ҲеҷЁзҡ„е®үе…Ёзӯ–з•ҘеҜјиҮҙзҡ„пјҢйңҖиҰҒйҖҡиҝҮhttpsиҜ·жұӮжҲ–й…ҚзҪ®жөҸи§ҲеҷЁпјҢй…ҚзҪ®ең°еқҖпјҡ chrome://flags/#unsafely-treat-insecure-origin-as-secure

жөҸи§ҲеҷЁйҮҮйӣҶеҲ°зҡ„йҹійў‘дёәPCMж јејҸ(PCM пјҲи„үеҶІзј–з Ғи°ғеҲ¶ Pulse Code Modulationпјү)пјҢйңҖиҰҒеҜ№йҹійў‘еҠ еӨҙжүҚиғҪеңЁйЎөйқўдёҠиҝӣиЎҢж’ӯж”ҫгҖӮжіЁж„ҸеҠ еӨҙж—¶йҮҮж ·зҺҮгҖҒйҮҮж ·йў‘зҺҮгҖҒеЈ°йҒ“ж•°йҮҸзӯүеҝ…йЎ»дёҺйҮҮж ·ж—¶зӣёеҗҢпјҢдёҚ然еҠ е®ҢеӨҙеҗҺзҡ„йҹійў‘ж— жі•и§Јз ҒгҖӮеҸӮиҖғжҹҘзңӢhttps://github.com/mattdiamond/Recorderjs/blob/master/src/recorder.jsдёӯexportWavж–№жі•гҖӮ

дёҡеҠЎдёӯеҜ№жҺҘзҡ„иҜӯйҹіиҜҶеҲ«еј•ж“Һдёәе®һж—¶иҪ¬еҶҷеј•ж“ҺпјҢеҚіпјҡдёҚжҳҜеҪ•еҲ¶е®ҢжҲҗеҗҺеҶҚеҸ‘йҖҒпјҢиҖҢжҳҜдёҖиҫ№еҪ•еҲ¶дёҖиҫ№иҝӣиЎҢзј–з Ғ并еҸ‘йҖҒгҖӮ

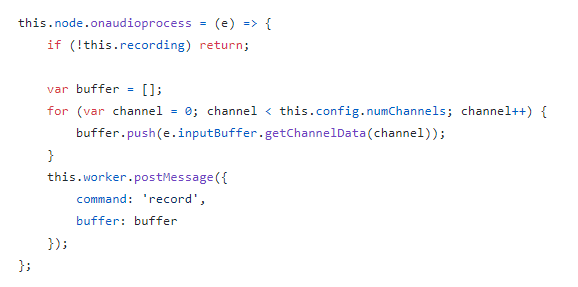

дҪҝз”Ёonaudioprocessж–№жі•зӣ‘еҗ¬иҜӯйҹізҡ„иҫ“е…Ҙпјҡ

еҸӮиҖғиҝҷдёӘе®һзҺ°пјҢжҲ‘们еҸҜд»ҘеңЁжҜҸж¬Ўзӣ‘еҗ¬еҲ°жңүж•°жҚ®еҶҷе…Ҙж—¶пјҢд»ҺbufferдёӯиҺ·еҸ–еҲ°еҪ•еҲ¶еҲ°зҡ„ж•°жҚ®пјҢ并иҝӣиЎҢзј–з ҒгҖҒеҺӢзј©пјҢеҶҚйҖҡиҝҮWebSocketеҸ‘йҖҒгҖӮ

Vue组件и®ҫи®Ўе’ҢдёҡеҠЎе®һзҺ°

еҲҶжһҗйЎөйқўдёҡеҠЎйҖ»иҫ‘пјҢе°Ҷд»Јз ҒжӢҶеҲҶжҲҗдёӨдёӘ组件пјҡ

ChatDialog.vue иҒҠеӨ©еҜ№иҜқжЎҶйЎөйқўпјҢж №жҚ®иҫ“е…Ҙзұ»еһӢпјҢеҲҶдёәж–Үжң¬иҫ“е…ҘгҖҒиҜӯйҹіиҫ“е…ҘгҖӮ

ChatRecord.vueиҒҠеӨ©и®°еҪ•з»„件пјҢж №жҚ®еҸ‘йҖҒж–№пјҲиҮӘе·ұжҲ–иҖ…зі»з»ҹпјүеұ•зӨәеҗ‘е·Ұ/еҗ‘еҸізҡ„ж°”жіЎпјҢж №жҚ®еҶ…е®№жҳҫзӨәж–Үжң¬гҖҒйҹійў‘зӯүгҖӮChatDialogжҳҜChatRecordзҡ„зҲ¶з»„件пјҢйҒҚеҺҶChatDialogдёӯзҡ„chatListеҜ№иұЎпјҲArrayпјүпјҢе°ҶchatListдёӯзҡ„йЎ№жіЁе…ҘеҲ°ChatRecordдёӯгҖӮ

<div class="chat-list">

<div v-for="(item,index) in chatList" :key="index" class="msg-wrapper">

<chat-record ref="chatRecord" :data="item" @showJson="showJsonDialog"></chat-record>

</div>

<div id="msg_end" ></div>

</div>

</div>еҜ№дәҺиҒҠеӨ©и®°еҪ•зҡ„ж°”жіЎеұ•зӨәпјҢдёҺж•°жҚ®зұ»еһӢзӣёе…іжҖ§еҫҲејәпјҢChatRecord组件еҸӘе…іеҝғеҜ№ж•°жҚ®зҡ„еӨ„зҗҶе’Ңеұ•зӨәпјҢжҲ‘们еҸҜд»Ҙе®Ңе…ЁдёҚз”Ёе…іеҝғж¶ҲжҒҜзҡ„еҸ‘йҖҒгҖҒжҺҘ收гҖҒйҹійў‘зҡ„еҪ•еҲ¶гҖҒеҒңжӯўеҪ•еҲ¶гҖҒжҺҘеҸ—йҹійў‘зӯүйҖ»иҫ‘пјҢеҸӘйңҖиҰҒж №жҚ®ж•°жҚ®жқҘеұ•зӨәдёҚеҗҢзҡ„ж ·ејҸеҚіеҸҜгҖӮ

иҝҷж ·Vueзҡ„е“Қеә”ејҸе°ұе……еҲҶиҺ·еҫ—дәҶз”ЁжӯҰд№Ӣең°пјҡж— йңҖз”Ёд»Јз ҒеҜ№ж ·ејҸеұ•зӨәиҝӣиЎҢжҺ§еҲ¶пјҢеҸӘйңҖиҰҒи®ҫи®ЎеҗҲзҗҶзҡ„ж•°жҚ®ж јејҸе’Ңж ·ејҸжЁЎжқҝпјҢ然еҗҺжіЁе…ҘдёҚеҗҢзҡ„ж•°жҚ®еҚіеҸҜгҖӮ

жЁЎжқҝйЎөйқўпјҡ дҪҝз”Ёv-ifжҺ§еҲ¶пјҢдҝ®ж”№chatListйҮҢзҡ„еҜ№иұЎеҶ…е®№еҚіеҸҜж”№еҸҳйЎөйқўеұ•зӨәгҖӮ

ж №жҚ®дёҡеҠЎйңҖжұӮпјҢе°ҶChatRecordеҸҜиғҪжҺҘ收еҲ°зҡ„ж•°жҚ®еҲҶдёәд»ҘдёӢеҮ зұ»пјҡ

еҸ‘йҖҒж–№дёәиҮӘе·ұпјҡ

е®һзҺ°з®ҖеҚ•пјҢдёҚеҒҡиөҳиҝ°гҖӮ

иҜҘеҠЁз”»дҪҝз”ЁCSSе®һзҺ°пјҢеҸӮиҖғең°еқҖпјҡ https://www.cnblogs.com/lhb25/p/loading-spinners-animated-with-css3.html

и®Ўж—¶еҷЁдҪҝз”ЁJSзҡ„setIntervalж–№жі•пјҢжҜҸ100msжӣҙж–°дёҖж¬ЎеҪ•еҲ¶ж—¶й•ҝ

this.recordTimer = setInterval(() => {

this.audioDuration = this.audioDuration + 0.1

}, 100)еҒңжӯўеҗҺжё…з©әи®Ўж—¶еҷЁпјҡ

ж•Ҳжһңпјҡ

дҪҝз”ЁwavesurferжҸ’件:

initWaveSurfer() {

this.$nextTick(() => {

this.wavesurfer = WaveSurfer.create({

container: this.$refs.waveform,

height: 20,

waveColor: '#3d6fff',

progressColor: 'blue',

backend: 'MediaElement',

mediaControls: false,

audioRate: '1',

fillParent: false,

maxCanvasWidth: 500,

barWidth: 1,

barGap: 2,

barHeight: 5,

barMinHeight: 3,

normalize: true,

cursorColor: '#409EFF'

})

this.convertAudioToUrl(this.waveAudio).then((res) => {

this.wavesurfer.load(res)

setTimeout(() => {

this.audioDuration = this.getAudioDuration()

}, 100)

})

})

},

// е°Ҷйҹійў‘иҪ¬еҢ–жҲҗurlең°еқҖ

convertAudioToUrl(audio) {

let blobUrl = ''

if (this.data.sendBy === 'self') {

blobUrl = window.URL.createObjectURL(audio)

return new Promise((resolve) => {

resolve(blobUrl)

})

} else {

return this.base64ToBlob({

b64data: audio,

contentType: 'audio/wav'

})

}

},

base64ToBlob({ b64data = '', contentType = '', sliceSize = 512 } = {}) {

return new Promise((resolve, reject) => {

// дҪҝз”Ё atob() ж–№жі•е°Ҷж•°жҚ®и§Јз Ғ

let byteCharacters = atob(b64data)

let byteArrays = []

for (

let offset = 0;

offset < byteCharacters.length;

offset += sliceSize

) {

let slice = byteCharacters.slice(offset, offset + sliceSize)

let byteNumbers = []

for (let i = 0; i < slice.length; i++) {

byteNumbers.push(slice.charCodeAt(i))

}

// 8 дҪҚж— з¬ҰеҸ·ж•ҙж•°еҖјзҡ„зұ»еһӢеҢ–ж•°з»„гҖӮеҶ…е®№е°ҶеҲқе§ӢеҢ–дёә 0гҖӮ

// еҰӮжһңж— жі•еҲҶй…ҚиҜ·жұӮж•°зӣ®зҡ„еӯ—иҠӮпјҢеҲҷе°Ҷеј•еҸ‘ејӮеёёгҖӮ

byteArrays.push(new Uint8Array(byteNumbers))

}

let result = new Blob(byteArrays, {

type: contentType

})

result = Object.assign(result, {

// иҝҷйҮҢдёҖе®ҡиҰҒеӨ„зҗҶдёҖдёӢ URL.createObjectURL

preview: URL.createObjectURL(result),

name: `XXX.wav`

})

resolve(window.URL.createObjectURL(result))

})

},еҸ‘йҖҒж–№дёәзі»з»ҹпјҡ

йЎөйқўеөҢе…Ҙaudioж ҮзӯҫпјҢе°Ҷhiddenи®ҫзҪ®дёәtrueдҪҝе…¶дёҚжҳҫзӨәпјҡ

<div class="audio-player"> <svg-icon v-if="!isPlaying" icon-class='play' @click="onClickAudioPlayer" /> <svg-icon v-else icon-class='pause' @click="onClickAudioPlayer" /> <audio :src="playAudioUrl" autostart="true" hidden="true" ref="audioPlayer" /> </div>

playAudioUrlзҡ„з”ҹжҲҗеҸӮиҖғдёҠйқўз”ҹжҲҗзҡ„wavesurferзҡ„urlгҖӮ

дҪҝз”ЁisPlayingеҸӮж•°и®°еҪ•еҪ“еүҚйҹійў‘зҡ„ж’ӯж”ҫзҠ¶жҖҒпјҢ并дҪҝз”ЁsetTimeoutж–№жі•пјҢеҪ“ж’ӯж”ҫдәҶйҹійў‘ж—¶й•ҝеҗҺпјҢе°Ҷж’ӯж”ҫжҢүй’®иҮӘеҠЁзҪ®дёәplayгҖӮ

onClickAudioPlayer() {

if (this.isPlaying) {

this.$refs.audioPlayer.pause()

this.isPlaying = false

} else {

// жҜҸж¬ЎзӮ№еҮ»ж—¶пјҢејҖе§Ӣж’ӯж”ҫпјҢ并еңЁж’ӯж”ҫе®ҢжҜ•е°ҶisPlayingзҪ®дёәfalse

this.$refs.audioPlayer.currentTime = 0

this.$refs.audioPlayer.play()

this.isPlaying = true

setTimeout(() => {

// е°ҶжӯЈеңЁж’ӯж”ҫйҮҚзҪ®дёәfalse

this.isPlaying = false

}, Math.ceil(this.$refs.audioPlayer.duration) * 1000)

}

},иҒҠеӨ©и®°еҪ•иҮӘеҠЁе®ҡдҪҚеҲ°жңҖеҗҺдёҖжқЎпјҡ

scrollIntoView()ж–№жі•и®°еҪ•жҜҸж¬ЎдјҡиҜқеҜ№еә”зҡ„и®°еҪ•IDпјҲrecordIdпјүпјҡ

websocketиҝ”еӣһзҡ„е…іиҒ”е…ізі»гҖӮзңӢе®ҢдёҠиҝ°еҶ…е®№пјҢдҪ 们жҺҢжҸЎеңЁVue йЎ№зӣ®дёӯдҪҝз”ЁWebSockeдёҺWaveSurferJS е®һзҺ°дёҖдёӘиҒҠеӨ©еҜ№иҜқеҠҹиғҪзҡ„ж–№жі•дәҶеҗ—пјҹеҰӮжһңиҝҳжғіеӯҰеҲ°жӣҙеӨҡжҠҖиғҪжҲ–жғідәҶи§ЈжӣҙеӨҡзӣёе…іеҶ…е®№пјҢж¬ўиҝҺе…іжіЁдәҝйҖҹдә‘иЎҢдёҡиө„и®Ҝйў‘йҒ“пјҢж„ҹи°ўеҗ„дҪҚзҡ„йҳ…иҜ»пјҒ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ