您好,登录后才能下订单哦!

这篇文章将为大家详细讲解有关怎么在python爬虫中利用url管理器实现一个去重功能,文章内容质量较高,因此小编分享给大家做个参考,希望大家阅读完这篇文章后对相关知识有一定的了解。

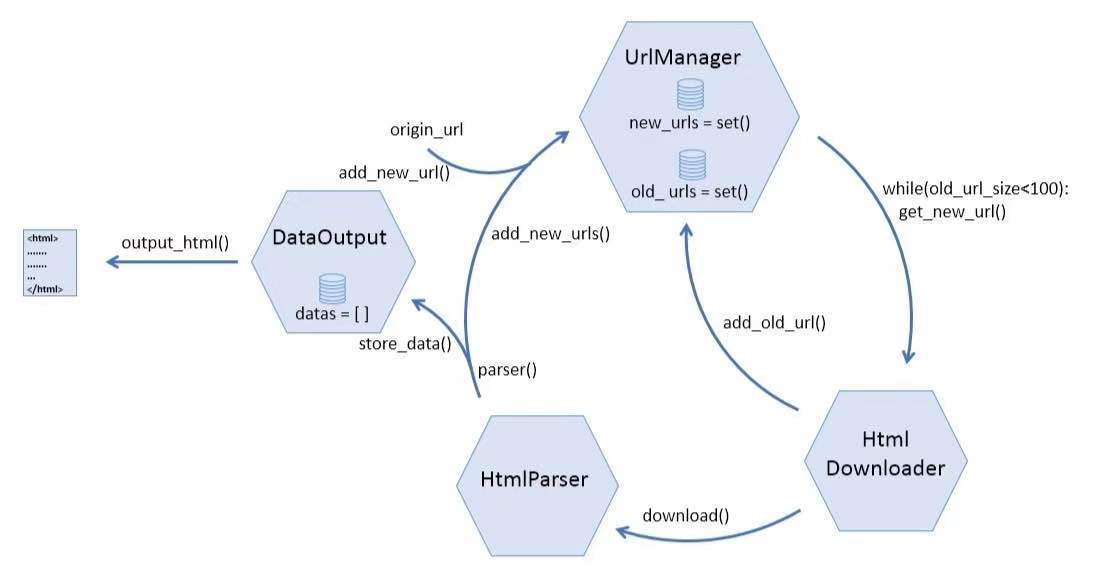

URL管理器到底应该具有哪些功能?

URL下载器应该包含两个仓库,分别存放没有爬取过的链接和已经爬取过的链接。

应该有一些函数负责往上述两个仓库里添加链接

应该有一个函数负责从新url仓库中随机取出一条链接以便下载器爬取

URL下载器应该能识别重复的链接,已经爬取过的链接就不需要放进仓库了

如果一个URL管理器能够具有以上4点功能,也算是“麻雀虽小,五脏俱全”了。然而,链接去重这个功能,应该怎么实现?

链接去重是关系爬虫效率的一个比较关键的点,尤其是爬取的数据量极大的时候。在这个简单的例子里,由于数据量较少,我们不需要太过复杂的算法,直接借助于python的set()函数即可,该函数可以生成一个集合对象,其元素不可重复。

根据以上分析,URL管理器的w代码如下:

''' UrlManager class UrlManager(object): def __init__(self): #初始化的时候就生成两个url仓库 self.new_urls = set() self.old_urls = set() #判断新url仓库中是否还有没有爬取的url def has_new_url(self): return len(self.new_urls) #从new_url仓库获取一个新的url def get_new_url(self): return self.new_urls.pop() def add_new_url(self, url): #这个函数后来用不到了…… ''' 将一条url添加到new_urls仓库中 parm url: str return: if url is None: return #只需要判断old_urls中没有该链接即可,new_urls在添加的时候会自动去重 if url not in self.old_urls: self.new_urls.add(url) def add_new_urls(self, urls): 将多条url添加到new_urls仓库中 parm url: 可迭代对象 print "start add_new_urls" if urls is None or len(urls) == 0: for url in urls: self.add_new_url(url) def add_old_url(self, url): self.old_urls.add(url) print "add old url succefully" #获取已经爬取过的url的数目 def old_url_size(self): return len(self.old_urls)

关于怎么在python爬虫中利用url管理器实现一个去重功能就分享到这里了,希望以上内容可以对大家有一定的帮助,可以学到更多知识。如果觉得文章不错,可以把它分享出去让更多的人看到。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。