жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

дёҖгҖҒз®Җд»Ӣ

1.1 жҸҸиҝ°

ActiveMQдёҚд»…ж”ҜжҢҒpersistentе’Ңnon-persistentдёӨз§Қж–№ејҸпјҢиҝҳж”ҜжҢҒж¶ҲжҒҜзҡ„жҒўеӨҚпјҲrecoveryпјүж–№ејҸгҖҒйҮҚж–°жҠ•йҖ’зӯү

1.2 PTPдёҺPUB/SUB

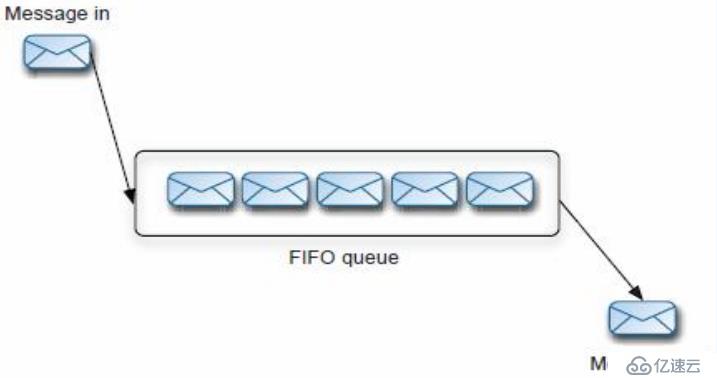

1.2.1 PTP

еҜ№дәҺжҢҒд№…еҢ–и®ўйҳ…дё»йўҳпјҢжҜҸдёҖдёӘж¶Ҳиҙ№иҖ…е°ҶиҺ·еҫ—дёҖдёӘж¶ҲжҒҜзҡ„еӨҚеҲ¶гҖӮ

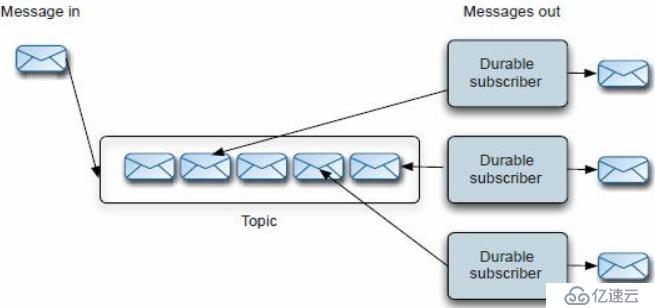

1.2.2 PUB/SUB

еҜ№дәҺжҢҒд№…еҢ–и®ўйҳ…дё»йўҳпјҢжҜҸдёҖдёӘж¶Ҳиҙ№иҖ…е°ҶиҺ·еҫ—дёҖдёӘж¶ҲжҒҜзҡ„еӨҚеҲ¶гҖӮ

1.3 жңүж•Ҳзҡ„ж¶ҲжҒҜеӯҳеӮЁ

ActiveMQжҸҗдҫӣдәҶдёҖдёӘжҸ’件ејҸзҡ„ж¶ҲжҒҜеӯҳеӮЁпјҢзұ»дјјдәҺж¶ҲжҒҜзҡ„еӨҡзӮ№дј ж’ӯпјҢдё»иҰҒе®һзҺ°дәҶеҰӮдёӢеҮ з§Қпјҡ

1пјҡAMQж¶ҲжҒҜеӯҳеӮЁ-еҹәдәҺж–Ү件зҡ„еӯҳеӮЁж–№ејҸпјҢжҳҜд»ҘеүҚзҡ„й»ҳи®Өж¶ҲжҒҜеӯҳеӮЁ

2пјҡKahaDBж¶ҲжҒҜеӯҳеӮЁ-жҸҗдҫӣдәҶе®№йҮҸзҡ„жҸҗеҚҮе’ҢжҒўеӨҚиғҪеҠӣпјҢжҳҜзҺ°еңЁзҡ„й»ҳи®ӨеӯҳеӮЁж–№ејҸ

3пјҡJDBCж¶ҲжҒҜеӯҳеӮЁ-ж¶ҲжҒҜеҹәдәҺJDBCеӯҳеӮЁзҡ„

4пјҡMemory ж¶ҲжҒҜеӯҳеӮЁ-еҹәдәҺеҶ…еӯҳзҡ„ж¶ҲжҒҜеӯҳеӮЁ

дәҢгҖҒжҢҒд№…еҢ–

2.1 KahaDBж¶ҲжҒҜеӯҳеӮЁ

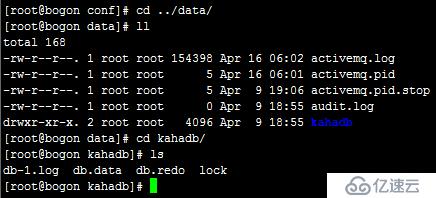

1гҖҒKahaDBжҳҜзӣ®еүҚй»ҳи®Өзҡ„еӯҳеӮЁж–№ејҸпјҢеҸҜз”ЁдәҺд»»дҪ•еңәжҷҜпјҢжҸҗй«ҳдәҶжҖ§иғҪе’ҢжҒўеӨҚиғҪеҠӣгҖӮж¶ҲжҒҜеӯҳеӮЁдҪҝз”ЁдёҖдёӘдәӢеҠЎж—Ҙеҝ—е’Ңд»…д»…з”ЁдёҖдёӘзҙўеј•ж–Ү件жқҘеӯҳеӮЁе®ғжүҖжңүзҡ„ең°еқҖгҖӮ

еңЁпјҡactivemq/conf/activemq.xmlдёӯеҸҜд»ҘжҹҘзңӢ

2гҖҒKahaDBжҳҜдёҖдёӘдё“й—Ёй’ҲеҜ№ж¶ҲжҒҜжҢҒд№…еҢ–зҡ„и§ЈеҶіж–№жЎҲпјҢе®ғеҜ№е…ёеһӢзҡ„ж¶ҲжҒҜдҪҝз”ЁжЁЎејҸиҝӣиЎҢдәҶдјҳеҢ–гҖӮеңЁKahaдёӯпјҢж•°жҚ®иў«иҝҪеҠ еҲ°data logsдёӯгҖӮеҪ“дёҚеҶҚйңҖиҰҒlogж–Ү

件дёӯзҡ„ж•°жҚ®зҡ„ж—¶еҖҷпјҢlogж–Ү件дјҡиў«дёўејғгҖӮ

3гҖҒKahaDBеҹәжң¬й…ҚзҪ®дҫӢеӯҗпјҡ

<persistenceAdapter>

<kahaDB directory="${activemq.data}/kahadb"/>

</persistenceAdapter>

еҸҜз”Ёзҡ„еұһжҖ§жңүпјҡ

1пјҡdirectorпјҡKahaDBеӯҳж”ҫзҡ„и·Ҝеҫ„пјҢй»ҳи®ӨеҖјactivemq-data

2пјҡindexWriteBatchSizeпјҡ жү№йҮҸеҶҷе…ҘзЈҒзӣҳзҡ„зҙўеј•pageж•°йҮҸпјҢй»ҳи®ӨеҖј1000

3пјҡindexCacheSizeпјҡеҶ…еӯҳдёӯзј“еӯҳзҙўеј•pageзҡ„ж•°йҮҸпјҢй»ҳи®ӨеҖј10000

4пјҡenableIndexWriteAsyncпјҡжҳҜеҗҰејӮжӯҘеҶҷеҮәзҙўеј•пјҢй»ҳи®Өfalse

5пјҡjournalMaxFileLengthпјҡи®ҫзҪ®жҜҸдёӘж¶ҲжҒҜdata logзҡ„еӨ§е°ҸпјҢй»ҳи®ӨжҳҜ32MB

6пјҡenableJournalDiskSyncsпјҡи®ҫзҪ®жҳҜеҗҰдҝқиҜҒжҜҸдёӘжІЎжңүдәӢеҠЎзҡ„еҶ…е®№пјҢиў«еҗҢжӯҘеҶҷе…ҘзЈҒзӣҳпјҢJMSжҢҒд№…еҢ–зҡ„ж—¶еҖҷйңҖиҰҒпјҢй»ҳи®Өдёәtrue

7пјҡcleanupIntervalпјҡеңЁжЈҖжҹҘеҲ°дёҚеҶҚдҪҝз”Ёзҡ„ж¶ҲжҒҜеҗҺпјҢеңЁе…·дҪ“еҲ йҷӨж¶ҲжҒҜеүҚзҡ„ж—¶й—ҙпјҢй»ҳи®Ө30000

8пјҡcheckpointIntervalпјҡcheckpointзҡ„й—ҙйҡ”ж—¶й—ҙпјҢй»ҳи®Ө5000

9пјҡignoreMissingJournalfilesпјҡжҳҜеҗҰеҝҪз•ҘдёўеӨұзҡ„ж¶ҲжҒҜж—Ҙеҝ—ж–Ү件пјҢй»ҳи®Өfalse

10пјҡcheckForCorruptJournalFilesпјҡеңЁеҗҜеҠЁзҡ„ж—¶еҖҷпјҢе°ҶдјҡйӘҢиҜҒж¶ҲжҒҜж–Ү件жҳҜеҗҰжҚҹеқҸпјҢй»ҳи®Өfalse

11пјҡchecksumJournalFilesпјҡжҳҜеҗҰдёәжҜҸдёӘж¶ҲжҒҜж—Ҙеҝ—ж–Ү件жҸҗдҫӣchecksumпјҢй»ҳи®Өfalse

12пјҡarchiveDataLogsпјҡ жҳҜеҗҰ移еҠЁж–Ү件еҲ°зү№е®ҡзҡ„и·Ҝеҫ„пјҢиҖҢдёҚжҳҜеҲ йҷӨе®ғ们пјҢй»ҳи®Өfalse

13пјҡdirectoryArchiveпјҡе®ҡд№үж¶ҲжҒҜе·Із»Ҹиў«ж¶Ҳиҙ№иҝҮеҗҺпјҢ移еҠЁdata logеҲ°зҡ„и·Ҝеҫ„пјҢй»ҳи®Өnull

14пјҡdatabaseLockedWaitDelayпјҡиҺ·еҫ—ж•°жҚ®еә“й”Ғзҡ„зӯүеҫ…ж—¶й—ҙ (used by shared master/slave)пјҢй»ҳи®Ө10000

15пјҡmaxAsyncJobsпјҡи®ҫзҪ®жңҖеӨ§зҡ„еҸҜд»ҘеӯҳеӮЁзҡ„ејӮжӯҘж¶ҲжҒҜйҳҹеҲ—пјҢй»ҳи®ӨеҖј10000пјҢеҸҜд»Ҙе’ҢconcurrentMessageProducers и®ҫзҪ®жҲҗдёҖж ·зҡ„еҖј

16пјҡconcurrentStoreAndDispatchTransactionsпјҡжҳҜеҗҰеҲҶеҸ‘ж¶ҲжҒҜеҲ°е®ўжҲ·з«ҜпјҢеҗҢж—¶дәӢеҠЎеӯҳеӮЁж¶ҲжҒҜпјҢй»ҳи®Өtrue

17пјҡconcurrentStoreAndDispatchTopicsпјҡжҳҜеҗҰеҲҶеҸ‘Topicж¶ҲжҒҜеҲ°е®ўжҲ·з«ҜпјҢеҗҢж—¶иҝӣиЎҢеӯҳеӮЁпјҢй»ҳи®Өtrue

18пјҡconcurrentStoreAndDispatchQueuesпјҡжҳҜеҗҰеҲҶеҸ‘queueж¶ҲжҒҜеҲ°е®ўжҲ·з«ҜпјҢеҗҢж—¶иҝӣиЎҢеӯҳеӮЁпјҢй»ҳи®Өtrue

2.2 AMQж¶ҲжҒҜеӯҳеӮЁ

1гҖҒAMQ Message StoreжҳҜActiveMQ5.0зјәзңҒзҡ„жҢҒд№…еҢ–еӯҳеӮЁпјҢе®ғжҳҜдёҖдёӘеҹәдәҺж–Ү件гҖҒдәӢеҠЎеӯҳеӮЁи®ҫи®Ўдёәеҝ«йҖҹж¶ҲжҒҜеӯҳеӮЁзҡ„дёҖдёӘз»“жһ„пјҢиҜҘз»“жһ„жҳҜд»ҘжөҒзҡ„еҪўејҸжқҘ

иҝӣиЎҢж¶ҲжҒҜдәӨдә’зҡ„гҖӮ

2гҖҒиҝҷз§Қж–№ејҸдёӯпјҢMessagesиў«дҝқеӯҳеҲ°data logsдёӯпјҢеҗҢж—¶иў«reference storeиҝӣиЎҢзҙўеј•д»ҘжҸҗй«ҳеӯҳеҸ–йҖҹеәҰгҖӮDate logsз”ұдёҖдәӣеҚ•зӢ¬зҡ„data logж–Ү件组жҲҗпјҢзјәзңҒзҡ„

ж–Ү件еӨ§е°ҸжҳҜ32MпјҢеҰӮжһңжҹҗдёӘж¶ҲжҒҜзҡ„еӨ§е°Ҹи¶…иҝҮдәҶdata logж–Ү件зҡ„еӨ§е°ҸпјҢйӮЈд№ҲеҸҜд»Ҙдҝ®ж”№й…ҚзҪ®д»ҘеўһеҠ data logж–Ү件зҡ„еӨ§е°ҸгҖӮеҰӮжһңжҹҗдёӘdata logж–Ү件дёӯжүҖжңүзҡ„ж¶Ҳ

жҒҜйғҪиў«жҲҗеҠҹж¶Ҳиҙ№дәҶпјҢйӮЈд№ҲиҝҷдёӘdata logж–Ү件е°Ҷдјҡиў«ж Үи®°пјҢд»ҘдҫҝеңЁдёӢдёҖиҪ®зҡ„жё…зҗҶдёӯиў«еҲ йҷӨжҲ–иҖ…еҪ’жЎЈгҖӮ

3гҖҒй…ҚзҪ®зӨәдҫӢ

<broker brokerName="broker" persistent="true" useShutdownHook="false">

<persistenceAdapter>

<amqPersistenceAdapter directory="${activemq.base}/data" maxFileLength="32mb"/>

</persistenceAdapter>

</broker>2.3 JDBCж¶ҲжҒҜеӯҳеӮЁ

ActiveMQж”ҜжҢҒдҪҝз”ЁJDBCжқҘжҢҒд№…еҢ–ж¶ҲжҒҜ

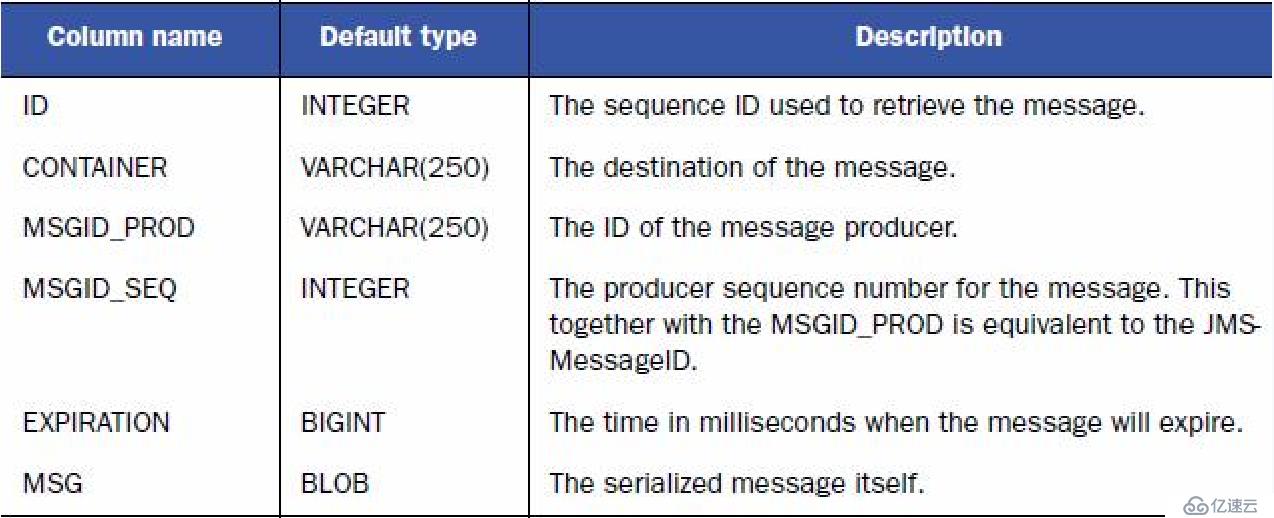

2.3.1 йў„е®ҡд№үзҡ„иЎЁ

1пјҡж¶ҲжҒҜиЎЁпјҢзјәзңҒиЎЁеҗҚдёәACTIVEMQ_MSGSпјҢqueueе’ҢtopicйғҪеӯҳеңЁйҮҢйқўпјҢз»“жһ„еҰӮдёӢпјҡ

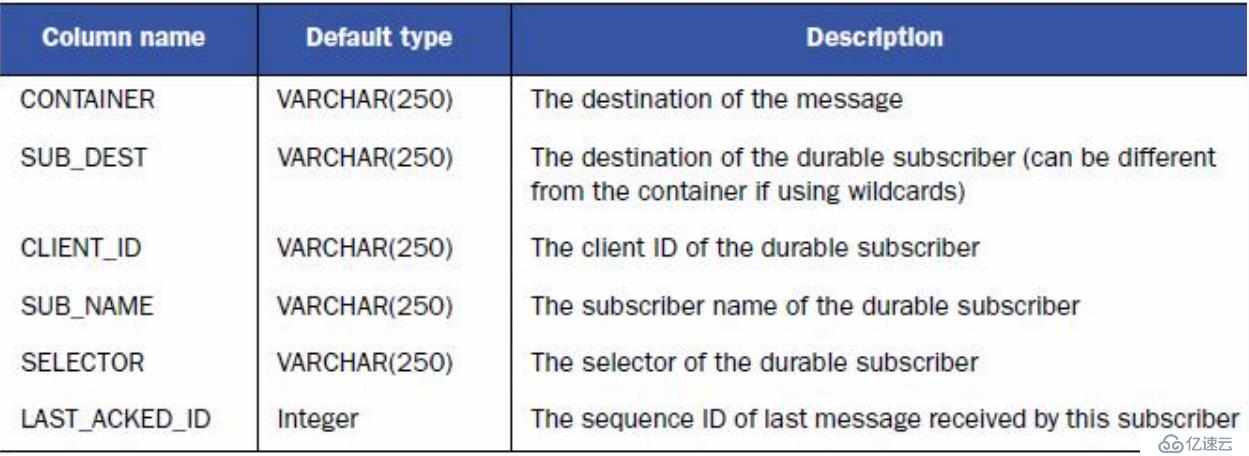

2пјҡACTIVEMQ_ACKSиЎЁеӯҳеӮЁжҢҒд№…и®ўйҳ…зҡ„дҝЎжҒҜе’ҢжңҖеҗҺдёҖдёӘжҢҒд№…и®ўйҳ…жҺҘ收зҡ„ж¶ҲжҒҜIDпјҢз»“жһ„еҰӮдёӢпјҡ

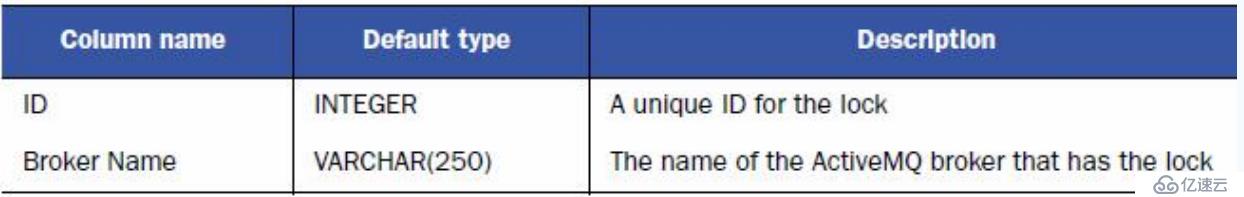

3пјҡй”Ғе®ҡиЎЁпјҢзјәзңҒиЎЁеҗҚдёәACTIVEMQ_LOCKпјҢз”ЁжқҘзЎ®дҝқеңЁжҹҗдёҖж—¶еҲ»пјҢеҸӘиғҪжңүдёҖдёӘActiveMQ brokerе®һдҫӢжқҘи®ҝй—®ж•°жҚ®еә“ пјҢз»“жһ„еҰӮдёӢпјҡ

2.3.2 й…ҚзҪ®activemq/conf/activemq.xml

<persistenceAdapter>

<!--

<kahaDB directory="${activemq.data}/kahadb"/>

-->

<jdbcPersistenceAdapter dataSource="#mysql-ds"/>

</persistenceAdapter>

...

...

</broker>

<bean name="mysql-ds" class="com.alibaba.druid.pool.DruidDataSource" destroy-method="close">

<property name="driverClassName" value="com.mysql.jdbc.Driver" />

<property name="url" value="jdbc:mysql://192.168.91.4:3306/db_activemq?useUnicode=true&characterEncoding=UTF-8" />

<property name="username" value="root" />

<property name="password" value="123456"/>

</bean>жіЁж„ҸпјҡжӯӨеӨ„йңҖиҰҒдёҠдј ж•°жҚ®еә“й©ұеҠЁеҢ…еҲ°/opt/activemq/libдёӢпјҢжҲ‘иҝҷйҮҢиҝһжҺҘжұ з”Ёзҡ„жҳҜйҳҝйҮҢзҡ„пјҢжүҖд»ҘиҝҳиҰҒдёҠдј druidеҢ…

йҮҚеҗҜactivemq

жөӢиҜ•еҸ‘йҖҒ3жқЎйҳҹеҲ—ж¶ҲжҒҜпјҡ

иЎҘе……пјҡJDBC Message Store with ActiveMQ Journal

иҝҷз§Қж–№ејҸе…ӢжңҚдәҶJDBC Storeзҡ„дёҚи¶іпјҢдҪҝз”Ёеҝ«йҖҹзҡ„зј“еӯҳеҶҷе…ҘжҠҖжңҜпјҢеӨ§еӨ§жҸҗй«ҳдәҶжҖ§иғҪгҖӮ й…ҚзҪ®е°ҶpersistenceAdapterжіЁйҮҠжҺүпјҢеҶҚдёҠpersistenceFactoryпјҢзӨәдҫӢеҰӮдёӢпјҡ

<!-- <persistenceAdapter> <jdbcPersistenceAdapter dataSource="#mysql-ds"/> </persistenceAdapter> --> <persistenceFactory> <journalPersistenceAdapterFactory journalLogFiles="4" journalLogFileSize="32768" useJournal="true" useQuickJournal="true" dataSource="#mysql-ds" dataDirectory="activemq-data" /> </persistenceFactory>

JDBC Storeе’ҢJDBC Message Store with ActiveMQ Journalзҡ„еҢәеҲ«пјҡ

1пјҡJdbc with journalзҡ„жҖ§иғҪдјҳдәҺjdbc

2пјҡJdbcз”ЁдәҺmaster/slaveжЁЎејҸзҡ„ж•°жҚ®еә“еҲҶдә«

3пјҡJdbc with journalдёҚиғҪз”ЁдәҺmaster/slaveжЁЎејҸ

4пјҡдёҖиҲ¬жғ…еҶөдёӢпјҢжҺЁиҚҗдҪҝз”Ёjdbc with journal

2.4 Memoryж¶ҲжҒҜеӯҳеӮЁ

еҶ…еӯҳж¶ҲжҒҜеӯҳеӮЁдё»иҰҒжҳҜеӯҳеӮЁжүҖжңүзҡ„жҢҒд№…еҢ–зҡ„ж¶ҲжҒҜеңЁеҶ…еӯҳдёӯгҖӮиҝҷйҮҢжІЎжңүеҠЁжҖҒзҡ„зј“еӯҳеӯҳеңЁпјҢжүҖд»ҘдҪ еҝ…йЎ»жіЁж„Ҹи®ҫзҪ®дҪ зҡ„brokerжүҖеңЁзҡ„JVMе’ҢеҶ…еӯҳйҷҗеҲ¶гҖӮ

й…ҚзҪ®зӨәдҫӢпјҡ

<broker ... persistent="false" ...></broker>

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ