您好,登录后才能下订单哦!

这篇文章将为大家详细讲解有关如何用Python采集腾讯招聘数据,文章内容质量较高,因此小编分享给大家做个参考,希望大家阅读完这篇文章后对相关知识有一定的了解。

今天我们爬取腾讯招聘网站Python岗位的招聘信息。如图所示:

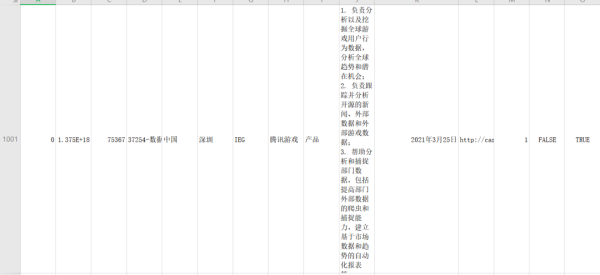

然后还是先看一下最终的结果,我们保存到csv文件中。

爬取1000条数据,第一行是title:

老规矩,我们还是走流程。

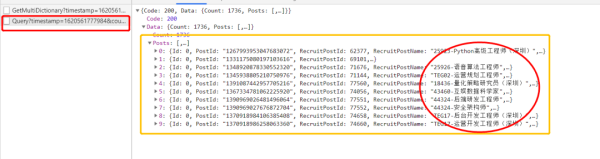

抓取腾讯招聘网站Python相关岗位数据,打开目标网站,F12打开开发者工具,发现岗位信息不在网页源码中,很明显是在XHR中的json数据。

正好对应页面十条数据,接下来就好办了。

找到url的页面规律,

第一页url:https://careers.tencent.com/tencentcareer/api/post/Query?timestamp=1620561777984&countryId=&cityId=&bgIds=&productId=&categoryId=&parentCategoryId=&attrId=&keyword=python&pageIndex=1&pageSize=10&language=zh-cn&area=cn

index参数对应值即为页码,所以循环得到url链。

def getPage(self): url_list = [] for i in range(100): url = self.url.format(i + 1) url_list.append(url) return url_list

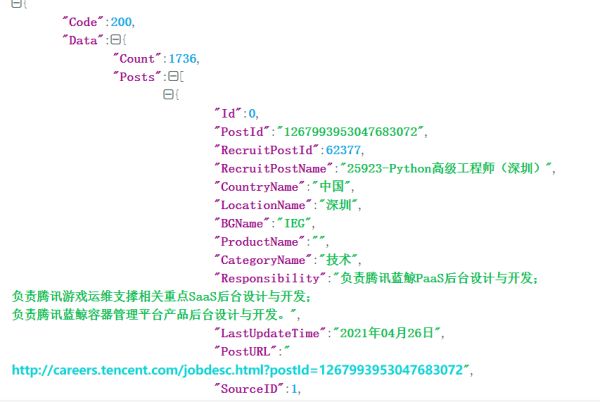

得到url链之后我们循环遍历发起请求,得到json数据,将json数据转换成字典,并解析数据。

for url in urlList: resp = requests.get(url, headers=self.headers) data = resp.content.decode('utf-8') dic_data = json.loads(data) dic_data_list = dic_data["Data"]["Posts"] for i in dic_data_list: work_list.append(i)这样就得到了岗位信息数据。

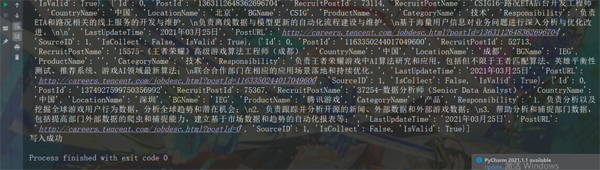

得到了岗位数据之后我们需要把它保存到本地,这里我们把数据保存到本地csv文件中。

try: with open('Tx_work.csv', 'w', encoding='utf-8', newline='') as f: writer = csv.DictWriter(f, self.title) writer.writeheader() writer.writerows(dic) print('写入成功') except Exception as e: print(e)if __name__ == '__main__': tx = Tx(base_url,hd,titles) tx.run()

关于如何用Python采集腾讯招聘数据就分享到这里了,希望以上内容可以对大家有一定的帮助,可以学到更多知识。如果觉得文章不错,可以把它分享出去让更多的人看到。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。