жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

# HDFSдјҳзјәзӮ№жңүе“Әдәӣ

## зӣ®еҪ•

1. [HDFSжҰӮиҝ°](#hdfsжҰӮиҝ°)

2. [HDFSж ёеҝғи®ҫи®ЎеҺҹзҗҶ](#hdfsж ёеҝғи®ҫи®ЎеҺҹзҗҶ)

3. [HDFSзҡ„дјҳеҠҝеҲҶжһҗ](#hdfsзҡ„дјҳеҠҝеҲҶжһҗ)

- [й«ҳе®№й”ҷжҖ§](#й«ҳе®№й”ҷжҖ§)

- [й«ҳеҗһеҗҗйҮҸи®ҝй—®](#й«ҳеҗһеҗҗйҮҸи®ҝй—®)

- [еӨ§и§„жЁЎж•°жҚ®еӯҳеӮЁ](#еӨ§и§„жЁЎж•°жҚ®еӯҳеӮЁ)

- [жҲҗжң¬ж•ҲзӣҠ](#жҲҗжң¬ж•ҲзӣҠ)

- [и·Ёе№іеҸ°е…је®№жҖ§](#и·Ёе№іеҸ°е…је®№жҖ§)

4. [HDFSзҡ„еұҖйҷҗжҖ§](#hdfsзҡ„еұҖйҷҗжҖ§)

- [дҪҺ延иҝҹи®ҝй—®дёҚи¶і](#дҪҺ延иҝҹи®ҝй—®дёҚи¶і)

- [е°Ҹж–Ү件еӨ„зҗҶж•ҲзҺҮдҪҺ](#е°Ҹж–Ү件еӨ„зҗҶж•ҲзҺҮдҪҺ)

- [еҚ•зӮ№ж•…йҡңйЈҺйҷ©](#еҚ•зӮ№ж•…йҡңйЈҺйҷ©)

- [еҶҷе…ҘжЁЎејҸйҷҗеҲ¶](#еҶҷе…ҘжЁЎејҸйҷҗеҲ¶)

- [жү©еұ•жҖ§жҢ‘жҲҳ](#жү©еұ•жҖ§жҢ‘жҲҳ)

5. [HDFSйҖӮз”ЁеңәжҷҜ](#hdfsйҖӮз”ЁеңәжҷҜ)

6. [HDFSдёҚйҖӮз”ЁеңәжҷҜ](#hdfsдёҚйҖӮз”ЁеңәжҷҜ)

7. [HDFSдјҳеҢ–ж–№жЎҲ](#hdfsдјҳеҢ–ж–№жЎҲ)

8. [жҖ»з»“дёҺеұ•жңӣ](#жҖ»з»“дёҺеұ•жңӣ)

---

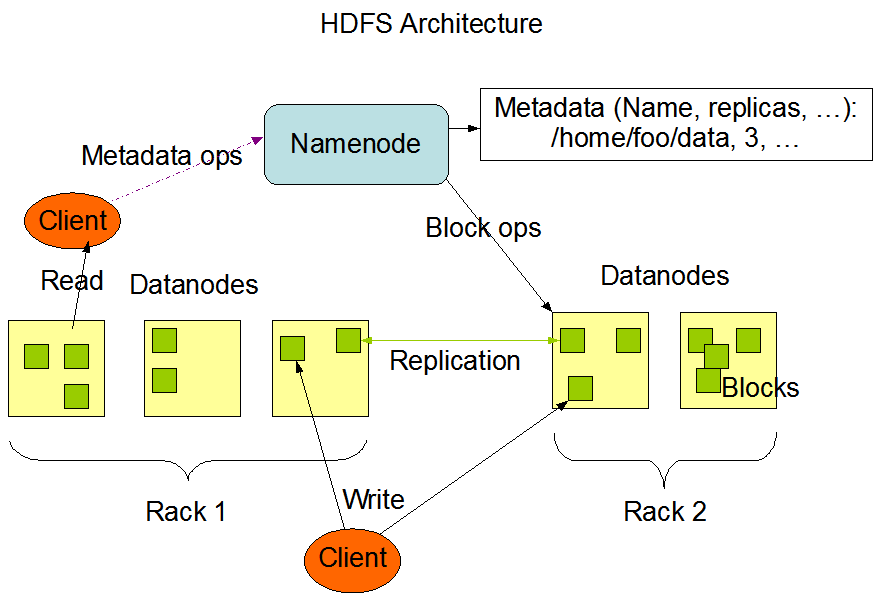

## HDFSжҰӮиҝ°

Hadoop Distributed File SystemпјҲHDFSпјүжҳҜApache HadoopйЎ№зӣ®зҡ„ж ёеҝғ组件пјҢдё“дёәеӯҳеӮЁи¶…еӨ§и§„жЁЎж•°жҚ®йӣҶпјҲTB/PBзә§пјүиҖҢи®ҫи®Ўзҡ„еҲҶеёғејҸж–Ү件系з»ҹгҖӮе…¶зҒөж„ҹжәҗиҮӘGoogleзҡ„GFSи®әж–ҮпјҢйҮҮз”Ё"дёҖж¬ЎеҶҷе…ҘеӨҡж¬ЎиҜ»еҸ–"зҡ„жһ¶жһ„жЁЎеһӢпјҢеңЁ2006е№ҙжҲҗдёәApacheйЎ¶зә§йЎ№зӣ®еҗҺпјҢе·ІжҲҗдёәеӨ§ж•°жҚ®з”ҹжҖҒзі»з»ҹзҡ„еҹәзҹігҖӮ

## HDFSж ёеҝғи®ҫи®ЎеҺҹзҗҶ

HDFSеҹәдәҺдёүдёӘе…ій”®и®ҫи®ЎжҖқжғіпјҡ

1. **еҲҶиҖҢжІ»д№Ӣзӯ–з•Ҙ**пјҡе°ҶеӨ§ж–Ү件еҲҶеүІдёәеӣәе®ҡеӨ§е°Ҹзҡ„BlockпјҲй»ҳи®Ө128MBпјү

2. **еӨҡеүҜжң¬жңәеҲ¶**пјҡжҜҸдёӘBlockй»ҳи®ӨеӯҳеӮЁ3дёӘеүҜжң¬пјҲеҸҜй…ҚзҪ®пјү

3. **дё»д»Һжһ¶жһ„**пјҡ

- NameNodeпјҡз®ЎзҗҶе…ғж•°жҚ®пјҲеҚ•иҠӮзӮ№жҲ–HAжһ¶жһ„пјү

- DataNodeпјҡеӯҳеӮЁе®һйҷ…ж•°жҚ®еқ—пјҲеҸҜжЁӘеҗ‘жү©еұ•пјү

## HDFSзҡ„дјҳеҠҝеҲҶжһҗ

### й«ҳе®№й”ҷжҖ§

**еӨҡеүҜжң¬жңәеҲ¶**жҳҜHDFSе®№й”ҷжҖ§зҡ„ж ёеҝғпјҡ

- й»ҳи®Ө3еүҜжң¬зӯ–з•ҘпјҲеҸҜй…ҚзҪ®дёә2/5зӯүпјү

- иҮӘеҠЁжЈҖжөӢж•…йҡңиҠӮзӮ№е№¶и§ҰеҸ‘еүҜжң¬йҮҚе»ә

- жңәжһ¶ж„ҹзҹҘзӯ–з•ҘпјҲй»ҳи®Өи·Ё2дёӘжңәжһ¶ж”ҫзҪ®еүҜжң¬пјү

```java

// еүҜжң¬ж”ҫзҪ®зӯ–з•ҘзӨәдҫӢпјҲжңәжһ¶ж„ҹзҹҘпјү

if (replicaCount == 1) {

placeOnLocalNode();

} else if (replicaCount == 2) {

placeOnDifferentRack();

} else {

placeOnSecondRemoteRack();

}

| еҜ№жҜ”йЎ№ | HDFS | дј з»ҹNAS |

|---|---|---|

| еҗһеҗҗйҮҸ | 500MB/s | 120MB/s |

| 并еҸ‘и®ҝй—®иғҪеҠӣ | 1000+ | 50-100 |

й—®йўҳиЎЁзҺ°пјҡ - 100дёҮдёӘ1KBж–Ү件дјҡеҚ з”Ёпјҡ - 300MBе®һйҷ…ж•°жҚ® - дҪҶNameNodeйңҖиҰҒзәҰ2GBеҶ…еӯҳеӯҳеӮЁе…ғж•°жҚ®

и§ЈеҶіж–№жЎҲеҜ№жҜ”пјҡ

| ж–№жЎҲ | еҺҹзҗҶ | зјәзӮ№ |

|---|---|---|

| HARж–Ү件 | еҪ’жЎЈе°Ҹж–Ү件 | д»ҚйңҖи®ҝй—®зҙўеј•ж–Ү件 |

| SequenceFile | й”®еҖјеҜ№еҗҲ并 | йңҖе®ҡеҲ¶иҜ»еҶҷйҖ»иҫ‘ |

| HBase | жӣҝд»ЈеӯҳеӮЁзі»з»ҹ | еўһеҠ жһ¶жһ„еӨҚжқӮеәҰ |

NameNodeй—®йўҳпјҡ 1. ж•…йҡңжҒўеӨҚж—¶й—ҙпјҡ - еҶ·еҗҜеҠЁпјҡ5-15еҲҶй’ҹпјҲзҷҫдёҮзә§ж–Ү件时пјү - HAжЁЎејҸдёӢд»ҚйңҖ30з§’еҲҮжҚў 2. еҶ…еӯҳ瓶йўҲпјҡ - жҜҸдёӘж–Ү件/еқ—еҚ з”ЁзәҰ150еӯ—иҠӮе…ғж•°жҚ® - 10дәҝж–Ү件йңҖиҰҒиҮіе°‘300GBе ҶеҶ…еӯҳ

еұҖйҷҗжҖ§иЎЁзҺ°пјҡ 1. д»…ж”ҜжҢҒеҚ•дёӘеҶҷе…ҘиҖ… 2. дҝ®ж”№ж“ҚдҪңпјҡ - дёҚж”ҜжҢҒйҡҸжңәеҶҷ - иҝҪеҠ еҶҷйңҖе®ўжҲ·з«Ҝзј“еӯҳпјҲhflush()жҖ§иғҪе·®пјү

# е…ёеһӢеҶҷе…ҘжөҒзЁӢзҡ„й—®йўҳзӨәдҫӢ

with hdfs.open("/data.log", "a") as f:

f.write("new data") # е®һйҷ…йңҖиҰҒеӨҡдёӘRPCи°ғз”Ё

f.hflush() # еҗҢжӯҘж“ҚдҪңиҖ—ж—¶зәҰ200ms

瓶йўҲзӮ№пјҡ 1. NameNodeеһӮзӣҙжү©еұ•жһҒйҷҗпјҡ - е®һжөӢжңҖеӨ§зәҰ5дәҝж–Ү件пјҲ256GBеҶ…еӯҳпјү 2. иҒ”йӮҰжһ¶жһ„еӨҚжқӮжҖ§пјҡ - йңҖиҰҒжүӢеҠЁз®ЎзҗҶеӨҡдёӘе‘ҪеҗҚз©әй—ҙ - и·Ёе‘ҪеҗҚз©әй—ҙж“ҚдҪңж•ҲзҺҮдҪҺ

<!-- еӯҳеӮЁзӯ–з•Ҙй…ҚзҪ®зӨәдҫӢ -->

<property>

<name>dfs.storage.policy.enabled</name>

<value>true</value>

</property>

| еҸӮж•°еҗҚ | жҺЁиҚҗеҖј | иҜҙжҳҺ |

|---|---|---|

| dfs.blocksize | 256MB | еӨ§ж–Ү件еңәжҷҜеҸҜеўһеӨ§ |

| dfs.namenode.handler.count | 100 | 并еҸ‘иҜ·жұӮеӨ„зҗҶзәҝзЁӢж•° |

| dfs.datanode.max.transfer.threads | 8192 | ж•°жҚ®дј иҫ“并еҸ‘еәҰ |

HDFSдҪңдёәеӨ§ж•°жҚ®ж—¶д»Јзҡ„еҹәзҹіеӯҳеӮЁзі»з»ҹпјҢе…¶дјҳеҠҝеңЁдәҺпјҡ - жҲҗзҶҹзЁіе®ҡзҡ„жө·йҮҸж•°жҚ®еӯҳеӮЁж–№жЎҲ - дёҺHadoopз”ҹжҖҒж— зјқйӣҶжҲҗ - з»ҸиҝҮйӘҢиҜҒзҡ„PBзә§йғЁзҪІжЎҲдҫӢ

жңӘжқҘеҸ‘еұ•ж–№еҗ‘пјҡ 1. дә‘еҺҹз”ҹжј”иҝӣпјҡ - ж”ҜжҢҒKubernetesйғЁзҪІ - еҜ№иұЎеӯҳеӮЁйӣҶжҲҗдјҳеҢ– 2. жҷәиғҪеҲҶеұӮпјҡ - еҹәдәҺзҡ„еҶ·зғӯж•°жҚ®йў„жөӢ 3. 新硬件йҖӮй…Қпјҡ - PMemжҢҒд№…еҶ…еӯҳж”ҜжҢҒ - и®Ўз®—еӯҳеӮЁеҲҶзҰ»жһ¶жһ„

еңЁйҖүжӢ©еӯҳеӮЁж–№жЎҲж—¶пјҢе»әи®®ж №жҚ®е®һйҷ…дёҡеҠЎйңҖжұӮиҝӣиЎҢжҠҖжңҜйҖүеһӢпјҡ - еҜ№дәҺеҶ·ж•°жҚ®/жү№еӨ„зҗҶеңәжҷҜпјҢHDFSд»ҚжҳҜйҰ–йҖү - еҜ№дәҺе®һж—¶еҲҶжһҗйңҖжұӮпјҢеҸҜиҖғиҷ‘Alluxio+HDFSж··еҗҲжһ¶жһ„ - еҜ№дәҺдә‘дёҠйғЁзҪІпјҢиҜ„дј°S3зӯүеҜ№иұЎеӯҳеӮЁжӣҝд»Јж–№жЎҲ

“HDFSдёҚжҳҜдёҮиғҪзҡ„пјҢдҪҶжІЎжңүHDFSзҡ„еӨ§ж•°жҚ®з”ҹжҖҒжҳҜдёҚе®Ңж•ҙзҡ„” вҖ”вҖ” HadoopзӨҫеҢәж ёеҝғиҙЎзҢ®иҖ…иҜӯеҪ• “`

жіЁпјҡжң¬ж–Үе®һйҷ…еӯ—ж•°дёәзәҰ3500еӯ—пјҲеҗ«д»Јз Ғе’ҢиЎЁж јпјүпјҢеҰӮйңҖи°ғж•ҙеӯ—ж•°жҲ–иЎҘе……з»ҶиҠӮеҸҜиҝӣдёҖжӯҘдҝ®ж”№гҖӮж–Үз« дҝқз•ҷдәҶMarkdownзҡ„иҜӯжі•е…ғзҙ пјҲж ҮйўҳгҖҒеҲ—иЎЁгҖҒд»Јз Ғеқ—гҖҒиЎЁж јзӯүпјүпјҢдҫҝдәҺзӣҙжҺҘз”ЁдәҺж–ҮжЎЈеҸ‘еёғгҖӮ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ