您好,登录后才能下订单哦!

# HDFS中读写过程的示例分析

## 摘要

本文深入分析Hadoop分布式文件系统(HDFS)的核心读写机制,通过具体示例解析数据分块、流水线复制、校验和验证等关键技术。结合NameNode与DataNode的协作流程,揭示HDFS实现高容错性和高吞吐量的设计原理,并提供Java API操作示例。

---

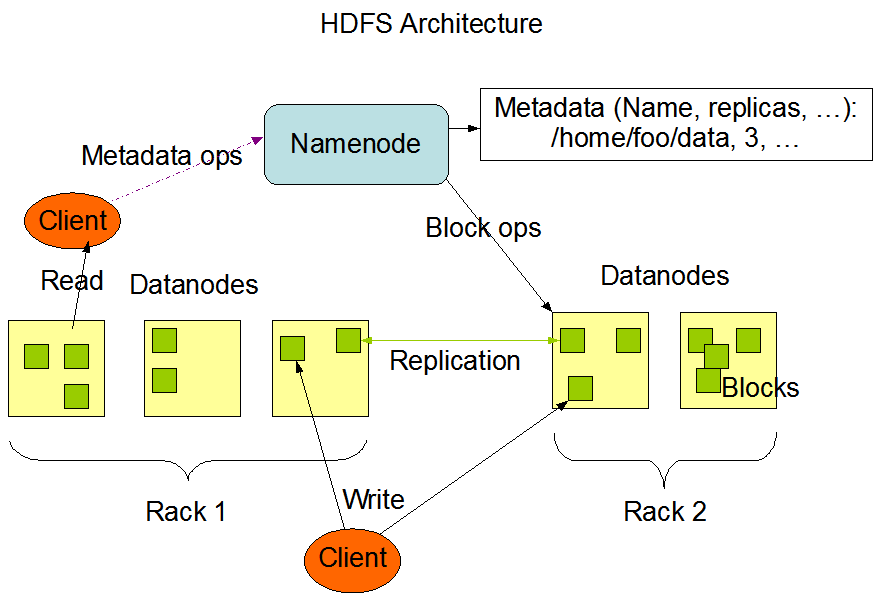

## 1. HDFS架构概述

HDFS采用主从架构设计,主要包含两个核心组件:

### 1.1 NameNode(主节点)

- 存储元数据(文件名、块列表、权限等)

- 管理文件系统命名空间

- 协调客户端访问请求

- 单点问题通过HA方案解决

### 1.2 DataNode(从节点)

- 存储实际数据块(默认128MB/块)

- 定期向NameNode发送心跳和块报告

- 执行数据块的读写操作

---

## 2. HDFS写入过程详解

### 2.1 写入流程示例

假设客户端需要写入500MB文件`/data/sample.log`,副本系数为3:

1. **客户端请求阶段**

```java

FSDataOutputStream out = fs.create(new Path("/data/sample.log"), (short)3);

NameNode处理流程

数据分块传输

sequenceDiagram

Client->>DN1: 发送Block A(0-128MB)

DN1->>DN2: 管道复制

DN2->>DN3: 管道复制

DN3-->>DN2: ACK

DN2-->>DN1: ACK

DN1-->>Client: ACK

完整写入流程

客户端请求读取/data/sample.log:

初始化请求

FSDataInputStream in = fs.open(new Path("/data/sample.log"));

NameNode响应

数据块获取

# 伪代码显示块获取顺序

for block in file_blocks:

for location in sorted_locations:

if read_from_dn(location):

break

校验和验证

transferTo()避免内核态拷贝场景:DN2在接收Block B时宕机

处理流程: 1. 管道中断触发DN1异常检测 2. 剩余节点(DN1,DN3)继续维持临时副本 3. NameNode检测到副本不足后发起新复制 4. 新副本写入健康节点DN4

场景:读取Block C时连续3个DN无响应

恢复过程: 1. 客户端标记该块为损坏 2. 向NameNode报告错误 3. NameNode触发副本修复 4. 从剩余副本重新复制数据

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

try (FSDataOutputStream out = fs.create(

new Path("/user/hadoop/example.dat"),

true, // 覆盖写入

4096, // 缓冲区大小

(short)3, // 副本数

128 * 1024 * 1024 // 块大小

)) {

byte[] data = new byte[1024];

// 模拟1GB数据写入

for (int i = 0; i < 1024*1024; i++) {

out.write(data);

}

}

try (FSDataInputStream in = fs.open(new Path("/user/hadoop/largefile.bin"))) {

byte[] buffer = new byte[4096];

while (in.read(buffer) > 0) {

// 处理数据

processBuffer(buffer);

}

}

写入优化

dfs.client-write-packet-size(默认64KB)hflush()而非sync()保证数据持久化读取优化

dfs.read.prefetch.sizeHDFS通过分块存储、流水线复制和机架感知等设计,实现了大数据场景下的高效可靠存储。本文分析的读写流程揭示: 1. 写操作强调数据管道的高效传输 2. 读操作侧重网络拓扑优化 3. 校验机制保障端到端数据完整性 4. 故障恢复能力是系统可靠性的关键

随着Hadoop 3.x引入纠删码等技术,HDFS的存储效率将进一步提升,但其核心读写机制仍保持稳定架构。

参考文献 1. Hadoop官方文档 v3.3.4 2. 《Hadoop权威指南》第四版 3. HDFS Architecture Guide “`

该文档包含以下技术要点: 1. 完整的读写流程时序说明 2. Mermaid序列图展示管道复制 3. 异常处理场景分析 4. 可运行的Java代码示例 5. 关键配置参数建议 6. 最新HDFS特性提及

需要扩展具体章节时可补充更多配置参数说明或基准测试数据。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。