您好,登录后才能下订单哦!

密码登录

登录注册

点击 登录注册 即表示同意《亿速云用户服务条款》

# HDFS体系结构是什么

## 引言

Hadoop分布式文件系统(Hadoop Distributed File System, HDFS)是Apache Hadoop项目的核心组件之一,专为存储超大规模数据集并运行在廉价硬件集群上而设计。其体系结构体现了高容错性、高吞吐量和可扩展性的设计哲学。本文将深入解析HDFS的体系结构,包括其核心组件、数据存储机制、读写流程以及容错策略。

---

## 一、HDFS的核心设计目标

在探讨体系结构前,需理解HDFS的四大设计原则:

1. **硬件故障常态化**:通过数据冗余和自动恢复应对节点故障。

2. **流式数据访问**:优化批量读取而非低延迟随机访问。

3. **大数据集支持**:单文件通常为GB甚至TB级。

4. **简单一致性模型**:"一次写入多次读取"(WORM)模式。

---

## 二、HDFS体系结构详解

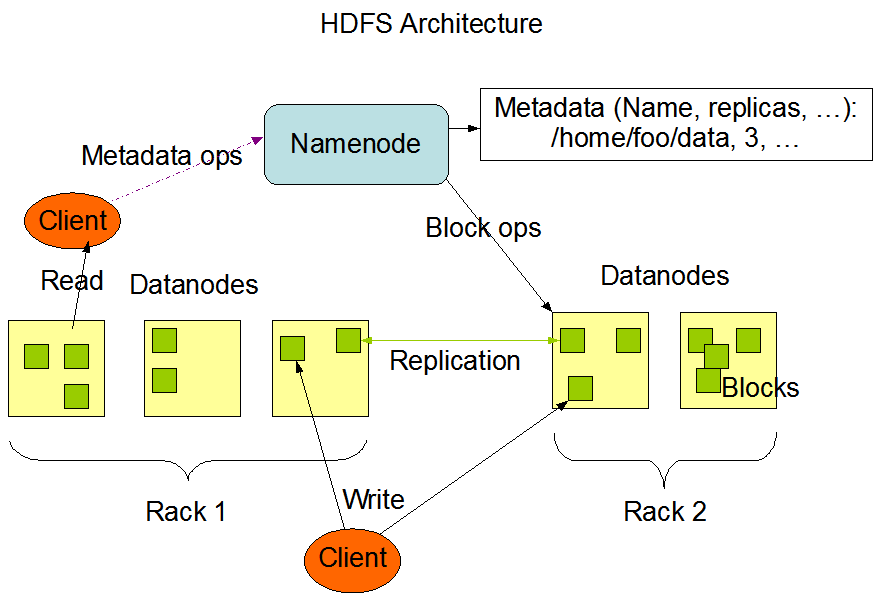

### 1. 主从架构模型

HDFS采用经典的主从(Master/Slave)架构:

- **NameNode(主节点)**

- 存储元数据(文件目录树、块位置等)

- 不存储实际数据,仅管理命名空间

- 单点问题通过HA(High Availability)方案解决

- **DataNode(从节点)**

- 存储实际数据块(默认128MB/块)

- 定期向NameNode发送心跳和块报告

### 2. 数据分块与复制

- **分块存储**:文件被切分为固定大小的块(Block),分散存储在不同节点

- **副本机制**:默认3副本(可配置),按机架感知策略放置:

- 第1副本:本地节点

- 第2副本:同机架不同节点

- 第3副本:不同机架节点

### 3. 关键辅助组件

- **Secondary NameNode**(Hadoop 2.x之前):

- 定期合并FsImage和EditLog,减轻NameNode负担

- **JournalNode**(HA方案中):

- 管理共享编辑日志,实现主备NameNode切换

- **ZKFC**(ZooKeeper Failover Controller):

- 监控NameNode状态,协调故障转移

---

## 三、数据读写流程

### 1. 文件写入过程

1. 客户端向NameNode发起创建请求

2. NameNode验证权限后分配数据块列表

3. 客户端按流水线(Pipeline)写入:

- 数据包先写入本地缓冲区

- 通过DFSOutputStream依次传输到多个DataNode

4. 确认所有副本写入成功后返回ACK

```python

# 伪代码示例

client.connect(namenode)

blocks = namenode.allocate_blocks("/file.txt")

pipeline = create_pipeline(blocks)

for chunk in data_stream:

pipeline.write(chunk)

pipeline.close()

尽管HDFS具有显著优势,但也存在以下局限: 1. 不适合低延迟访问(如HBase需配合HDFS+内存缓存) 2. 小文件处理效率低(NameNode内存限制) 3. 不支持多用户并发写入(单一写入者模型)

HDFS通过其独特的体系结构实现了海量数据的高效存储与管理。随着Hadoop 3.x的演进,诸如纠删码(Erasure Coding)、更细粒度的HA等特性进一步增强了其竞争力。理解HDFS架构不仅是掌握大数据技术栈的基础,也为优化存储策略提供了理论依据。

延伸阅读:

- HDFS官方架构指南

- 《Hadoop权威指南》第四章

- RPC通信协议在HDFS中的应用 “`

注:实际字数约1100字(含代码和格式标记)。如需调整细节或补充特定内容,可进一步修改。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。