您好,登录后才能下订单哦!

温馨提示:要看高清无码套图,请使用手机打开并单击图片放大查看。

1.前置条件

本文档将介绍Cloudera Manager与CDH的卸载,并基于CDH使用parcels安装且未配置安全(AD/LDAP, Kerberos, Data Encryption)的集群,以下是本次测试环境,但不是本操作手册的硬限制:

1.操作系统版本:CENTOS6.5

2.MySQL数据库版本为5.1.73

3.CM版本:CM 5.11

4.CDH版本:CDH 5.11

5.采用root或有sudo权限用户对集群进行卸载

2.用户数据备份

2.1备份HDFS数据

使用distcp进行集群之间数据复制进行hdfs数据备份,备份操作如下:

hadoop distcp hftp://namenodeA:port/xxx/ hdfs://namenodeB/xxx注:此命令需运行在目标集群中执行,确保目标集群空间足够,以上数据目录根据自己集群的真实环境做相应的修改;

namenodeA:源集群namenode节点ip地址

port:源集群端口,默认50070

namenodeB:目标集群namenode节点ip地址

xxx:对应hdfs的数据目录

登录namenode服务器上,进行如下操作:

#进入safemode模式

[root@ip-172-31-3-217 ~]# sudo -u hdfs hadoop dfsadmin -safemode ente

DEPRECATED: Use of this script to execute hdfs command is deprecated.

Instead use the hdfs command for it.

Safe mode is ON

#将所有edits修改flush到fsimage

[root@ip-172-31-3-217 ~]# sudo -u hdfs hadoop dfsadmin –saveNamespace

DEPRECATED: Use of this script to execute hdfs command is deprecated.

Instead use the hdfs command for it.

Save namespace successful将namenode元数据备份,根据自己集群namenode目录进行如下操作:

[root@ip-172-31-3-217 ~]# mkdir namenode_back

[root@ip-172-31-3-217 ~]# cd namenode_back/

[root@ip-172-31-3-217 ~]# cd /dfs/nn/

#将nn目录下所有文件压缩至/root/namenode_back/nn_back.tar.gz目录下

[root@ip-172-31-3-217 nn]# tar -czvf /root/namenode_back/nn_back.tar.gz .

./

./current/

./current/fsimage

./current/fstime

./current/VERSION

./current/edits

./image/

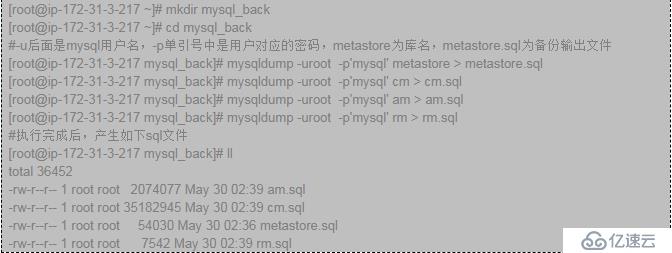

./image/fsimage2.2备份MySQL元数据

注:如果有hue,sentry,Navigator数据库可以同样备份

2.3备份CDH集群配置数据

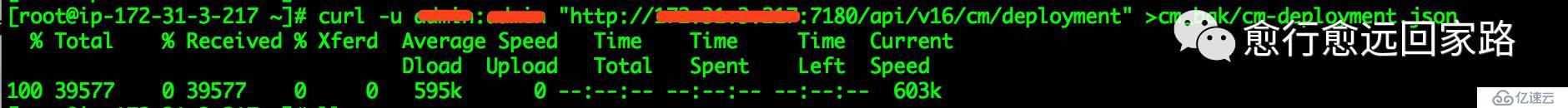

通过Cloudera Manager提供的API接口,导出一份JSON文档,该文档包含Cloudera 管理器实例的配置数据,可以通过这份JSON文档备份或恢复Cloudera管理器的部署。

[root@ip-172-31-3-217 ~]# curl -u admin_username:admin_pass "http://cm_server_host:7180/api/v16/cm/deployment" > path_to_file/cm-deployment.jsonadmin_username: 登录到ClouderaManager的用户名

admin_pass: 对应admin_username用户的密码

cm_server_host: 是ClouderaManager服务器的主机名

path_to_file: 保存配置文件的路径

将上述提到的四个参数修改当前集群对应的信息即可

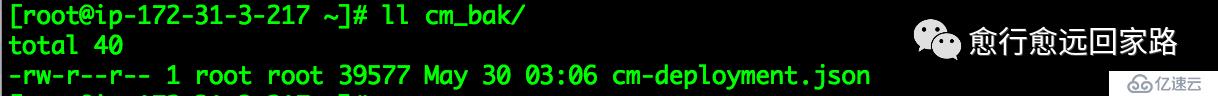

导出截图:

注意:此功能只有Cloudera许可证才可以使用

1.首先进入Cloudera Manager管理平台,进入如下操作

注意:如果在进行API调用操作之前未停止集群,那么API调用将在运行作业之前停止所有集群服务,任何运行的作业和数据都会丢失。

2.登录到Cloudera Manager所在的服务器

3.执行如下命令

curl --upload-file path_to_file/cm-deployment.json -u admin_uname:admin_pass http://cm_server_host:7180/api/v16/cm/deployment?deleteCurrentDeployment=trueadmin_uname: 登录到ClouderaManager的用户名

admin_pass: 对应admin_uname用户的密码

cm_server_host: 是ClouderaManager服务器的主机名

path_to_file:JSON配置文件的路径

2.4Zookeeper数据目录备份

[root@ip-172-31-3-217 ~]# mkdir zookeeper_back

[root@ip-172-31-3-217 ~]# scp -r /var/lib/zookeeper/ /root/zookeeper_back/zookeeper_12.5备份用户数据目录

以下路径为Cloudera默认安装目录下个组件用户数据:

/var/lib/flume-ng

/var/lib/hadoop*

/var/lib/hue

/var/lib/navigator

/var/lib/oozie

/var/lib/solr

/var/lib/sqoop*

/var/lib/zookeeper #同步数据

#data_driver_path为集群环境部署时设置的目录,根据自己环境进行调整

data_drive_path/dfs

data_drive_path/mapred

data_drive_path/yarn如需备份相关组件数据,可参考2.4进行数据备份。

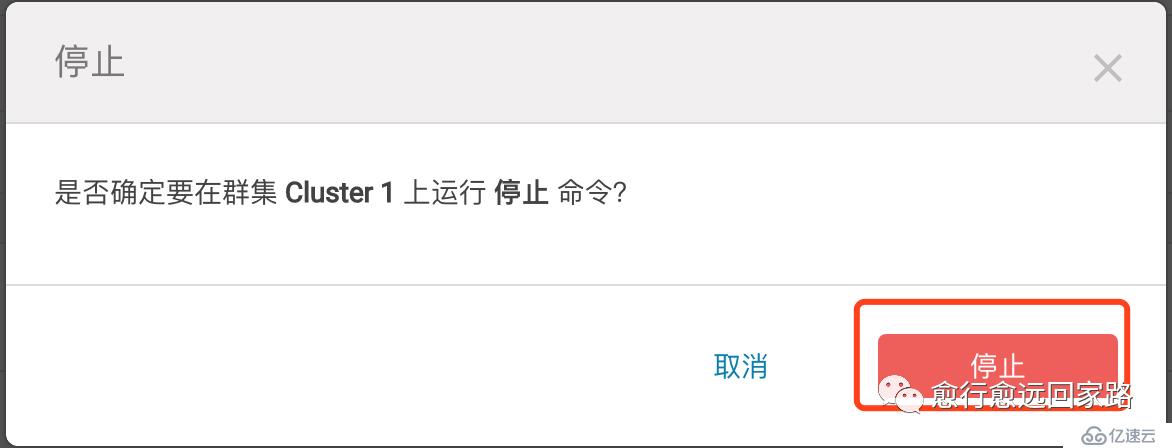

3.停止所有服务

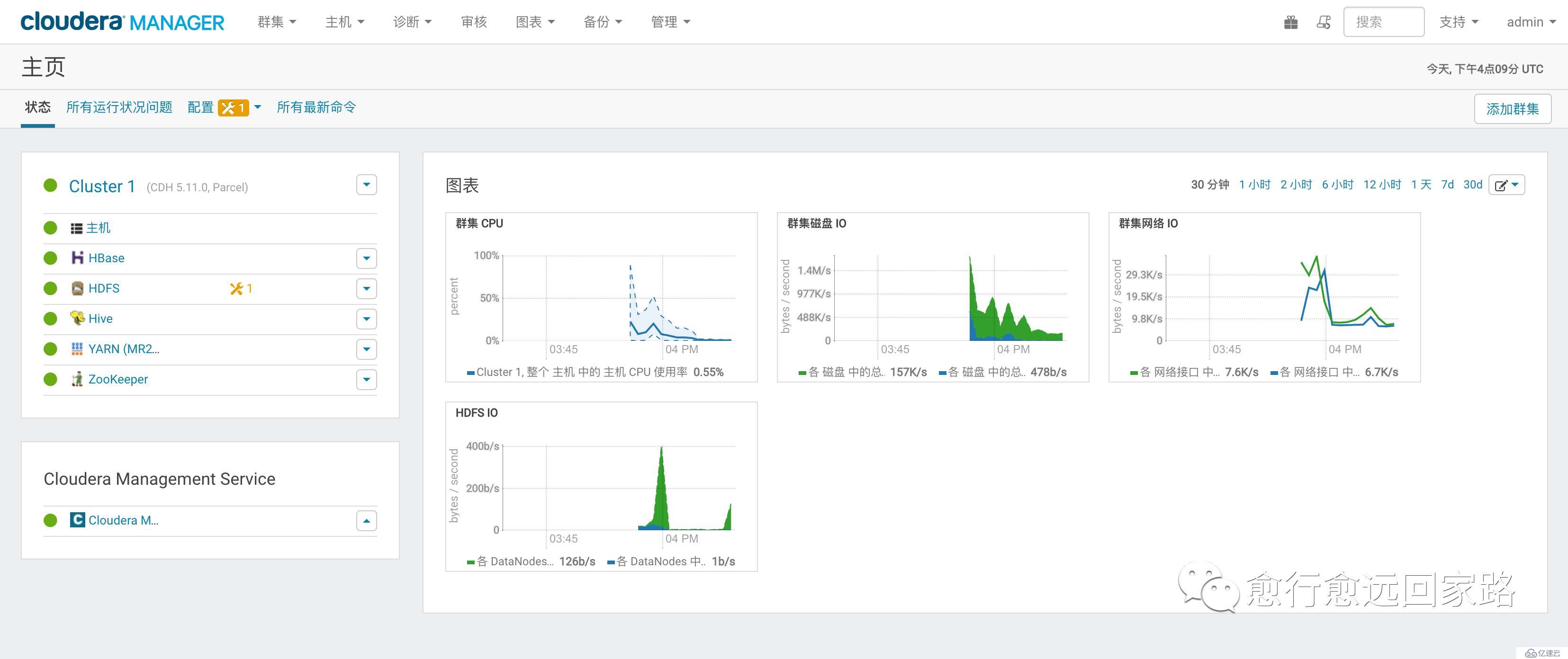

3.1打开Cloudera Manager控制台

3.2关闭集群

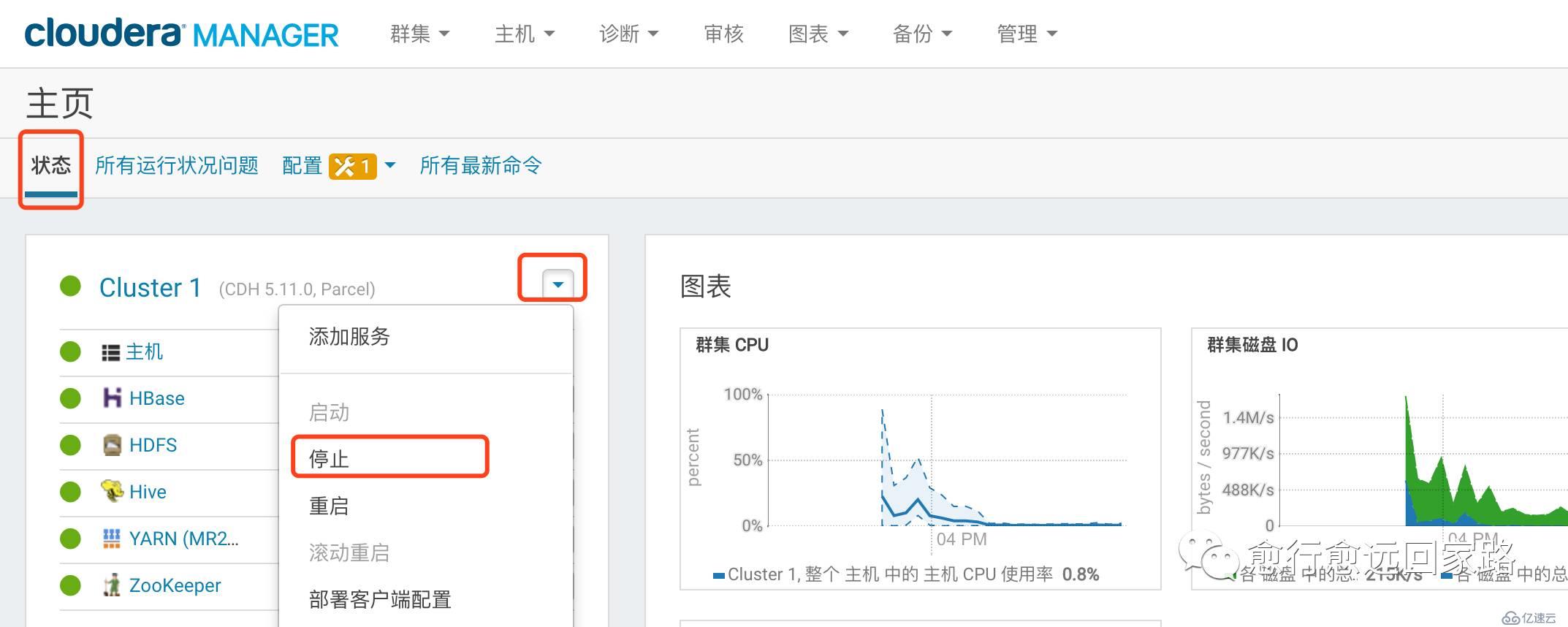

停止CDH集群,如下图所示操作

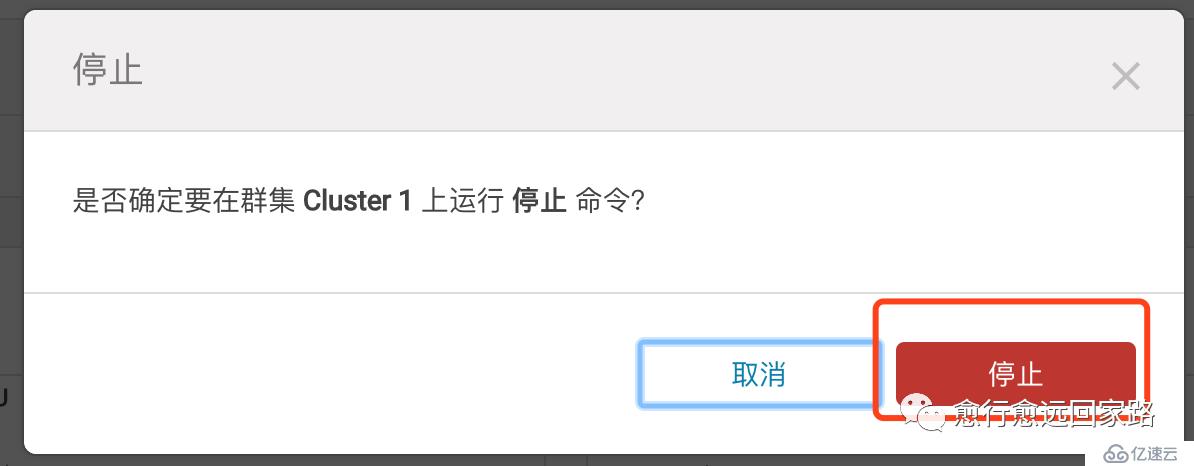

点击确认操作,如下图所示

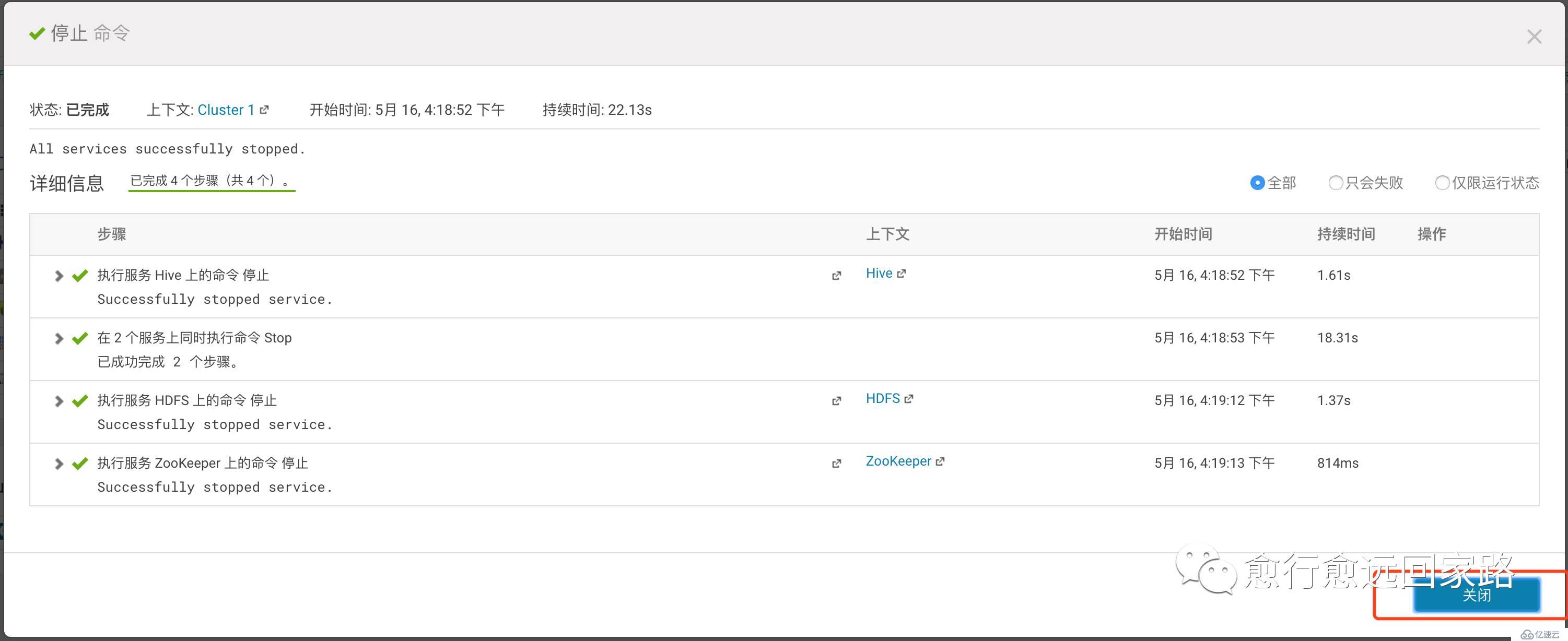

等待所有服务器停止操作成功,如下图所示

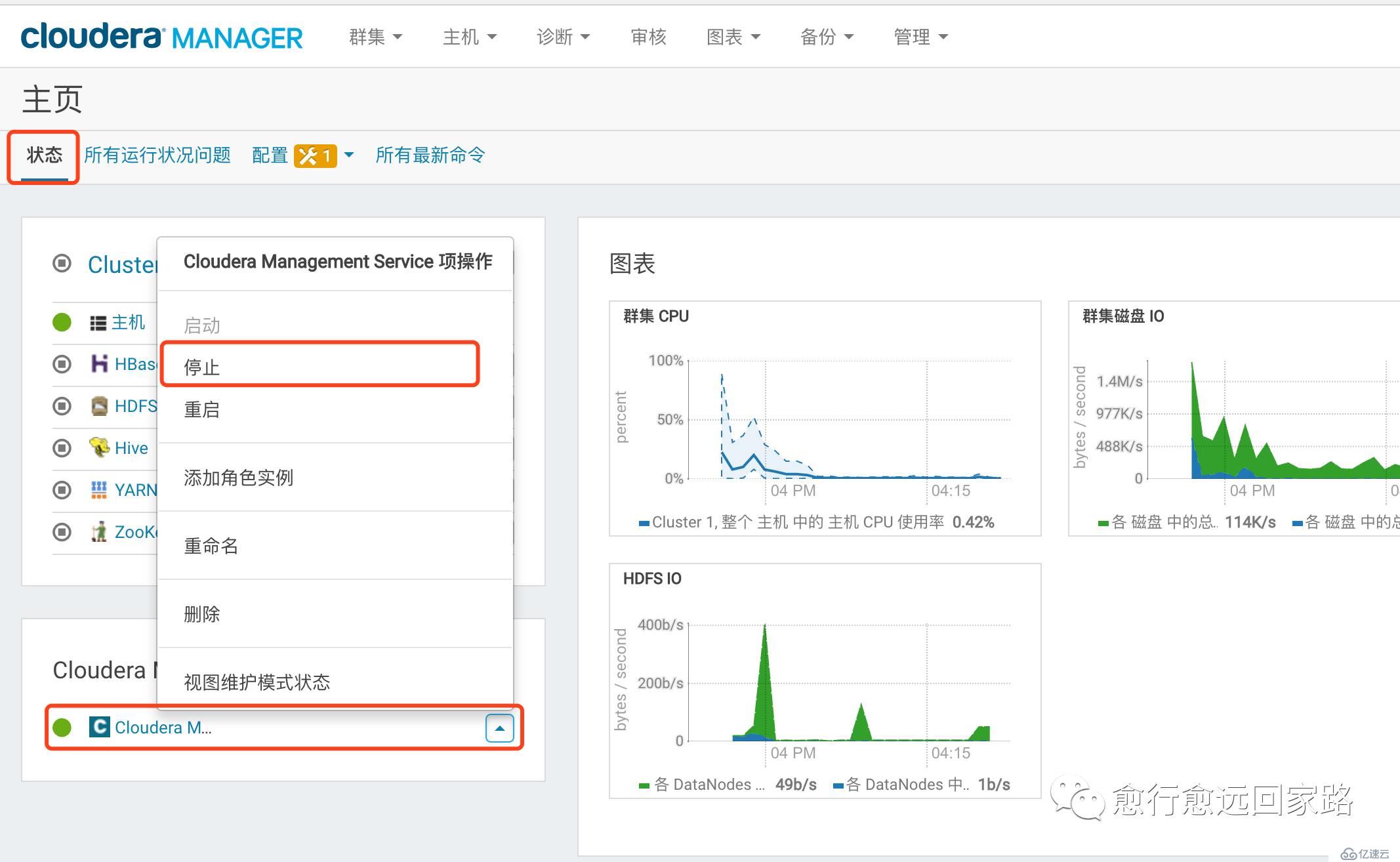

3.3关闭Cloudera Management Service

停止Cloudera Manager Service,如下图所示

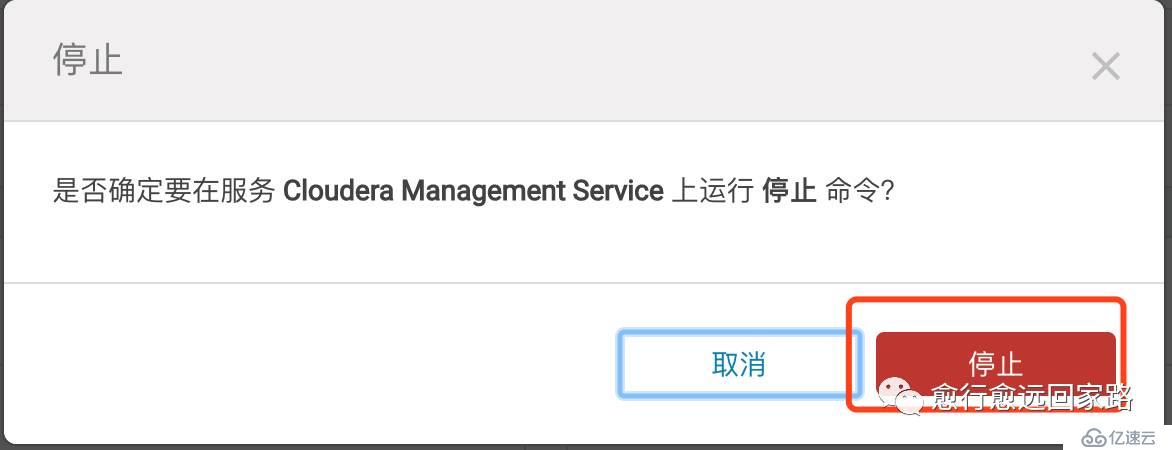

点击确认对话框,如下图所示

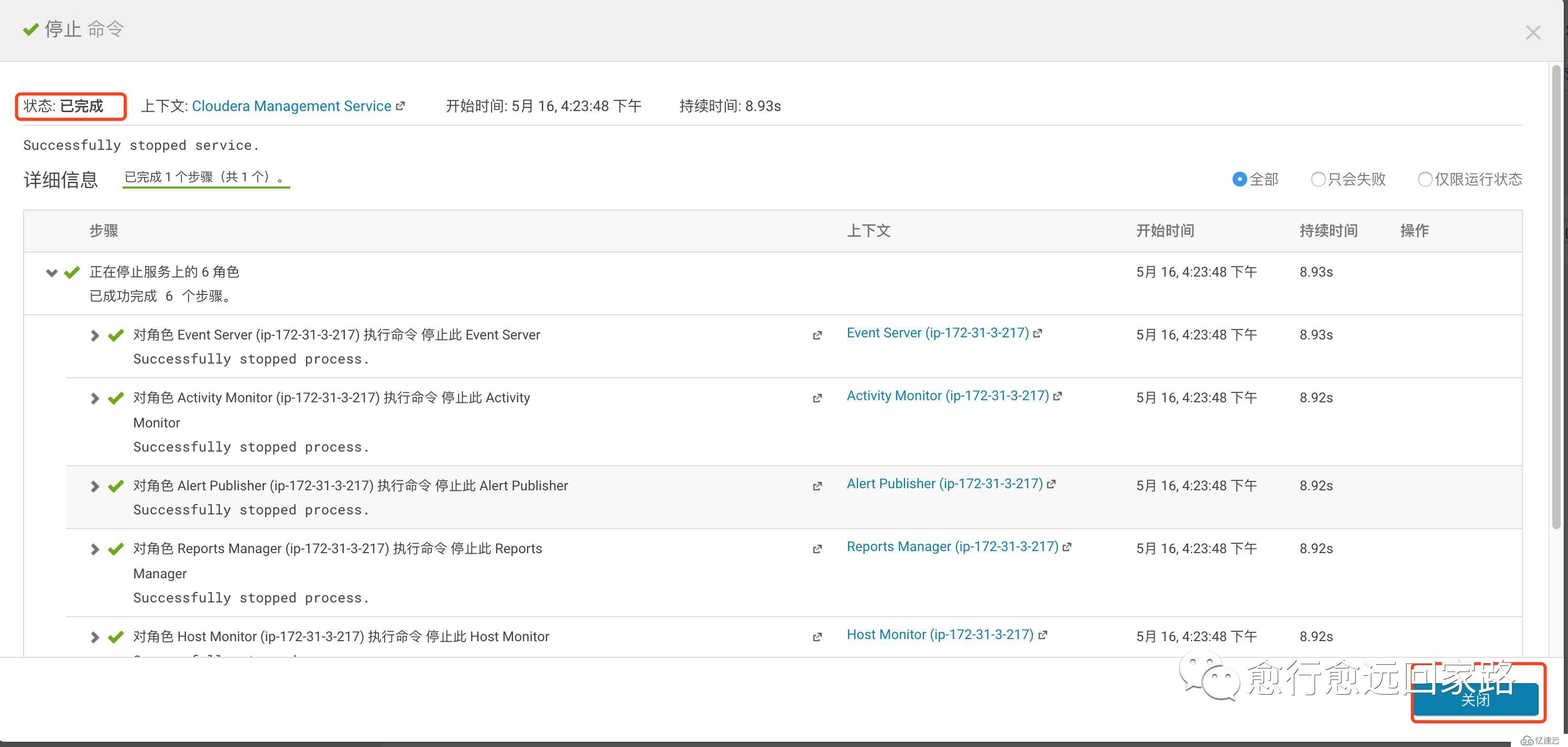

等待服务停止成功,如下图所示

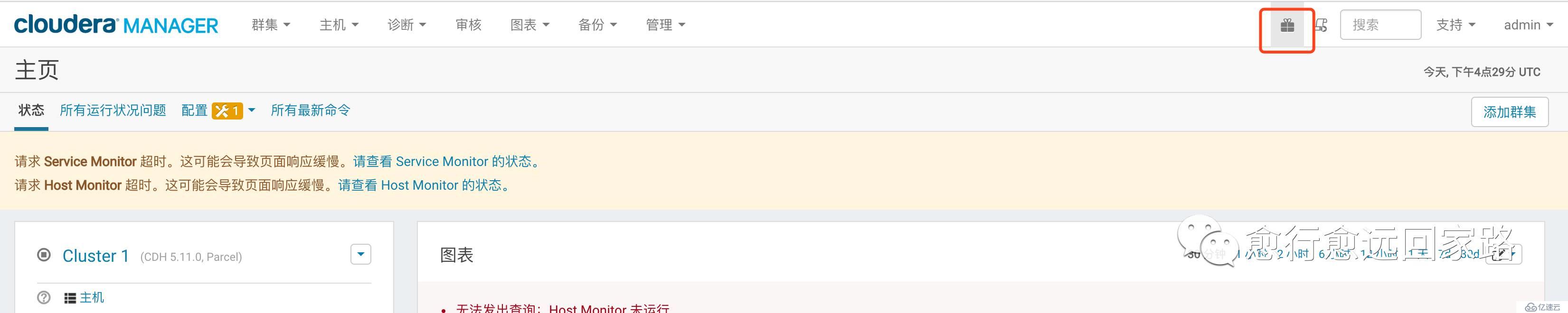

4.解除并移除Parcels

在Cloudera Manager管理界面,进行如下操作

点击上图标识功能,进入如下界面

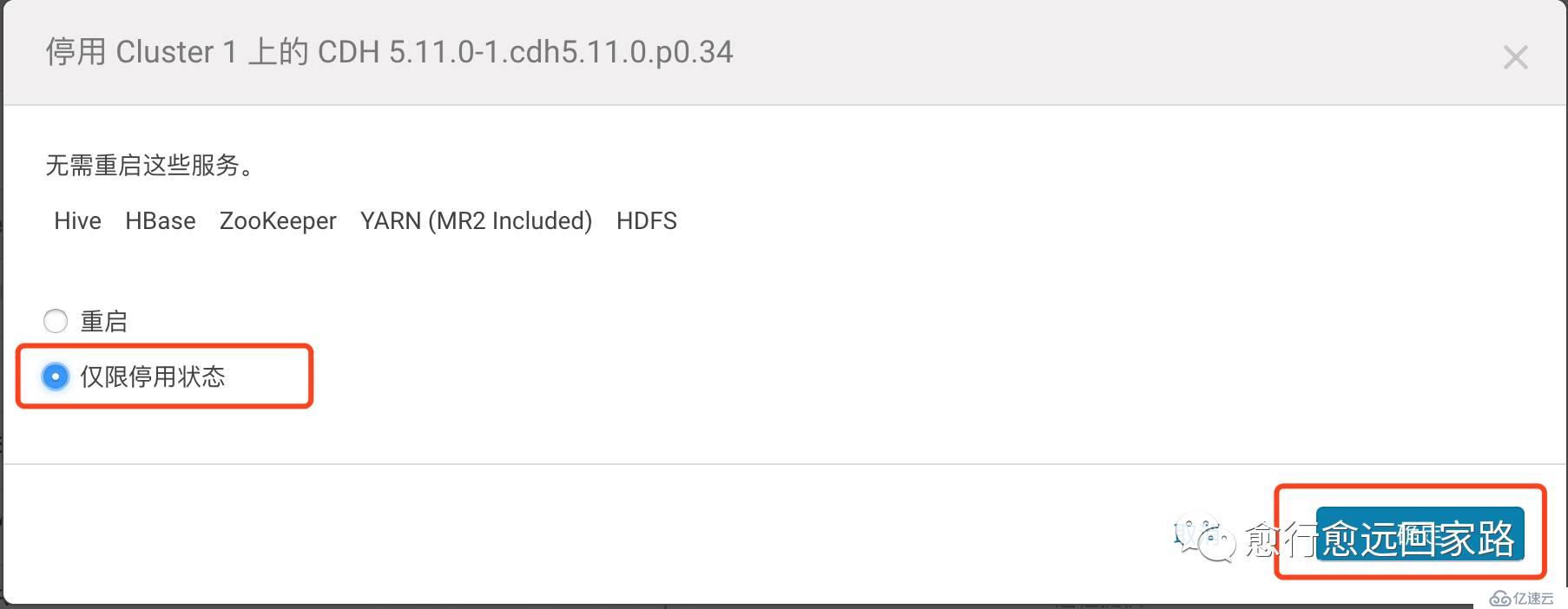

点击上图标识,选择【仅限停用状态】,点击【确定】

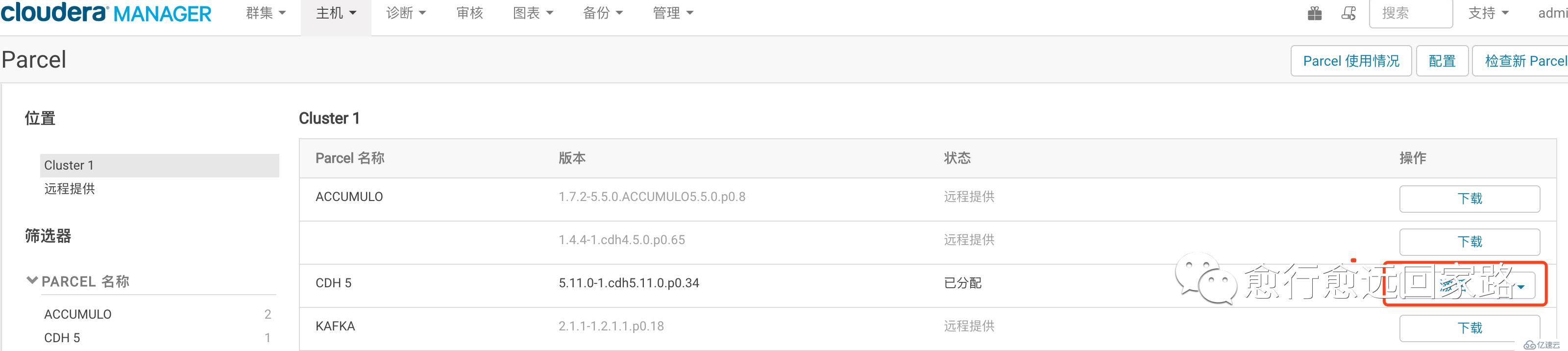

停用后,状态变为“激活”,如下图所示

点击“激活”旁菜单,选择“从主机删除”,如下图所示

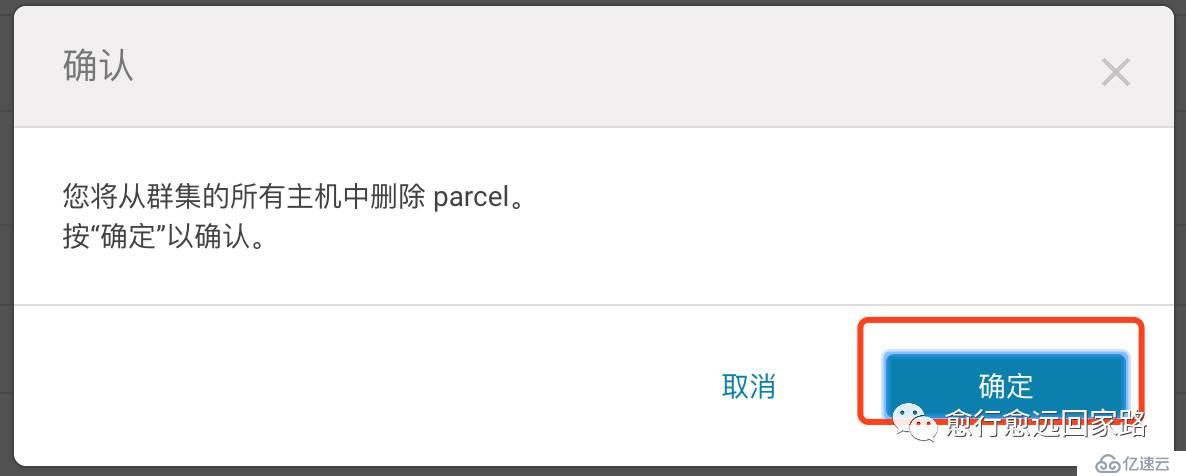

点击确认,如下图所示

删除成功后显示如下

5.删除集群

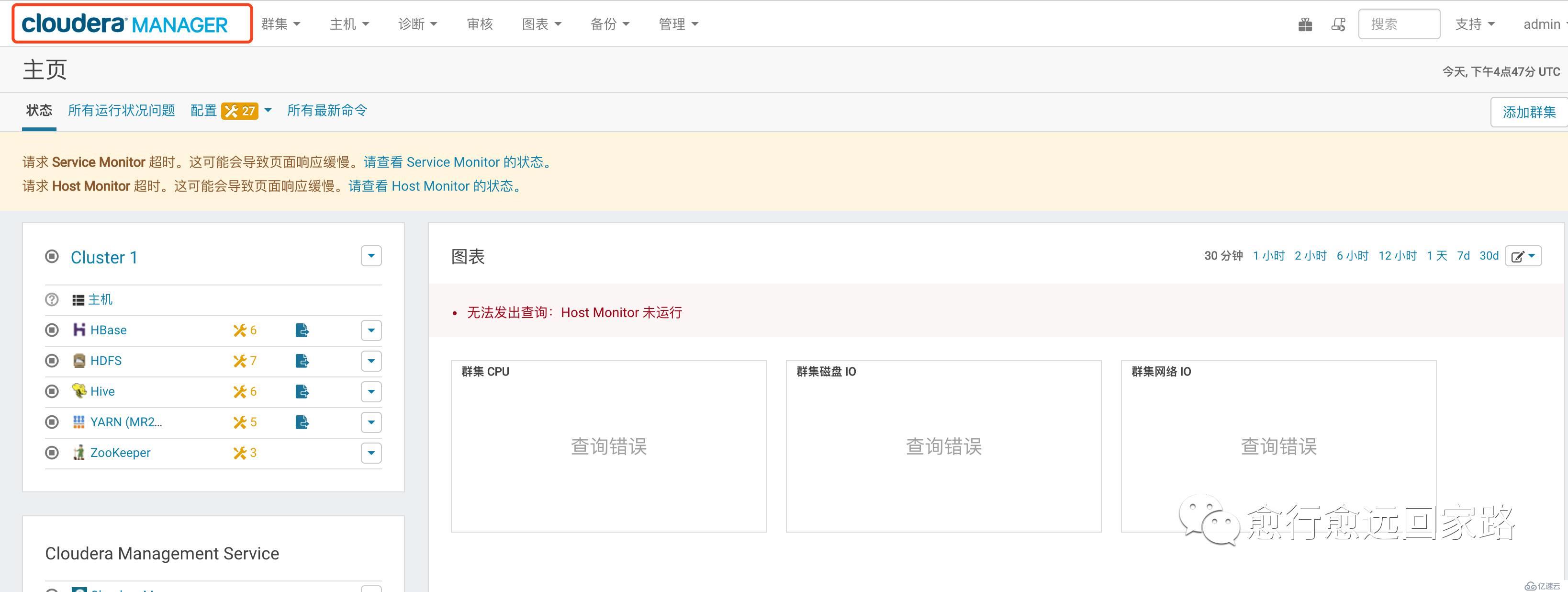

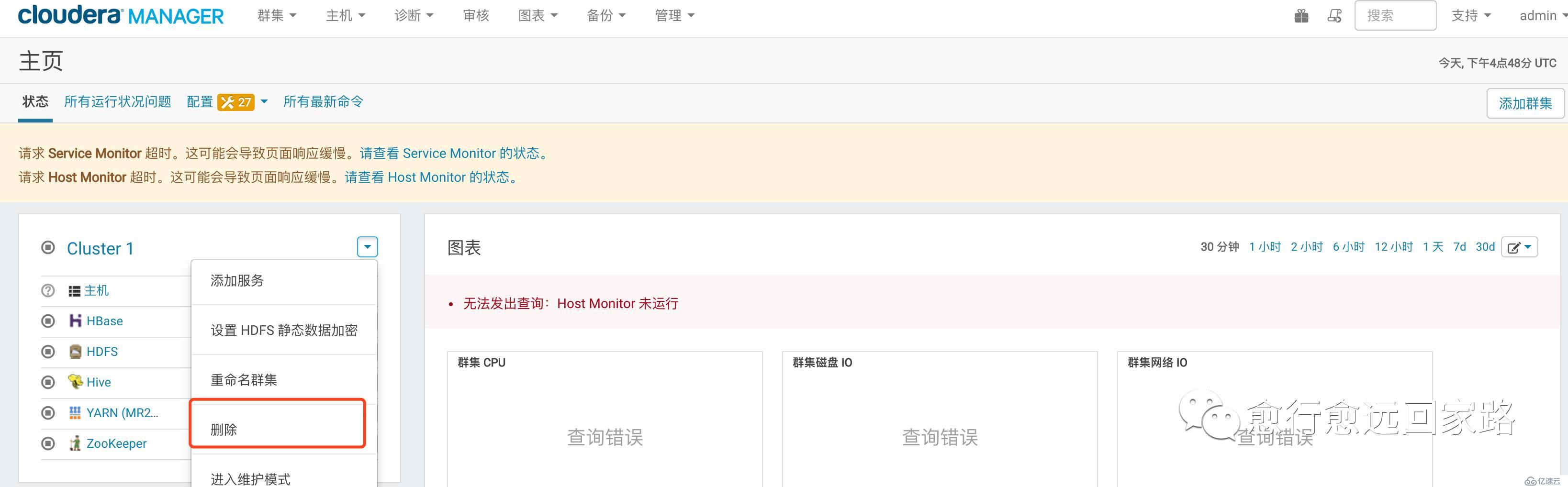

点击Clouder Manager进入主页,如下图所示

删除集群,如下操作

点击“删除”操作,如下图所示

删除成功后显示如下

6.卸载Cloudera Manager Server

6.1停止Cloudera Manager Server和数据库

在集群master服务器上执行如下命令

[root@ip-172-31-3-217 ~]# service cloudera-scm-server stop

#如果使用内置db postgresql需要停止该服务,没有则忽略

[root@ip-172-31-3-217 ~]# service cloudera-scm-server-db stop6.2卸载Cloudera Manager Server和数据库

使用yum卸载cloudera-scm-server和cloudera-scm-server-db-2,命令如下

[root@ip-172-31-3-217 ~]# yum remove cloudera-manager-server

#如果使用内置db postgresql需要移除该服务,没有则忽略

[root@ip-172-31-3-217 ~]# yum remove cloudera-manager-server-db-27.卸载Cloudera Manager Agent和Managed Software

在集群所有的机器上进行如下操作,卸载Cloudera Manager Agent 和Managed Software。

7.1停止Cloudera Manager Agent

在所有服务器上使用如下命令停止Cloudera Manager Agent 服务

[root@ip-172-31-3-217 ~]# sudo service cloudera-scm-agent hard_stop7.2卸载软件

在集群所有节点执行如下操作:

[root@ip-172-31-3-217 ~]# yum remove 'cloudera-manager-*' avro-tools crunch flume-ng hadoop-hdfs-fuse hadoop-hdfs-nfs3 hadoop-httpfs hadoop-kms hbase-solr hive-hbase hive-webhcat hue-beeswax hue-hbase hue-impala hue-pig hue-plugins hue-rdbms hue-search hue-spark hue-sqoop hue-zookeeper impala impala-shell kite llama mahout oozie pig pig-udf-datafu search sentry solr-mapreduce spark-core spark-master spark-worker spark-history-server spark-python sqoop sqoop2 whirr hue-common oozie-client solr solr-doc sqoop2-client zookeeper7.3运行清除命令

在集群所有节点执行如下操作:

[root@ip-172-31-3-217 ~]# yum clean all8.移除Cloudera Manager和用户数据

8.1杀死 Cloudera Manager和Managed进程

在集群所有节点执行如下操作,将所有服务器的Cloudera Manager和Managed进程杀死,命令如下:

8.2移除Cloudera Manager数据

在集群所有节点执行如下命令,删除所有Cloudera Manager数据

umount cm_processes

rm –rf /usr/share/cmf /var/lib/cloudera* /var/cache/yum/x86_64/6/cloudera* /var/log/cloudera* /var/run/cloudera* /etc/cloudera* /usr/lib64/cmf8.3移除Cloudera Manager Lock File

在集群中所有节点执行如下命令,删除Cloudera Manager Lock File

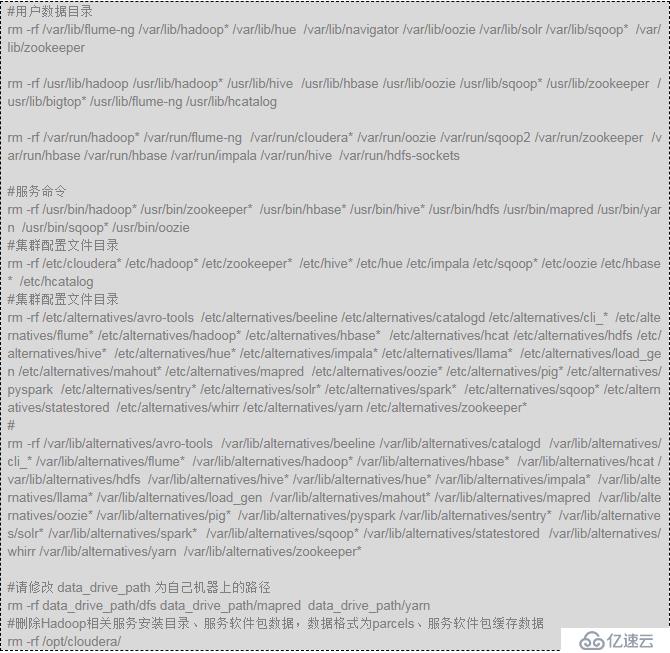

rm –rf /tmp/.scm_prepare_node.lock8.4移除用户数据

此步骤将永久删除所有用户数据。为了备份数据,在启动卸载过程之前,使用distcp命令将其复制到另一个集群中。在集群中所有节点执行如下命令,删除用户所有数据:

8.5停止并移除外部数据库

在安装mysql的服务器上进行操作。

service mysqld stopyum remove mysql*rm –rf /var/lib/mysql9.一键卸载脚本说明(GitHub地址)

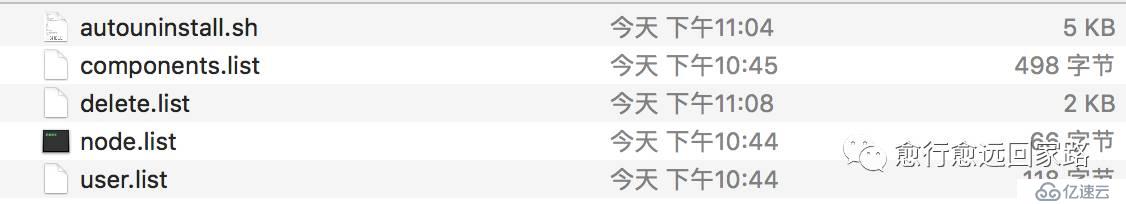

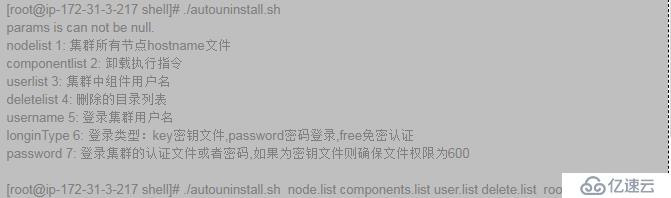

autouninstall.sh:自动卸载脚本

components.list:集群所有安装的组件列表

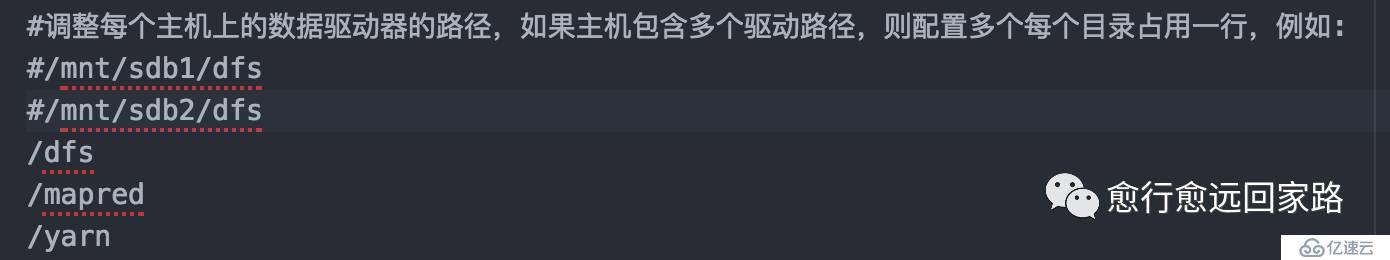

delete.list:需要删除的目录列表,列表中已配置大部分CDH安装默认目录,用户需要对列表末尾的hdfs目录根据自己集群环境进行目录进行相应调整,如下图所示:

node.list:集群所有节点,根据集群环境进行节点配置

user.list:集群所有组件安装时所使用的用户名

注:脚本是在第五步操作完成后,在namenode节点进行一键卸载

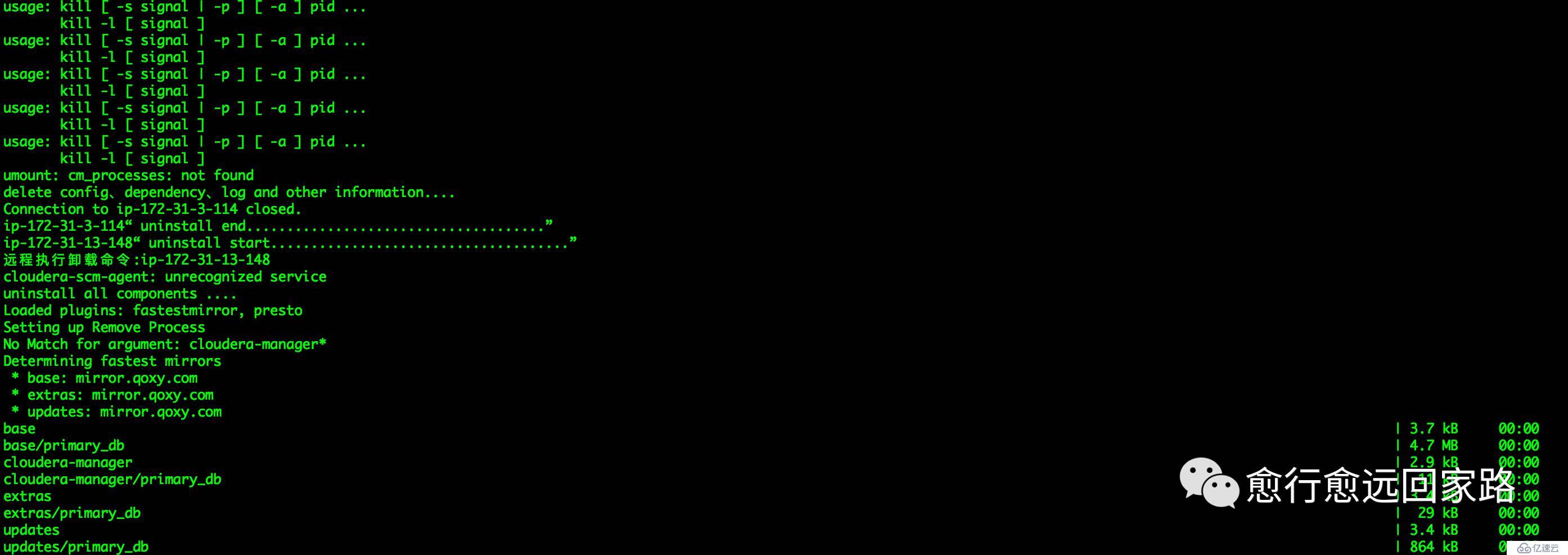

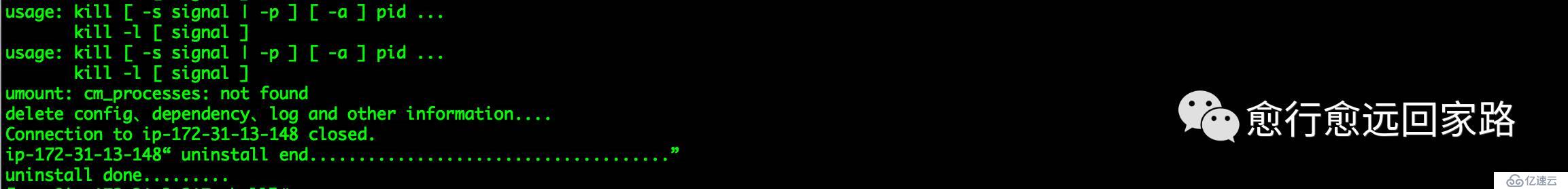

运行截图

源码地址:

https://github.com/javaxsky/cdh-shell

醉酒鞭名马,少年多浮夸! 岭南浣溪沙,呕吐酒肆下!挚友不肯放,数据玩的花!

温馨提示:要看高清无码套图,请使用手机打开并单击图片放大查看。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。