жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

иҝҷзҜҮж–Үз« дё»иҰҒдёәеӨ§е®¶еұ•зӨәдәҶвҖңPythonдёӯpytorchзҘһз»ҸзҪ‘з»ңеӣҫеғҸеҚ·з§Ҝиҝҗз®—зҡ„зӨәдҫӢеҲҶжһҗвҖқпјҢеҶ…е®№з®ҖиҖҢжҳ“жҮӮпјҢжқЎзҗҶжё…жҷ°пјҢеёҢжңӣиғҪеӨҹеё®еҠ©еӨ§е®¶и§ЈеҶіз–‘жғ‘пјҢдёӢйқўи®©е°Ҹзј–еёҰйўҶеӨ§е®¶дёҖиө·з ”究并еӯҰд№ дёҖдёӢвҖңPythonдёӯpytorchзҘһз»ҸзҪ‘з»ңеӣҫеғҸеҚ·з§Ҝиҝҗз®—зҡ„зӨәдҫӢеҲҶжһҗвҖқиҝҷзҜҮж–Үз« еҗ§гҖӮ

дёҘж јжқҘиҜҙпјҢеҚ·з§ҜеұӮжҳҜдёӘй”ҷиҜҜзҡ„еҸ«жі•пјҢеӣ дёәе®ғжүҖиЎЁиҫҫзҡ„иҝҗз®—е…¶е®һжҳҜдә’зӣёе…іиҝҗз®—пјҲcross-correlationпјүпјҢиҖҢдёҚжҳҜеҚ·з§Ҝиҝҗз®—гҖӮеңЁеҚ·з§ҜеұӮдёӯпјҢиҫ“е…Ҙеј йҮҸе’Ңж ёеј йҮҸйҖҡиҝҮдә’зӣёе…іиҝҗз®—дә§з”ҹиҫ“еҮәеј йҮҸгҖӮ

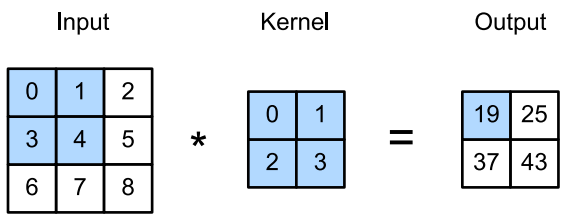

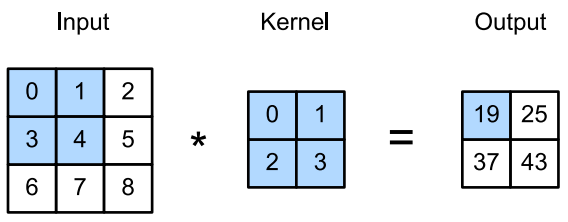

йҰ–е…ҲпјҢжҲ‘们жҡӮж—¶еҝҪз•ҘйҖҡйҒ“пјҲ第дёүз»ҙпјүиҝҷдёҖжғ…еҶөпјҢзңӢзңӢеҰӮдҪ•еӨ„зҗҶдәҢз»ҙеӣҫеғҸж•°жҚ®е’Ңйҡҗи—ҸиЎЁзӨәгҖӮдёӢеӣҫдёӯпјҢиҫ“е…ҘжҳҜй«ҳеәҰдёә3гҖҒе®ҪеәҰдёә3зҡ„дәҢз»ҙеј йҮҸпјҲеҚіеҪўзҠ¶дёә 3 Г— 3 3\times3 3Г—3пјүгҖӮеҚ·з§Ҝж ёзҡ„й«ҳеәҰе’Ңе®ҪеәҰйғҪжҳҜ2гҖӮ

жіЁж„ҸпјҢиҫ“еҮәеӨ§е°Ҹз•Ҙе°ҸдәҺиҫ“е…ҘеӨ§е°ҸгҖӮиҝҷжҳҜеӣ дёәжҲ‘们йңҖиҰҒи¶іеӨҹзҡ„з©әй—ҙеңЁеӣҫеғҸдёҠвҖң移еҠЁвҖқеҚ·з§Ҝж ёгҖӮзЁҚеҗҺпјҢжҲ‘们е°ҶзңӢеҲ°еҰӮдҪ•йҖҡиҝҮеңЁеӣҫеғҸиҫ№з•Ңе‘ЁеӣҙеЎ«е……йӣ¶жқҘдҝқиҜҒжңүи¶іеӨҹзҡ„з©әй—ҙ移еҠЁеҶ…ж ёпјҢд»ҺиҖҢдҝқжҢҒиҫ“еҮәеӨ§е°ҸдёҚеҸҳгҖӮ

def corr2d(X, K): """и®Ўз®—вјҶз»ҙдә’зӣёе…іиҝҗз®—гҖӮ""" h, w = K.shape Y = torch.zeros((X.shape[0] - h + 1, X.shape[1] - w + 1)) for i in range(Y.shape[0]): for j in range(Y.shape[1]): Y[i, j] = (X[i:i + h, j:j + w] * K).sum() return Y

еҚ·з§ҜеұӮеҜ№иҫ“е…Ҙе’ҢеҚ·з§Ҝж ёжқғйҮҚиҝӣиЎҢдә’зӣёе…іиҝҗз®—пјҢ并еңЁж·»еҠ ж ҮйҮҸеҒҸзҪ®д№ӢеҗҺдә§з”ҹиҫ“еҮәгҖӮжүҖд»ҘпјҢеҚ·з§ҜеұӮдёӯзҡ„дёӨдёӘиў«и®ӯз»ғзҡ„еҸӮж•°жҳҜеҚ·з§Ҝж ёжқғйҮҚж ёж ҮйҮҸеҒҸзҪ®гҖӮе°ұеғҸжҲ‘们д№ӢеүҚйҡҸжңәеҲқе§ӢеҢ–е…ЁиҝһжҺҘеұӮдёҖж ·пјҢеңЁи®ӯз»ғеҹәдәҺеҚ·з§ҜеұӮзҡ„жЁЎеһӢж—¶пјҢжҲ‘们д№ҹйҡҸжңәеҲқе§ӢеҢ–еҚ·з§Ҝж ёжқғйҮҚгҖӮ

еҹәдәҺдёҠйқўе®ҡд№үзҡ„corr2dеҮҪж•°е®һзҺ°дәҢз»ҙеҚ·з§ҜеұӮгҖӮеңЁ__init__жһ„йҖ еҮҪж•°дёӯпјҢе°Ҷweightе’ҢbiasеЈ°жҳҺдёәдёӨдёӘжЁЎеһӢеҸӮж•°гҖӮеүҚеҗ‘дј ж’ӯеҮҪж•°и°ғз”Ёcorr2dеҮҪ数并添еҠ еҒҸзҪ®гҖӮ

class Conv2D(nn.Module): def __init__(self, kernel_size): super().__init__() self.weight = nn.Parameter(torch.rand(kernel_size)) self.bias = nn.Parameter(torch.zeros(1)) def forward(self, x): return corr2d(x, self.weight) + self.bias

й«ҳеәҰе’Ңе®ҪеәҰеҲҶеҲ«дёә hе’Ң wзҡ„еҚ·з§Ҝж ёеҸҜд»Ҙиў«з§°дёә h Г— w еҚ·з§ҜжҲ– h Г— w еҚ·з§Ҝж ёгҖӮжҲ‘们д№ҹе°ҶеёҰжңү h Г— w еҚ·з§Ҝж ёзҡ„еҚ·з§ҜеұӮз§°дёә h Г— w еҚ·з§ҜеұӮгҖӮ

дёӢеӣҫдёӯиҫ“еҮәзҡ„еҚ·з§ҜеұӮжңүж—¶иў«з§°дёәзү№еҫҒжҳ е°„пјҲFeature MapпјүпјҢеӣ дёәе®ғеҸҜд»Ҙиў«и§ҶдёәдёҖдёӘиҫ“е…Ҙжҳ е°„еҲ°дёӢдёҖеұӮзҡ„з©әй—ҙз»ҙеәҰзҡ„иҪ¬жҚўеҷЁгҖӮеңЁCNNдёӯпјҢеҜ№дәҺжҹҗдёҖеұӮзҡ„д»»ж„Ҹе…ғзҙ x x xпјҢе…¶ж„ҹеҸ—йҮҺпјҲReceptive FieldпјүжҳҜжҢҮеңЁеүҚеҗ‘дј ж’ӯжңҹй—ҙеҸҜиғҪеҪұе“Қ x x xи®Ўз®—зҡ„жүҖжңүе…ғзҙ пјҲжқҘиҮӘжүҖжңүе…ҲеүҚеұӮпјүгҖӮ

жіЁж„ҸпјҢж„ҹеҸ—йҮҺзҡ„иҰҶзӣ–зҺҮеҸҜиғҪеӨ§дәҺжҹҗеұӮиҫ“е…Ҙзҡ„е®һйҷ…еҢәеҹҹеӨ§е°ҸгҖӮ

дҫӢеҰӮдёҠеӣҫпјҡз»ҷе®ҡ 2 Г— 2 еҚ·з§Ҝж ёпјҢйҳҙеҪұиҫ“еҮәе…ғзҙ еҖј19зҡ„жҺҘ收еҹҹжҳҜйҳҙеҪұйғЁеҲҶзҡ„еӣӣдёӘе…ғзҙ гҖӮеҒҮи®ҫд№ӢеүҚиҫ“еҮәдёә Y пјҢе…¶еӨ§е°Ҹдёә 2 Г— 2 пјҢзҺ°еңЁжҲ‘们еҶҚе…¶еҗҺйҷ„еҠ дёҖдёӘеҚ·з§ҜеұӮпјҢиҜҘеҚ·з§ҜеұӮд»Ҙ Y дёәиҫ“е…ҘпјҢиҫ“еҮәеҚ•дёӘе…ғзҙ zгҖӮеҶҚиҝҷз§Қжғ…еҶөдёӢпјҢ YдёҠзҡ„ zзҡ„жҺҘ收еӯ—ж®өеҢ…жӢ¬ Y зҡ„жүҖжңүеӣӣдёӘе…ғзҙ пјҢиҖҢиҫ“е…Ҙзҡ„ж„ҹеҸ—йҮҺеҢ…жӢ¬жңҖеҲқжүҖжңүд№қдёӘиҫ“е…Ҙе…ғзҙ гҖӮ

еӣ жӯӨпјҢеҪ“дёҖдёӘзү№еҫҒеӣҫдёӯзҡ„д»»ж„Ҹе…ғзҙ йңҖиҰҒжЈҖжөӢжӣҙе№ҝеҢәеҹҹзҡ„иҫ“е…Ҙзү№еҫҒж—¶пјҢжҲ‘们еҸҜд»Ҙжһ„е»әдёҖдёӘжӣҙж·ұзҡ„зҪ‘з»ңгҖӮ

д»ҘдёҠжҳҜвҖңPythonдёӯpytorchзҘһз»ҸзҪ‘з»ңеӣҫеғҸеҚ·з§Ҝиҝҗз®—зҡ„зӨәдҫӢеҲҶжһҗвҖқиҝҷзҜҮж–Үз« зҡ„жүҖжңүеҶ…е®№пјҢж„ҹи°ўеҗ„дҪҚзҡ„йҳ…иҜ»пјҒзӣёдҝЎеӨ§е®¶йғҪжңүдәҶдёҖе®ҡзҡ„дәҶи§ЈпјҢеёҢжңӣеҲҶдә«зҡ„еҶ…е®№еҜ№еӨ§е®¶жңүжүҖеё®еҠ©пјҢеҰӮжһңиҝҳжғіеӯҰд№ жӣҙеӨҡзҹҘиҜҶпјҢж¬ўиҝҺе…іжіЁдәҝйҖҹдә‘иЎҢдёҡиө„и®Ҝйў‘йҒ“пјҒ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ