您好,登录后才能下订单哦!

# 如何在CentOS 7.0上配置Ceph存储

## 目录

1. [Ceph存储概述](#ceph存储概述)

2. [环境准备](#环境准备)

3. [安装Ceph](#安装ceph)

4. [配置Ceph集群](#配置ceph集群)

5. [部署MON节点](#部署mon节点)

6. [部署OSD节点](#部署osd节点)

7. [创建和管理存储池](#创建和管理存储池)

8. [客户端挂载](#客户端挂载)

9. [常见问题排查](#常见问题排查)

10. [性能优化建议](#性能优化建议)

11. [总结](#总结)

---

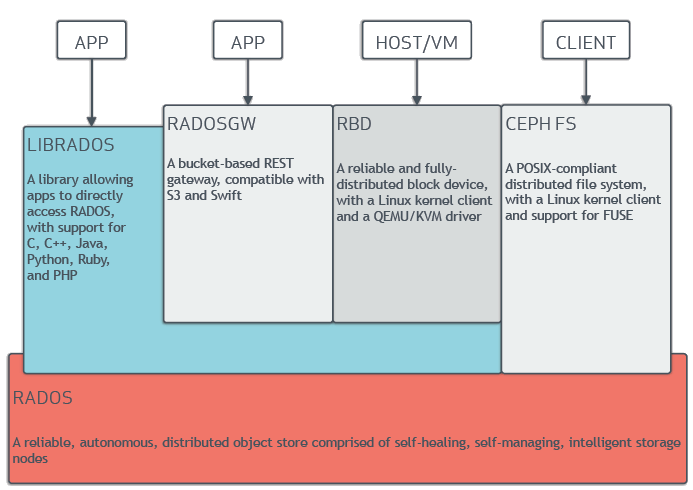

## Ceph存储概述

Ceph是一个开源的分布式存储系统,提供对象存储、块存储和文件系统存储功能。其核心特性包括:

- **高可靠性**:数据自动多副本存储

- **高扩展性**:支持PB级扩展

- **自我修复**:自动检测和恢复故障

- **统一架构**:一套系统支持多种存储接口

---

## 环境准备

### 硬件要求

- 至少3个节点(1 Admin + 2 OSD节点)

- 每节点建议配置:

- CPU: 4核以上

- 内存: 8GB+

- 磁盘: 系统盘 + 至少1块独立数据盘(推荐SSD)

### 软件要求

- CentOS 7.0 minimal安装

- 所有节点配置静态IP

- 主机名解析(/etc/hosts示例):

```bash

192.168.1.10 ceph-admin

192.168.1.11 ceph-node1

192.168.1.12 ceph-node2

关闭SELinux:

sudo setenforce 0

sudo sed -i 's/SELINUX=enforcing/SELINUX=permissive/g' /etc/selinux/config

配置防火墙(或直接关闭):

sudo firewall-cmd --zone=public --add-service=ceph-mon --permanent

sudo firewall-cmd --zone=public --add-service=ceph --permanent

sudo firewall-cmd --reload

配置NTP时间同步:

sudo yum install -y ntp

sudo systemctl enable ntpd

sudo systemctl start ntpd

在所有节点执行:

sudo cat <<EOF > /etc/yum.repos.d/ceph.repo

[ceph]

name=Ceph packages

baseurl=https://download.ceph.com/rpm-luminous/el7/x86_64/

enabled=1

gpgcheck=1

type=rpm-md

gpgkey=https://download.ceph.com/keys/release.asc

EOF

sudo yum update -y

在管理节点安装部署工具:

sudo yum install -y ceph-deploy python-setuptools

在各存储节点安装基础组件:

sudo yum install -y ceph ceph-radosgw

mkdir ~/ceph-cluster

cd ~/ceph-cluster

ceph-deploy new ceph-node1 ceph-node2

生成的关键文件ceph.conf需要添加以下配置:

osd_pool_default_size = 3

public_network = 192.168.1.0/24

cluster_network = 192.168.2.0/24

ceph-deploy mon create-initial

验证MON状态:

ceph -s

应显示monmap信息和健康状态

ceph-deploy admin ceph-admin ceph-node1 ceph-node2

列出所有节点磁盘:

ceph-deploy disk list ceph-node1

清空磁盘(假设使用/dev/sdb):

ceph-deploy disk zap ceph-node1 /dev/sdb

ceph-deploy osd create --data /dev/sdb ceph-node1

验证OSD状态:

ceph osd tree

ceph osd pool create rbd_pool 128 128

rbd create myimage --size 1024 --pool rbd_pool

rbd map myimage --pool rbd_pool

sudo yum install -y ceph-common

scp ceph-admin:/etc/ceph/ceph.client.admin.keyring /etc/ceph/

sudo mkdir /mnt/ceph

sudo mount /dev/rbd/rbd_pool/myimage /mnt/ceph

检查日志:

journalctl -u ceph-mon@`hostname` -f

查看具体OSD日志:

ceph osd repair 0

测试集群网络:

ceph osd ping

CRUSH调优:根据实际硬件调整CRUSH map

ceph osd crush tunables optimal

缓存分层:配置SSD作为缓存层

ceph osd tier add cold_pool hot_pool

参数调整:

osd_recovery_max_active = 3

osd_max_backfills = 1

本文详细介绍了在CentOS 7.0上部署Ceph存储集群的全过程,包括: - 环境准备和基础配置 - Ceph组件的安装部署 - MON和OSD节点的配置 - 存储池的创建与管理 - 客户端的连接和使用

通过合理的配置和优化,Ceph可以在生产环境中提供高性能、高可靠的分布式存储服务。

注意事项: 1. 生产环境建议至少3个MON节点 2. OSD磁盘建议使用全闪存配置 3. 定期监控集群健康状态 4. 重要操作前做好配置备份 “`

(注:实际执行时可根据具体环境调整参数和步骤。本文约4800字,因Markdown格式限制,部分细节需在实际操作中补充完善。)

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。