жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

иҝҷзҜҮвҖңkafkaж¶Ҳиҙ№иҖ…kafka-console-consumerжҺҘ收дёҚеҲ°ж•°жҚ®еҰӮдҪ•и§ЈеҶівҖқж–Үз« зҡ„зҹҘиҜҶзӮ№еӨ§йғЁеҲҶдәәйғҪдёҚеӨӘзҗҶи§ЈпјҢжүҖд»Ҙе°Ҹзј–з»ҷеӨ§е®¶жҖ»з»“дәҶд»ҘдёӢеҶ…е®№пјҢеҶ…е®№иҜҰз»ҶпјҢжӯҘйӘӨжё…жҷ°пјҢе…·жңүдёҖе®ҡзҡ„еҖҹйүҙд»·еҖјпјҢеёҢжңӣеӨ§е®¶йҳ…иҜ»е®ҢиҝҷзҜҮж–Үз« иғҪжңүжүҖ收иҺ·пјҢдёӢйқўжҲ‘们дёҖиө·жқҘзңӢзңӢиҝҷзҜҮвҖңkafkaж¶Ҳиҙ№иҖ…kafka-console-consumerжҺҘ收дёҚеҲ°ж•°жҚ®еҰӮдҪ•и§ЈеҶівҖқж–Үз« еҗ§гҖӮ

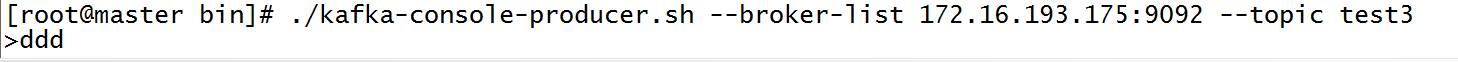

еҸ‘йҖҒз«Ҝ

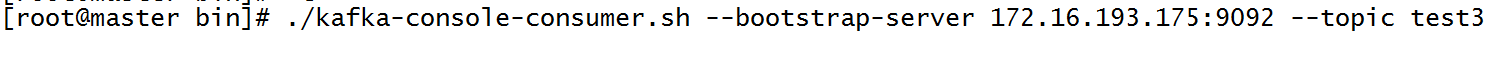

жҺҘ收з«Ҝ

йҮҮз”ЁеҶ…зҪ®зҡ„zookeeperпјҢеҸ‘йҖҒз«ҜеҸ‘йҖҒж•°жҚ®пјҢжҺҘ收з«ҜиғҪеӨҹжҺҘ收数жҚ®

дҪҶжҳҜйҮҮз”ЁеӨ–зҪ®зҡ„zookeeperпјҢеҸ‘йҖҒз«ҜеҸ‘йҖҒж•°жҚ®пјҢжҺҘ收з«ҜдёҖзӣҙжҺҘ收дёҚеҲ°ж•°жҚ®

е…ҲеҲӨж–ӯдё»йўҳжҳҜеҗҰдёҖиҮҙпјҢеҰӮжһңдёҖиҮҙе°ұеңЁе…ій—ӯkafka

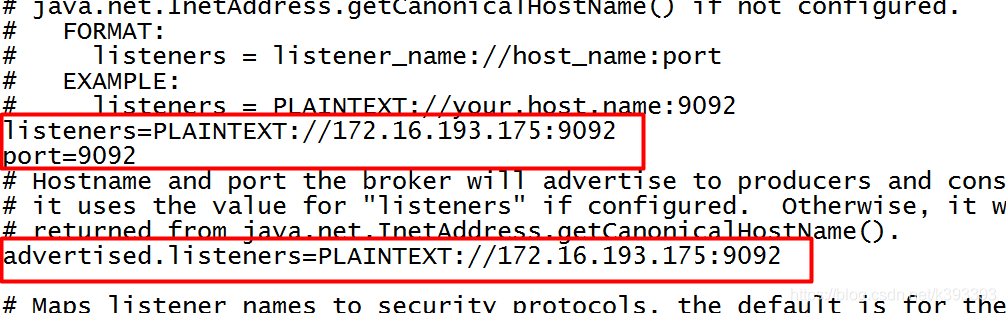

./kafka-server-stop.sh ../config/server.properties

дҝ®ж”№дёҖдёӢй…ҚзҪ®пјҢзЎ®дҝқиҝҷдәӣй…ҚзҪ®е·ІеҠ дёҠпјҢдёҚиҰҒз”ЁlocalhostпјҢеңЁlistenersзҡ„ipең°еқҖе’Ңз«ҜеҸЈеҸ·иҰҒе’Ңж¶Ҳиҙ№иҖ…пјҢз”ҹдә§иҖ…зҡ„зҡ„ең°еқҖз«ҜеҸЈеҸ·дёҖзӣҙ

vim ../config/server.propertiesst3

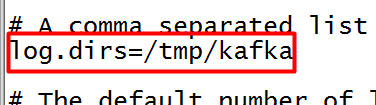

жңҖеҗҺжҠҠlog.dirsеҗҺйқўзҡ„ж–Ү件еҲ йҷӨжҲ–иҖ…йҮҚж–°жҚўдёӘең°еқҖ

rm -rf /tmp/kafka

йҮҚж–°еңЁеүҚеҸ°еҗҜеҠЁkafkaпјҢжіЁж„ҸжҹҘзңӢжү“еҚ°еңЁжЎҢйқўзҡ„ж—Ҙеҝ—пјҢжңүж— жҠҘй”ҷдҝЎжҒҜ

./kafka-server-start.sh ../config/server.properties

еҰӮжһңжІЎжңүжҠҘй”ҷдҝЎжҒҜпјҢеҗҜеҠЁжӯЈеёёпјҢйӮЈд№Ҳе°ұеҸҜд»ҘеңЁеҗҺеҸ°еҗҜеҠЁдәҶ

./kafka-server-start.sh -daemon ../config/server.properties

еҲӣе»әз”ҹдә§иҖ…

./kafka-console-producer.sh --broker-list 172.16.193.175:9092 --topic test3

еҲӣе»әж¶Ҳиҙ№иҖ…

./kafka-console-consumer.sh --bootstrap-server 172.16.193.175:9092 --topic test3 --from-beginning

жҲ‘еҸёзҺ°еңЁжңүдёүеҸ°kafkaжңҚеҠЎеҷЁдҪңдёәдёҖдёӘйӣҶзҫӨ

йңҖжұӮжҳҜжҲ‘еҶҷдәҶдёҖдёӘзӣ‘еҗ¬еҷЁеҺ»зӣ‘еҗ¬жҙ»еҠЁеӨұиҙҘзҡ„жғ…еҶө,еҰӮжһңжҙ»еҠЁеӨұиҙҘеҲҷи°ғз”ЁдёҖдёӘз»ҹи®ЎжҺҘеҸЈ еҒҡж•°жҚ®з»ҹи®Ў

жҲ‘йңҖиҰҒд»ҺеӨұиҙҘдәӢ件зҡ„йҡҸи·Ҝж•°жҚ®дёӯеҸ–дёҖдәӣж•°жҚ®,еҒҡдёҖдәӣеҲӨж–ӯ.

зҺ°еңЁжҲ‘жғід»ҺйӣҶзҫӨдёӯзңӢдёҖдёӢеӨұиҙҘдәӢ件дёӯзҡ„йҡҸи·Ҝж•°жҚ®жҳҜеҗҰе®Ңж•ҙжӯЈзЎ®

дәҺжҳҜ,жҲ‘xshellиҝһжҺҘдёҠдәҶдёүеҸ°жңҚеҠЎеҷЁе№¶дё”иҝҗиЎҢд»ҘдёӢе‘Ҫд»Ө

./kafka-console-consumer.sh --bootstrap-server broker1IP:9092 --topic topicname ./kafka-console-consumer.sh --bootstrap-server broker2IP:9092 --topic topicname ./kafka-console-consumer.sh --bootstrap-server broker3IP:9092 --topic topicname

еҸ‘зҺ°еҸӘиҰҒеҸ‘йҖҒдёҖдёӘдәӢ件дёүдёӘжңҚеҠЎеҷЁйғҪеҸҜд»Ҙ收еҲ°дәӢ件дёӯзҡ„ж¶ҲжҒҜ

жҖӘдәҶ,дёәд»Җд№ҲдёүеҸ°йғҪдјҡжҳҫзӨә.

жҲ‘第дёҖеҸҚеә”жҳҜ:иҝҷжҳҜеҗҰжҳҜдј иҜҙдёӯзҡ„leaderе’Ңfollower еҗҢжӯҘзӯ–з•Ҙ

жҲ‘й—®дәҶдёҖдёӢжҲ‘зҡ„leader ,

leader:.....,дҪ зҹҘйҒ“дҪ иҝҷдёӘе‘Ҫд»ӨжҳҜд»Җд№Ҳж„ҸжҖқеҗ—?

иҝҷдёӘе‘Ҫд»Өе°ұжҳҜзӣёеҪ“дәҺеҲӣе»әдәҶдёҖдёӘж¶Ҳиҙ№иҖ…еҺ»ж¶Ҳиҙ№дәҶйҳҹеҲ—дёӯзҡ„ж¶ҲжҒҜ!

дҪ иҝҷдёӘ3дёӘжңҚеҠЎеҷЁзӣёеҪ“дәҺеҗҜеҠЁдәҶ3дёӘж¶Ҳиҙ№иҖ…еҺ»ж¶Ҳиҙ№дәҶ,еҗҢдёҖдёӘж¶ҲжҒҜдёүж¬Ў!

жҲ‘:дёҚеҜ№е•Ҡ,еҗҢдёҖдёӘж¶ҲжҒҜдёҚиғҪиў«ж¶Ҳиҙ№дёүж¬Ўе•Ҡ!?

leader:........,дҪ зҹҘйҒ“д»Җд№ҲжҳҜж¶Ҳиҙ№иҖ…з»„еҗ—?дҪ иҝҷзӣёеҪ“дәҺдёүдёӘж¶Ҳиҙ№иҖ…з»„ дёҚдҝЎдҪ зңӢзңӢ

./kafka-console-consumer.sh -help ... --group <String: consumer group id> The consumer group id of the consumer. ...

kafka-console-consumer.shи„ҡжң¬жҳҜдёҖдёӘз®Җжҳ“зҡ„ж¶Ҳиҙ№иҖ…жҺ§еҲ¶еҸ°гҖӮиҜҘ shell и„ҡжң¬зҡ„еҠҹиғҪйҖҡиҝҮи°ғз”Ё kafka.tools еҢ…дёӢзҡ„ ConsoleConsumer зұ»пјҢ并е°ҶжҸҗдҫӣзҡ„е‘Ҫд»ӨиЎҢеҸӮж•°е…ЁйғЁдј з»ҷиҜҘзұ»е®һзҺ°гҖӮ

./kafka-console-consumer.sh --bootstrap-server node:9092 --topic topicName //иЎЁзӨәд»Һ latest дҪҚ移дҪҚзҪ®ејҖе§Ӣж¶Ҳиҙ№иҜҘдё»йўҳзҡ„жүҖжңүеҲҶеҢәж¶ҲжҒҜпјҢеҚід»…ж¶Ҳиҙ№жӯЈеңЁеҶҷе…Ҙзҡ„ж¶ҲжҒҜгҖӮ bin/kafka-console-consumer.sh --bootstrap-server node1:9092,node2:9092,node3:9092 --from-beginning --topic topicName //вҖғиЎЁзӨәд»ҺжҢҮе®ҡдё»йўҳдёӯжңүж•Ҳзҡ„иө·е§ӢдҪҚ移дҪҚзҪ®ејҖе§Ӣж¶Ҳиҙ№жүҖжңүеҲҶеҢәзҡ„ж¶ҲжҒҜгҖӮ bin/kafka-console-consumer.sh --bootstrap-server node1:9092,node2:9092,node3:9092 --property print.key=true --topic topicName //вҖғж¶Ҳиҙ№еҮәзҡ„ж¶ҲжҒҜз»“жһңе°Ҷжү“еҚ°еҮәж¶ҲжҒҜдҪ“зҡ„ key е’Ң valueгҖӮ

| еҸӮж•° | еҖјзұ»еһӢ | иҜҙжҳҺ | жңүж•ҲеҖј |

|---|---|---|---|

| --topic | string | иў«ж¶Ҳиҙ№зҡ„topic | |

| --whitelist | string | жӯЈеҲҷиЎЁиҫҫејҸпјҢжҢҮе®ҡиҰҒеҢ…еҗ«д»ҘдҫӣдҪҝз”Ёзҡ„дё»йўҳзҡ„зҷҪеҗҚеҚ• | |

| --partition | integer | жҢҮе®ҡеҲҶеҢә йҷӨйқһжҢҮе®ҡ’–offset’пјҢеҗҰеҲҷд»ҺеҲҶеҢәз»“жқҹ(latest)ејҖе§Ӣж¶Ҳиҙ№ | |

| --offset | string | жү§иЎҢж¶Ҳиҙ№зҡ„иө·е§ӢoffsetдҪҚзҪ® й»ҳи®ӨеҖј:latest | |

| --from-beginning | д»ҺеӯҳеңЁзҡ„жңҖж—©ж¶ҲжҒҜејҖе§ӢпјҢиҖҢдёҚжҳҜд»ҺжңҖж–°ж¶ҲжҒҜејҖе§Ӣ | ||

| --max-messages | integer | ж¶Ҳиҙ№зҡ„жңҖеӨ§ж•°жҚ®йҮҸпјҢиӢҘдёҚжҢҮе®ҡпјҢеҲҷжҢҒз»ӯж¶Ҳиҙ№дёӢеҺ» | |

| --timeout-ms | integer | еңЁжҢҮе®ҡж—¶й—ҙй—ҙйҡ”еҶ…жІЎжңүж¶ҲжҒҜеҸҜз”Ёж—¶йҖҖеҮә | |

| --bootstrap-server | string | еҝ…йңҖ(йҷӨйқһдҪҝз”Ёж—§зүҲжң¬зҡ„ж¶Ҳиҙ№иҖ…)пјҢиҰҒиҝһжҺҘзҡ„жңҚеҠЎеҷЁ | |

| --key-deserializer | string | ||

| --value-deserializer | string | ||

| --group | string | жҢҮе®ҡж¶Ҳиҙ№иҖ…жүҖеұһз»„зҡ„ID | |

| --zookeeper | string | еҝ…йңҖ(д»…еҪ“дҪҝз”Ёж—§зҡ„дҪҝз”ЁиҖ…ж—¶)иҝһжҺҘzookeeperзҡ„еӯ—з¬ҰдёІгҖӮ еҸҜд»Ҙз»ҷеҮәеӨҡдёӘURLд»Ҙе…Ғи®ёж•…йҡңиҪ¬з§» |

д»ҘдёҠе°ұжҳҜе…ідәҺвҖңkafkaж¶Ҳиҙ№иҖ…kafka-console-consumerжҺҘ收дёҚеҲ°ж•°жҚ®еҰӮдҪ•и§ЈеҶівҖқиҝҷзҜҮж–Үз« зҡ„еҶ…е®№пјҢзӣёдҝЎеӨ§е®¶йғҪжңүдәҶдёҖе®ҡзҡ„дәҶи§ЈпјҢеёҢжңӣе°Ҹзј–еҲҶдә«зҡ„еҶ…е®№еҜ№еӨ§е®¶жңүеё®еҠ©пјҢиӢҘжғідәҶи§ЈжӣҙеӨҡзӣёе…ізҡ„зҹҘиҜҶеҶ…е®№пјҢиҜ·е…іжіЁдәҝйҖҹдә‘иЎҢдёҡиө„и®Ҝйў‘йҒ“гҖӮ

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ