жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ

з®ҖеҸІ

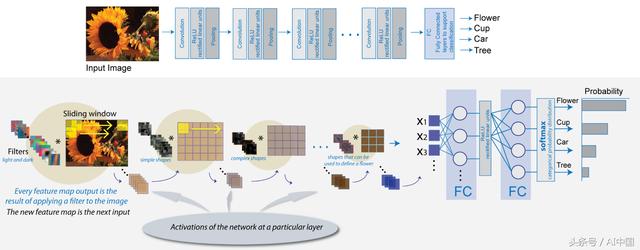

еҚ·з§ҜзҘһз»ҸзҪ‘з»ң

еңЁиҝҮеҺ»зҡ„еҚҒе№ҙйҮҢпјҢи®Ўз®—жңәи§Ҷи§үйўҶеҹҹеҸ–еҫ—зҡ„иҝӣжӯҘжҳҜеүҚжүҖжңӘжңүзҡ„гҖӮжңәеҷЁзҺ°еңЁеҸҜд»ҘиҜҶеҲ«и§Ҷйў‘дёӯзҡ„еӣҫеғҸжҲ–жҹҗдёҖеё§пјҢеҮҶзЎ®зҺҮ(98%)и¶…иҝҮдәәзұ»(97%)гҖӮд№ӢжүҖд»Ҙжңүиҝҷд№ҲеӨ§зҡ„зӘҒз ҙпјҢе°ұжҳҜеҫ—зӣҠдәҺеҜ№дәәи„‘зҡ„з ”з©¶гҖӮ

еҪ“ж—¶пјҢзҘһз»ҸеӯҰ家жӯЈеңЁеҜ№зҢ«иҝӣиЎҢе®һйӘҢпјҢ他们еҸ‘зҺ°еӣҫеғҸдёӯзӣёдјјзҡ„йғЁеҲҶдјҡеҜјиҮҙзҢ«еӨ§и„‘дёӯзӣёдјјзҡ„йғЁеҲҶеҸҳеҫ—жҙ»и·ғгҖӮжҚўеҸҘиҜқиҜҙпјҢеҪ“дёҖеҸӘзҢ«зңӢзқҖеңҶеңҲж—¶пјҢеӨ§и„‘дёӯзҡ„Оұе°ұиў«жҝҖжҙ»дәҶгҖӮеҪ“е®ғи§ӮеҜҹжӯЈж–№еҪўж—¶пјҢеӨ§и„‘дёӯзҡ„ОІеҢәиў«жҝҖжҙ»гҖӮ他们зҡ„еҸ‘зҺ°еҫ—еҮәз»“и®әпјҢеҠЁзү©зҡ„еӨ§и„‘еҢ…еҗ«дёҖдёӘзҘһз»Ҹе…ғеҢәпјҢиҜҘеҢәеҹҹеҜ№еӣҫеғҸзҡ„зү№е®ҡзү№еҫҒдҪңеҮәеҸҚеә”пјҢеҚіе®ғ们йҖҡиҝҮеӨ§и„‘дёӯзҘһз»Ҹе…ғзҡ„еҲҶеұӮз»“жһ„жқҘж„ҹзҹҘзҺҜеўғгҖӮжҜҸдёҖе№…еӣҫеғҸеңЁж·ұе…ҘеӨ§и„‘д№ӢеүҚйғҪиҰҒз»ҸиҝҮжҹҗз§Қзү№еҫҒжҸҗеҸ–еҷЁгҖӮ

еҸ—еӨ§и„‘еҠҹиғҪзҡ„еҗҜеҸ‘пјҢж•°еӯҰ家们иҒҡйӣҶеңЁдёҖиө·пјҢеҲӣе»әдёҖдёӘзі»з»ҹжқҘжЁЎжӢҹдёҚеҗҢзҘһз»Ҹе…ғзҫӨеҜ№дёҚеҗҢеӣҫеғҸзҡ„ж„ҹзҹҘпјҢ并зӣёдә’дәӨжөҒд»ҘеҪўжҲҗжӣҙеӨ§зҡ„еӣҫеғҸгҖӮ

зү№еҫҒжҸҗеҸ–еҷЁ

他们е°ҶзҘһз»Ҹе…ғзҫӨиў«жҝҖжҙ»зҡ„жғіжі•е…·дҪ“еҢ–дёәеӨҡз»ҙзҹ©йҳөиЎЁзӨәзү№е®ҡзү№еҫҒйӣҶзҡ„жЈҖжөӢеҷЁзҡ„ж•°еӯҰжҰӮеҝөпјҢ并жҸҗдҫӣдәҶзү№е®ҡзҡ„иҫ“е…ҘгҖӮе…¶дёӯпјҢд»ЈиЎЁзү№е®ҡзү№еҫҒзҡ„жҺўжөӢеҷЁпјҢеҸҲиў«з§°дёәж»ӨжіўеҷЁжҲ–ж ёгҖӮжҜҸдёҖдёӘиҝҷж ·зҡ„ж»ӨжіўеҷЁйғҪе°Ҷз”ЁдәҺжЈҖжөӢеӣҫеғҸдёӯзү№е®ҡзҡ„дёңиҘҝпјҢдҫӢеҰӮз”ЁдәҺжЈҖжөӢиҫ№зјҳзҡ„ж»ӨжіўеҷЁгҖӮиҝҷдәӣеӯҰд№ еҲ°зҡ„зү№жҖ§е°ҶйҖҡиҝҮеҸҰдёҖз»„иҝҮж»ӨеҷЁиў«дј йҖ’пјҢиҝҷдәӣиҝҮж»ӨеҷЁиў«и®ҫи®Ўз”ЁжқҘжЈҖжөӢжӣҙй«ҳзә§еҲ«зҡ„зү№жҖ§пјҢдҫӢеҰӮзңјзқӣгҖҒйј»еӯҗзӯүгҖӮ

з”ЁLaplacianж»ӨжіўеҷЁеҚ·з§ҜеӣҫеғҸжЈҖжөӢиҫ№зјҳ

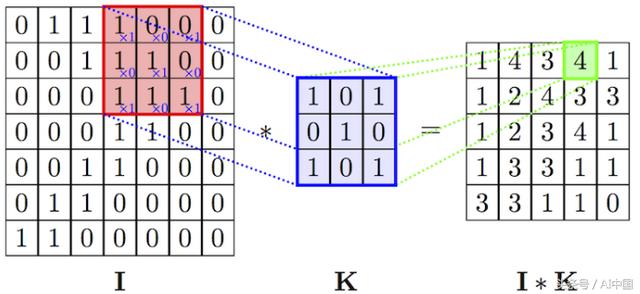

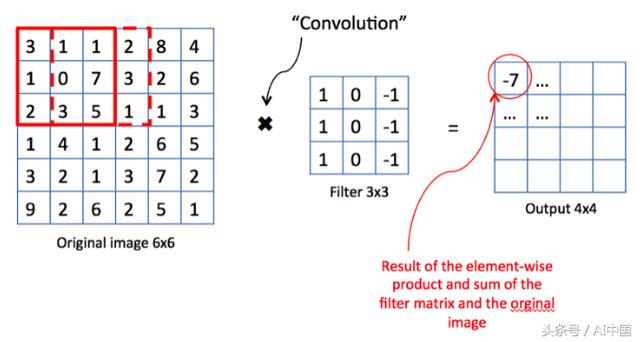

д»Һж•°еӯҰдёҠи®ІпјҢжҲ‘们е°ҶеҜ№з»ҷе®ҡзҡ„иҫ“е…ҘеӣҫеғҸ(д»ҘеғҸзҙ ејәеәҰзҹ©йҳөиЎЁзӨә)е’Ңж»ӨжіўеҷЁиҝӣиЎҢеҚ·з§Ҝиҝҗз®—пјҢз”ҹжҲҗжүҖи°“зҡ„зү№еҫҒеӣҫгҖӮиҝҷдёӘзү№еҫҒжҳ е°„е°ҶдҪңдёәеҸҰдёҖеұӮиҝҮж»ӨеҷЁзҡ„иҫ“е…ҘгҖӮ

дёәд»Җд№ҲжҳҜеҚ·з§Ҝ?

еҚ·з§ҜжҳҜдёҖдёӘзҪ‘з»ңиҜ•еӣҫйҖҡиҝҮеҸӮиҖғиҝҮеҺ»жүҖеӯҰзҡ„еҶ…е®№жқҘж Үи®°иҫ“е…ҘдҝЎеҸ·зҡ„иҝҮзЁӢгҖӮеҰӮжһңиҫ“е…ҘдҝЎеҸ·дёҺд№ӢеүҚзңӢеҲ°зҡ„зҢ«зҡ„еӣҫеғҸзұ»дјјпјҢйӮЈд№Ҳ"зҢ«"дҪңдёәеҸӮиҖғдҝЎеҸ·е°ҶдёҺиҫ“е…ҘдҝЎеҸ·иҝӣиЎҢеҚ·з§ҜжҲ–ж··еҗҲгҖӮ然еҗҺе°Ҷиҫ“еҮәдҝЎеҸ·дј йҖ’еҲ°дёӢдёҖеұӮ(иҝҷйҮҢпјҢиҫ“е…ҘдҝЎеҸ·жҳҜд»ҘRGBеғҸзҙ ејәеәҰиЎЁзӨәиҫ“е…ҘеӣҫеғҸзҡ„дёүз»ҙиЎЁзӨәпјҢиҖҢ"зҢ«"дҪңдёәеҸӮиҖғдҝЎеҸ·жҳҜиҜҶеҲ«зҢ«зұ»зҡ„ж ёеҝғ)гҖӮ

еӣҫеғҸдёҺж»ӨжіўеҷЁзҡ„еҚ·з§Ҝиҝҗз®—

еҚ·з§Ҝиҝҗз®—зҡ„дёҖдёӘеҫҲеҘҪзҡ„жҖ§иҙЁжҳҜе®ғдёҚдјҡиҪ»жҳ“еҸ‘з”ҹж”№еҸҳгҖӮиҝҷж„Ҹе‘ізқҖжҜҸдёӘеҚ·з§Ҝж»ӨжіўеҷЁйғҪд»ЈиЎЁдәҶзү№е®ҡзҡ„зү№еҫҒйӣҶгҖӮдҫӢеҰӮзңјзқӣпјҢиҖіжңөзӯүгҖӮCNNз®—жі•еҜ№зү№еҫҒйӣҶзҡ„еӯҰд№ жһ„жҲҗзҡ„еҸӮиҖғз»“жһңпјҢдҫӢеҰӮзҢ«гҖӮйңҖиҰҒиЎҘе……зҡ„жҳҜпјҢиҫ“еҮәдҝЎеҸ·зҡ„ејәеәҰ并дёҚеҸ–еҶідәҺзү№еҫҒзҡ„дҪҚзҪ®пјҢиҖҢд»…д»…еҸ–еҶідәҺзү№еҫҒжҳҜеҗҰеӯҳеңЁгҖӮеӣ жӯӨпјҢзҢ«еҸҜд»ҘеқҗеңЁдёҚеҗҢзҡ„дҪҚзҪ®пјҢиҖҢCNNз®—жі•д»Қ然иғҪеӨҹиҜҶеҲ«е®ғгҖӮ

жұ

йҖҡиҝҮиҝҪиёӘеӨ§и„‘зҡ„з”ҹзү©еҠҹиғҪжүҖеҪўжҲҗзҡ„иҪЁиҝ№пјҢжҲ‘们иғҪеӨҹе»әз«ӢеҮәзү№еҫҒжҸҗеҸ–жүҖйңҖзҡ„ж•°еӯҰд»ӘеҷЁгҖӮ然иҖҢпјҢеңЁдәҶи§ЈеҲ°иҰҒи·ҹиёӘзҡ„еҮ дҪ•еҪўзҠ¶еӨҚжқӮжҖ§пјҢд»ҘеҸҠйңҖиҰҒеҲҶжһҗзҡ„еұӮж¬Ўе’Ңзү№еҫҒзҡ„жҖ»ж•°д№ӢеҗҺпјҢжҲ‘们дјҡж„ҸиҜҶеҲ°жҲ‘们没жңүи¶іеӨҹзҡ„еҶ…еӯҳжқҘдҝқеӯҳжүҖжңүзҡ„ж•°жҚ®гҖӮеҚідҪҝжҳҜеӨ„зҗҶиҝҷдёҖеҲҮжүҖйңҖзҡ„и®Ўз®—иғҪеҠӣд№ҹдјҡйҡҸзқҖзү№жҖ§зҡ„ж•°йҮҸе‘ҲжҢҮж•°зә§еўһй•ҝгҖӮеҫҲеҝ«пјҢжҲ‘们е°ұдёҚеҫ—дёҚжұӮеҠ©дәҺдёҖз§Қиў«з§°дёә"жұ "зҡ„жҠҖжңҜжқҘи§ЈеҶіеҪ“еүҚжҲ‘们зҡ„еӣ°еўғгҖӮе®ғзҡ„ж ёеҝғжҖқжғіеҫҲз®ҖеҚ•гҖӮ

еҰӮжһңдёҖдёӘеҢәеҹҹеҢ…еҗ«дёҖдёӘжһҒе…·д»ЈиЎЁжҖ§зҡ„зү№жҖ§пјҢжҲ‘们еҸҜд»ҘйҒҝе…ҚеңЁиҜҘеҢәеҹҹдёӯжҗңзҙўе…¶д»–зү№жҖ§гҖӮ

жңҖеӨ§жұ зҡ„жј”зӨә

иҝҷж ·еҒҡпјҢйҷӨдәҶиҠӮзңҒдёҚеҝ…иҰҒзҡ„еҶ…еӯҳ并иҠӮзңҒи®Ўз®—иғҪеҠӣеӨ–пјҢиҝҳжңүеҠ©дәҺж¶ҲйҷӨеӣҫеғҸдёӯзҡ„еҷӘеЈ°гҖӮ

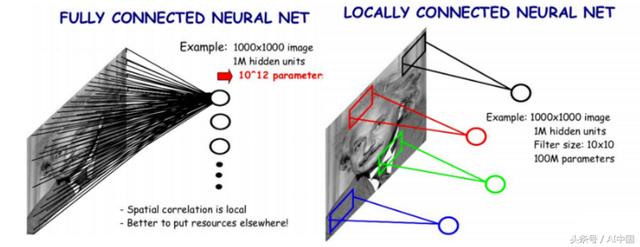

е…ЁиҝһжҺҘеұӮ

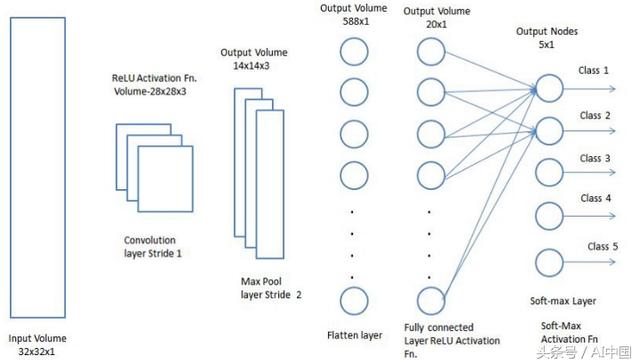

еҲ°зӣ®еүҚдёәжӯўжҲ‘们еҒҡзҡ„иҝҳдёҚй”ҷпјҢдҪҶжҳҜеҰӮжһңзҪ‘з»ңжңҖз»ҲеҸӘжЈҖжөӢеҲ°еӣҫеғҸдёӯзҡ„дёҖз»„зү№еҫҒпјҢйӮЈд№Ҳе®ғжңүд»Җд№Ҳз”Ёе‘ў?жҲ‘们йңҖиҰҒдёҖз§Қж–№жі•пјҢдҪҝзҪ‘з»ңиғҪеӨҹе°Ҷз»ҷе®ҡзҡ„еӣҫеғҸиҝӣиЎҢеҲҶзұ»гҖӮиҝҷе°ұжҳҜеҜ№дј з»ҹзҘһз»ҸзҪ‘з»ңзҡ„дёҖз§Қеә”з”ЁгҖӮзү№еҲ«жҳҜпјҢжҲ‘们еҸҜд»ҘжңүдёҖдёӘе…ЁиҝһжҺҘеұӮпјҢд»Һе…ҲеүҚзҡ„еӣҫеұӮжүҖжЈҖжөӢеҲ°зҡ„зү№еҫҒжҳ е°„еҲ°жҲ‘们жүҖжӢҘжңүзҡ„еҲҶзұ»ж Үзӯҫзҡ„ж•°йҮҸгҖӮжңҖеҗҺдёҖеұӮе°Ҷдёәиҫ“еҮәзұ»еҲ«дёӯзҡ„жҜҸдёӘзұ»еҲҶй…ҚжҰӮзҺҮгҖӮеҹәдәҺиҝҷдәӣиҫ“еҮәжҰӮзҺҮпјҢжҲ‘们жңҖз»ҲеҸҜд»ҘеҜ№еӣҫеғҸеҒҡеҮәеҲҶзұ»гҖӮ

е…ЁиҝһжҺҘеұӮ

жңҖеҗҺзҡ„жЎҶжһ¶

еү©дёӢзҡ„е”ҜдёҖдёҖ件дәӢе°ұжҳҜжҠҠжүҖжңүиҝҷдәӣеӯҰеҲ°зҡ„жҰӮеҝөиҝӣиЎҢж•ҙзҗҶеҗҲ并пјҢиЎҢжҲҗжҲ‘们称д№Ӣдёәзҡ„еҚ·з§ҜзҘһз»ҸзҪ‘з»ңпјҢеҸҲеҗҚCNNгҖӮжң¬иҙЁдёҠпјҢCNNз”ұдёҖзі»еҲ—еҚ·з§ҜеұӮе’Ңжұ еҢ–еұӮз»„жҲҗпјҢиҝҷдәӣеұӮжңүйҖүжӢ©жҖ§зҡ„з»„еҗҲеңЁдёҖиө·пјҢз”ҹжҲҗдёҖдёӘзү№еҫҒеӣҫпјҢ然еҗҺе°ҶиҝҷдёӘеӣҫеҸҚйҰҲз»ҷе…ЁиҝһжҺҘеұӮпјҢд»Ҙз”ҹжҲҗзұ»зҡ„жҰӮзҺҮгҖӮиҝ”еӣһй”ҷиҜҜзҡ„иҫ“еҮәпјҢжҲ‘们е°ҶиғҪеӨҹиҝӣиЎҢжӣҙеҘҪзҡ„и®ӯз»ғд»Ҙз”ҹжҲҗеҮҶзЎ®зҡ„з»“жһңгҖӮ

зҺ°еңЁпјҢд»ҺеҠҹиғҪи§’еәҰжқҘи®©жҲ‘们ж·ұе…ҘдәҶи§ЈдёҖдёӢCNNжҳҜеҰӮдҪ•е·ҘдҪңзҡ„гҖӮ

еҚ·з§ҜзҘһз»ҸзҪ‘з»ң

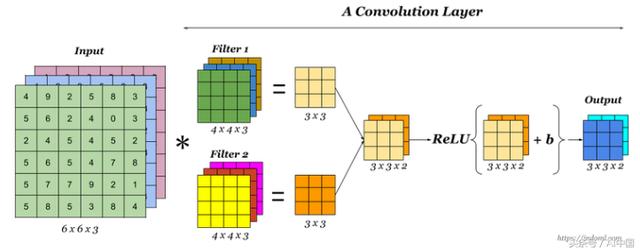

еҚ·з§ҜеұӮ

еҚ·з§ҜеұӮжҳҜCNNзҡ„дё»иҰҒз»„жҲҗйғЁеҲҶгҖӮжҜҸдёӘиҝҷж ·зҡ„еұӮз”ұдёҖз»„зӢ¬з«Ӣзҡ„ж»ӨжіўеҷЁз»„жҲҗпјҢжҜҸдёӘж»ӨжіўеҷЁеңЁз»ҷе®ҡзҡ„еӣҫеғҸдёӯеҜ»жүҫдёҚеҗҢзҡ„зү№еҫҒйӣҶгҖӮ

еҚ·з§Ҝиҝҗз®—

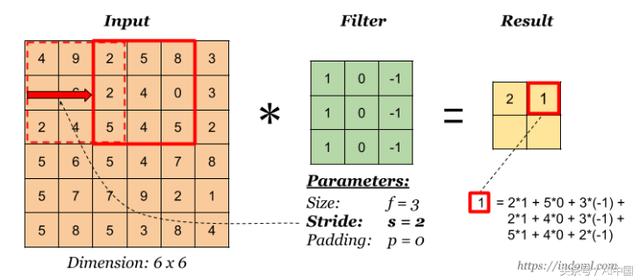

д»Һж•°еӯҰдёҠи®ІпјҢжҲ‘们еҸ–дёҖдёӘеӣәе®ҡеӨ§е°Ҹзҡ„ж»ӨжіўеҷЁпјҢ并еңЁе®Ңж•ҙзҡ„еӣҫеғҸдёҠж»‘еҠЁпјҢеңЁж»ӨжіўеҷЁе’Ңиҫ“е…ҘеӣҫеғҸеқ—д№Ӣй—ҙеҒҡзӮ№з§ҜгҖӮиҝҷдёӘзӮ№з§Ҝзҡ„з»“жһңе°ҶжҳҜдёҖдёӘж ҮйҮҸпјҢе®ғдјҡиҝӣе…ҘжңҖз»Ҳзҡ„зү№еҫҒжҳ е°„гҖӮ然еҗҺжҲ‘们еҗ‘еҸіж»‘еҠЁиҝҮж»ӨеҷЁпјҢжү§иЎҢзӣёеҗҢзҡ„ж“ҚдҪңпјҢ并е°Ҷз»“жһңж·»еҠ еҲ°зү№еҫҒеӣҫдёӯгҖӮеңЁе°Ҷе®Ңж•ҙзҡ„еӣҫеғҸдёҺиҝҮж»ӨеҷЁиҝӣиЎҢеҚ·з§ҜеҗҺпјҢжҲ‘们жңҖз»Ҳеҫ—еҲ°дёҖдёӘиЎЁзӨәдёҚеҗҢзү№еҫҒйӣҶзҡ„зү№еҫҒжҳ е°„пјҢиҜҘзү№еҫҒйӣҶе°ҶдҪңдёәдёӢдёҖеұӮзҡ„иҫ“е…ҘгҖӮ

жӯҘй•ҝ

ж»ӨжіўеҷЁз§»еҠЁзҡ„йҮҸе°ұжҳҜжӯҘй•ҝгҖӮеңЁдёҠйқўзҡ„еӣҫзүҮдёӯпјҢжҲ‘们зҡ„ж»‘еҠЁж»ӨжіўеҷЁзі»ж•°жҳҜ1гҖӮиҝҷеҸҜиғҪдёҚжҳҜжҲ‘们дёҖзӣҙйңҖиҰҒзҡ„гҖӮдҪҝз”ЁжӯҘй•ҝзҡ„еӨ§е°Ҹи·ҹзӣёйӮ»зҡ„еғҸзҙ й«ҳеәҰзӣёе…і(зү№еҲ«жҳҜеңЁжңҖеә•еұӮ)гҖӮеӣ жӯӨпјҢйҖҡиҝҮдҪҝз”ЁйҖӮеҪ“зҡ„жӯҘй•ҝжқҘеҮҸе°Ҹиҫ“еҮәзҡ„еӨ§е°ҸжҳҜжңүж„Ҹд№үзҡ„гҖӮ然иҖҢпјҢдёҖдёӘеӨ§зҡ„жӯҘй•ҝеҸҜиғҪдјҡеҜјиҮҙдҝЎжҒҜзҡ„й«ҳеәҰжҚҹеӨұгҖӮеӣ жӯӨпјҢжҲ‘们еңЁйҖүжӢ©жӯҘй•ҝж—¶еҝ…йЎ»е°ҸеҝғгҖӮ

жӯҘй•ҝдёә2

еЎ«е……

еҜ№жҹҗдёҖеҚ•еұӮиҝӣиЎҢеЎ«е……

жӯҘй•ҝзҡ„дёҖдёӘдёҚеҸ—ж¬ўиҝҺзҡ„зҗҶз”ұжҳҜйҡҸзқҖжҲ‘们дёҚж–ӯең°иҝӣиЎҢеҚ·з§ҜпјҢзү№еҫҒеӣҫзҡ„еӨ§е°ҸдјҡйҡҸд№ӢеҮҸе°ҸгҖӮиҝҷеҸҜиғҪдёҚжҳҜжҲ‘们жғіиҰҒзҡ„з»“жһңгҖӮеӣ дёә收缩д№ҹж„Ҹе‘ізқҖдҝЎжҒҜжҚҹеӨұгҖӮжғіиҰҒдәҶи§Јдёәд»Җд№ҲдјҡеҮәзҺ°иҝҷз§Қжғ…еҶөпјҢйӮЈиҜ·жіЁж„Ҹеә”з”ЁдәҺдёӯй—ҙеҚ•е…ғж је’Ңи§’иҗҪеҚ•е…ғж јзҡ„иҝҮж»Өж¬Ўж•°зҡ„е·®ејӮгҖӮжҳҫ然пјҢжқҘиҮӘдёӯй—ҙеҚ•е…ғж јзҡ„дҝЎжҒҜжҜ”иҫ№зјҳеҚ•е…ғж јзҡ„дҝЎжҒҜжӣҙйҮҚиҰҒгҖӮдёәдәҶдҝқз•ҷж—©жңҹеұӮеҶ…зҡ„жңүз”ЁдҝЎжҒҜпјҢжҲ‘们еҸҜд»Ҙз”Ё0еұӮеҢ…еӣҙз»ҷе®ҡзҹ©йҳөгҖӮ

еҸӮж•°е…ұдә«

дёәд»Җд№ҲCNNе·Із»ҸжңүдәҶдёҖдёӘеҫҲеҘҪзҡ„ж·ұеұӮзҘһз»ҸзҪ‘з»ңгҖӮжңүи¶Јзҡ„жҳҜпјҢеҰӮжһңжҲ‘们дҪҝз”Ёж·ұеәҰзҘһз»ҸзҪ‘з»ңжқҘиҝӣиЎҢеӣҫеғҸеҲҶзұ»пјҢжҜҸдёҖеұӮзҡ„еҸӮж•°ж•°е°ҶжҳҜCNNзҡ„ж•°еҚғеҖҚгҖӮ

еңЁCNNе…ұдә«еҸӮж•°

е…ҚиҙЈеЈ°жҳҺпјҡжң¬з«ҷеҸ‘еёғзҡ„еҶ…е®№пјҲеӣҫзүҮгҖҒи§Ҷйў‘е’Ңж–Үеӯ—пјүд»ҘеҺҹеҲӣгҖҒиҪ¬иҪҪе’ҢеҲҶдә«дёәдё»пјҢж–Үз« и§ӮзӮ№дёҚд»ЈиЎЁжң¬зҪ‘з«ҷз«ӢеңәпјҢеҰӮжһңж¶үеҸҠдҫөжқғиҜ·иҒ”зі»з«ҷй•ҝйӮ®з®ұпјҡis@yisu.comиҝӣиЎҢдёҫжҠҘпјҢ并жҸҗдҫӣзӣёе…іиҜҒжҚ®пјҢдёҖз»ҸжҹҘе®һпјҢе°Ҷз«ӢеҲ»еҲ йҷӨж¶үе«ҢдҫөжқғеҶ…е®№гҖӮ

жӮЁеҘҪпјҢзҷ»еҪ•еҗҺжүҚиғҪдёӢи®ўеҚ•е“ҰпјҒ