您好,登录后才能下订单哦!

密码登录

登录注册

点击 登录注册 即表示同意《亿速云用户服务条款》

这篇文章主要介绍了selenium怎么解决python爬虫乱码问题,具有一定借鉴价值,需要的朋友可以参考下。希望大家阅读完这篇文章后大有收获。下面让小编带着大家一起了解一下。

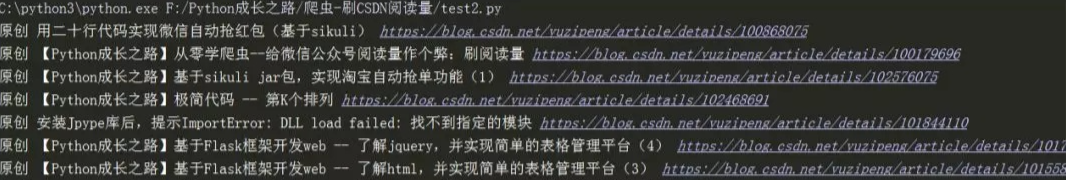

在用requests库对博客进行爬取时,发现乱码报错,如下图所示:

网上查找了一些方法,以为是遇到了网站加密处理。后来发现 通过F12还 是能获取网页的元素,那么有什么办法能规避乱码问题呢?答案是:用selenium.

效果如下

代码

# coding=utf-8

# @Auther : "鹏哥贼优秀"

# @Date : 2019/10/16

# @Software : PyCharm

from selenium import webdriver

url = 'https://blog.csdn.net/yuzipeng'

driver = webdriver.Chrome("F:\\Python成长之路\\chromedriver.exe")

driver.get(url)

urls = driver.find_elements_by_xpath('//div[@class="article-item-box csdn-tracking-statistics"]')

blogurl = ['https://blog.csdn.net/yuzipeng/article/details/' + url.get_attribute('data-articleid') for url in urls]

titles = driver.find_elements_by_xpath('//div[@class="article-item-box csdn-tracking-statistics"]/h5/a')

blogtitle = [title.text for title in titles]

myblog = {k:v for k,v in zip(blogtitle,blogurl)}

for k,v in myblog.items():

print(k,v)

driver.close()感谢你能够认真阅读完这篇文章,希望小编分享selenium怎么解决python爬虫乱码问题内容对大家有帮助,同时也希望大家多多支持亿速云,关注亿速云行业资讯频道,遇到问题就找亿速云,详细的解决方法等着你来学习!

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。