您好,登录后才能下订单哦!

小编给大家分享一下python爬虫怎么采集知乎信息汇总,相信大部分人都还不怎么了解,因此分享这篇文章给大家参考一下,希望大家阅读完这篇文章后大有收获,下面让我们一起去了解一下吧!

在没有学习python之前,对于数据的提取只局限于复制、粘贴之后的保存,一步步的人工操作还是很慢的。现在的小编已经能够写代码去从网页上获取自己想要的内容了,学习成果方面还是有显著的变化。不知道小伙伴们是不是都会呢?本篇小编就以知乎的数据采集为例,让大家也练练手。

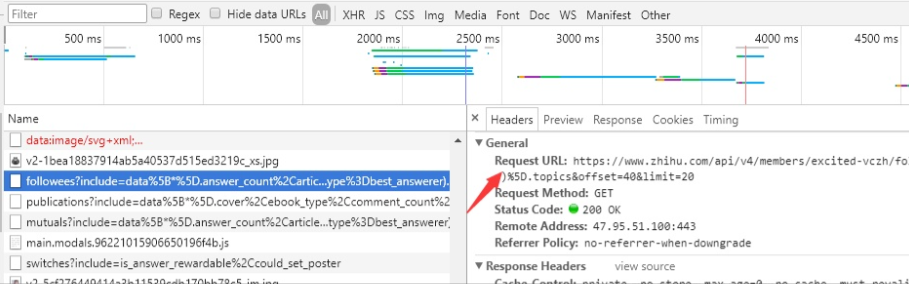

打开知乎首页-->登陆-->搜索到一个大V,用谷歌浏览器分析点击关注了哪些人后的请求,通过分析:查找他关注的人的请求链接:

https://www.zhihu.com/api/v4/members/excited-vczh/followees?include=data%5B

通过观察尝试分析后可知:offset=40是偏移量,通过改变这个值可以实现分页的效果。

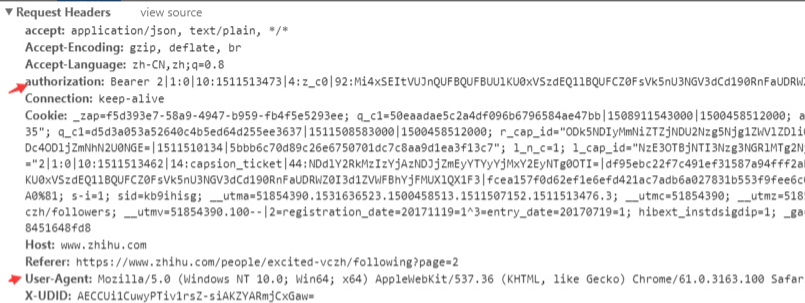

知乎是做了反爬虫的措施的,所以我们要想爬取知乎信息,还必须要设置请求头,下面我们来分析请求头:

图片中红箭头所指就是请求必须需要的值,

authorization:是身份认证信息,每个用户登录后都会产生各自的身份认证信息。

User-Agent:是验证请求是来自正常的浏览器访问

最终代码如下:

import requests

import pandas as pd

import time

headers={

'authorization':'',#此处填写你自己的身份验证信息

'User-Agent':''#此处填写你自己浏览器的User-Agent

}

user_data = []

def get_user_data(page):

for i in range(page):#翻页

url = 'https://www.zhihu.com/api/v4/members/excited-vczh/followees?include=data%5B*%5D.answer_count%2Carticles_count%2Cgender%2Cfollower_count%2Cis_followed%2Cis_following%2Cbadge%5B%3F(type%3Dbest_answerer)%5D.topics&offset={}&limit=20'.format(i*20)

response = requests.get(url, headers=headers).json()['data']

user_data.extend(response) #把response数据添加进user_data

print('正在爬取第%s页' % str(i+1))

time.sleep(1) #设置爬取网页的时间间隔为1秒

if __name__ == '__main__':

get_user_data(10)

df = pd.DataFrame.from_dict(user_data)#以字典保存数据

df.to_csv('zhihu.csv',encoding='utf_8_sig')#保存到用户名为zhihu的csv文件中,encoding='utf_8_sig'参数是为了解决中文乱码的问题

print(df)以上是python爬虫怎么采集知乎信息汇总的所有内容,感谢各位的阅读!相信大家都有了一定的了解,希望分享的内容对大家有所帮助,如果还想学习更多知识,欢迎关注亿速云行业资讯频道!

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。