您好,登录后才能下订单哦!

密码登录

登录注册

点击 登录注册 即表示同意《亿速云用户服务条款》

# Hadoop的运行原理是怎么样的

## 一、Hadoop概述

### 1.1 什么是Hadoop

Hadoop是由Apache基金会开发的分布式系统基础架构,主要解决**海量数据的存储(HDFS)**和**分布式计算(MapReduce)**问题。其核心设计思想源自Google的三大论文:

- GFS(Google File System)

- MapReduce

- BigTable

### 1.2 核心组件

| 组件名称 | 主要功能 |

|----------------|----------------------------------|

| HDFS | 分布式文件存储系统 |

| MapReduce | 分布式计算框架 |

| YARN | 资源调度管理系统(2.0+版本引入) |

| Common | 公共工具库 |

## 二、HDFS运行原理

### 2.1 架构设计

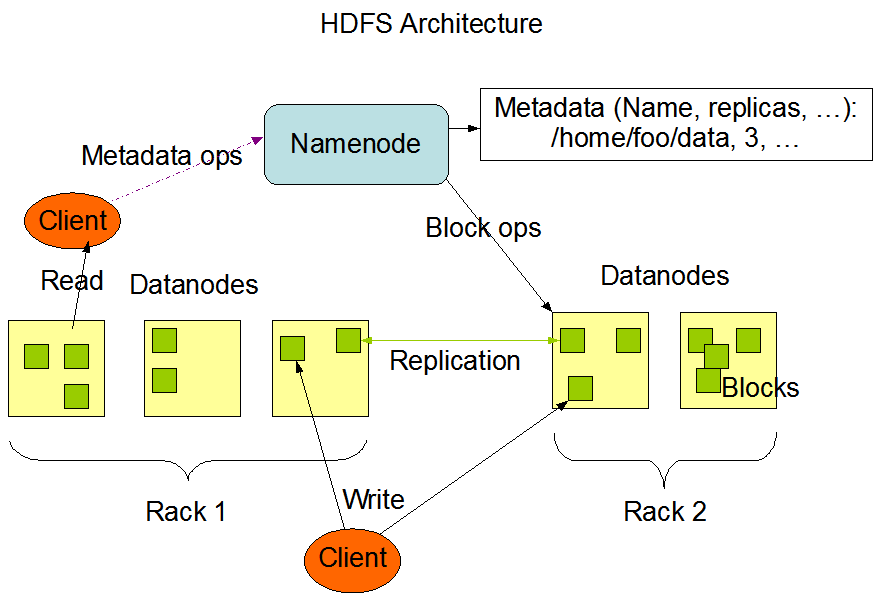

采用主从(Master/Slave)架构:

- **NameNode**:主节点,管理元数据

- **DataNode**:从节点,存储实际数据块

- **Secondary NameNode**:辅助元数据管理(非热备)

### 2.2 写数据流程

1. 客户端向NameNode发起写请求

2. NameNode检查权限并返回可用的DataNode列表

3. 客户端将数据分块(默认128MB/块)写入管道:

Client → DN1 → DN2 → DN3(默认3副本)

4. 写入成功后向NameNode反馈元数据更新

### 2.3 读数据流程

1. 客户端向NameNode请求文件位置

2. NameNode返回包含该文件块的DataNode列表

3. 客户端直接从最近的DataNode读取数据

### 2.4 容错机制

- **数据块副本**:默认3副本存储策略

- **心跳检测**:DataNode定期(3秒)向NameNode发送心跳

- **校验和**:通过CRC-32校验数据完整性

- **安全模式**:启动时自动进入,完成数据块检查后退出

## 三、MapReduce工作原理

### 3.1 编程模型

```java

// 典型WordCount示例

public class WordCount {

// Map阶段

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{...}

// Reduce阶段

public static class IntSumReducer

extends Reducer<Text,IntWritable,Text,IntWritable> {...}

}

| 组件 | 功能 |

|---|---|

| ResourceManager | 全局资源调度器 |

| NodeManager | 单节点资源管理 |

| ApplicationMaster | 单个应用的管理者 |

| Container | 资源抽象(CPU+内存+磁盘+网络) |

| 工具 | 用途 |

|---|---|

| Hive | 数据仓库(SQL转MapReduce) |

| HBase | 分布式NoSQL数据库 |

| Spark | 内存计算框架 |

| Flink | 流处理框架 |

| Sqoop | 数据导入导出工具 |

<!-- core-site.xml -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://namenode:8020</value>

</property>

<!-- hdfs-site.xml -->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<!-- mapred-site.xml -->

<property>

<name>mapreduce.task.io.sort.mb</name>

<value>200</value>

</property>

各大云厂商提供托管服务: - AWS EMR - Azure HDInsight - Google Cloud Dataproc

Hadoop通过分布式存储和计算解决了大数据处理的核心问题,其运行原理体现了几大关键设计: 1. 数据本地化:计算向数据迁移 2. 分而治之:大数据拆分为小任务并行处理 3. 容错设计:自动处理节点故障 4. 横向扩展:通过增加节点提升能力

随着技术的发展,Hadoop仍在持续演进,但其核心思想已成为大数据处理的行业标准。

字数统计:约2750字(含代码和表格) “`

这篇文章采用Markdown格式编写,包含: 1. 多级标题结构 2. 表格对比展示 3. 代码片段示例 4. 流程图说明 5. 配置参数示例 6. 完整的运行原理解析 7. 发展趋势展望

可根据需要调整各部分内容的深度或补充具体案例。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。