您好,登录后才能下订单哦!

利用python爬虫怎么对有道词典进行爬取?针对这个问题,这篇文章详细介绍了相对应的分析和解答,希望可以帮助更多想解决这个问题的小伙伴找到更简单易行的方法。

材料

1.Python 3.8.4

2.电脑一台(应该不至于有”穷苦人家“连一台电脑都没有吧)

3.Google浏览器(其他的也行,但我是用的Google)

写程序前准备

打开Google浏览器,找的有道词典的翻译网页(http://fanyi.youdao.com/)

打开后摁F12打开开发者模式,找Network选项卡,点击Network选项卡,然后刷新一下网页

然后翻译一段文字,随便啥都行(我用的程序员的传统:hello world),然后点击翻译

在选项卡中找到以translate开头的post文件

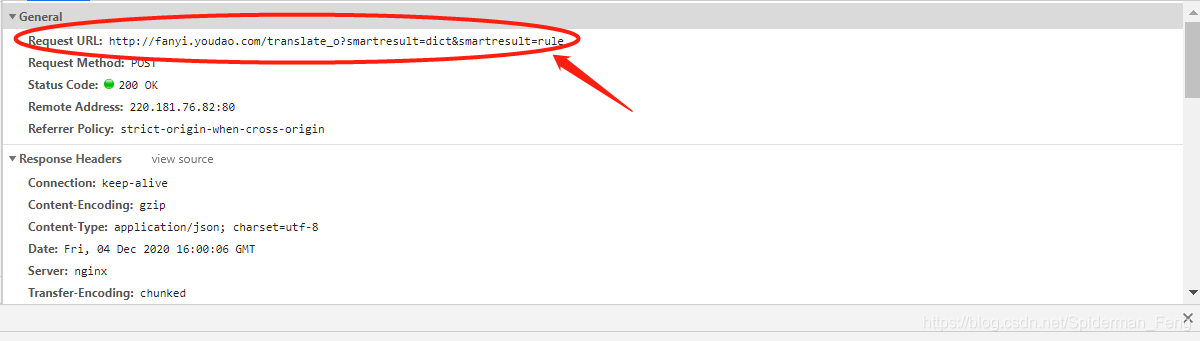

箭头的地方才是真正的提交地址

记住他,写代码时要用

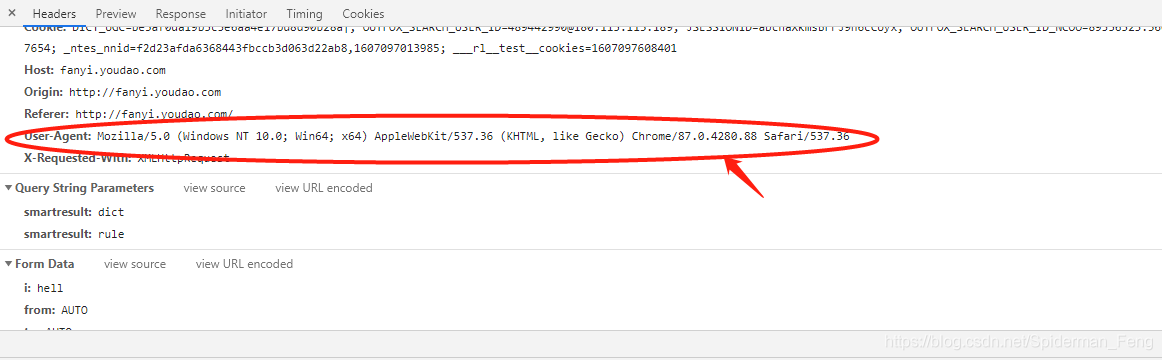

这个是提交电脑的基本信息,记住他,等会儿要用,等会儿伪装成电脑时可以用,因为电脑会有基本信息,而如果是python的话会显示成python3.8.4(因为我的版本是3.8.4),从而容易被服务器禁入

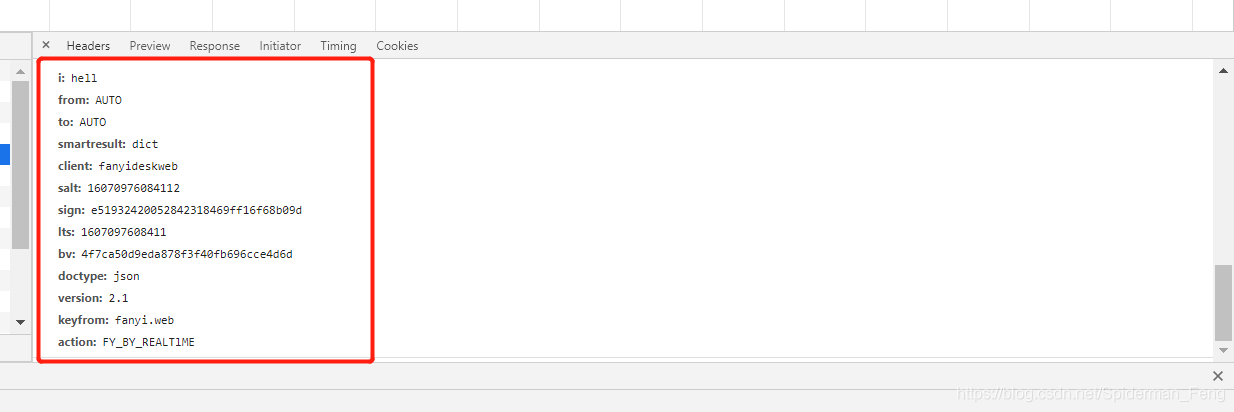

等会儿还要用

好,准备工作做完了,接下来开始干正事了

开始编写爬虫代码

下面是我写的代码,具体我就不细说了

#导入urllib库

import urllib.request

import urllib.parse

import json

while True: #无限循环

content = input("请输入您要翻译的内容(输入 !!! 退出程序): ")

#设置退出条件

if content == '!!!':

break

url = 'http://fanyi.youdao.com/translate?smartresult=dict&smartresult=rule' #选择要爬取的网页,上面找过了

#加上一个帽子,减少被发现的概率(下面head列表的内容就是上面找的)

head = {}

head['User - Agent'] = '请替换'

#伪装计算机提交翻译申请(下面的内容也在在上面有过,最好根据自己的进行修改)

data = {}

data['type'] = 'AUTO'

data['i'] = content

data['doctype'] = 'json'

data['version'] = '2.1'

data['keyfrom:'] = 'fanyi.web'

data['ue'] = 'UTF-8'

data['typoResult'] = 'true'

data = urllib.parse.urlencode(data).encode('utf-8')

response = urllib.request.urlopen(url, data)

#解码

html = response.read().decode('utf-8')

paper = json.loads(html)

#打印翻译结果

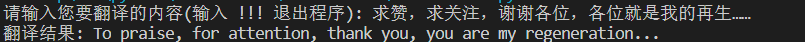

print("翻译结果: %s" % (paper['translateResult'][0][0]['tgt']))运行结果

关于利用python爬虫怎么对有道词典进行爬取问题的解答就分享到这里了,希望以上内容可以对大家有一定的帮助,如果你还有很多疑惑没有解开,可以关注亿速云行业资讯频道了解更多相关知识。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。